AI的失效不可避免。营销人员必须认识到,那些在当下能够促进AI推广的营销手段——特别是过度宣扬产品优势和优越性的做法,很可能在AI出现失误时引发严重后果。因此,在制定营销策略前,务必充分理解与AI相关的五大陷阱。企业仔细评估这些风险后制定相应的市场营销策略,既能实现当前的产品推广目标,又可以在将来出现失效情况时,降低法律责任和品牌声誉风险。

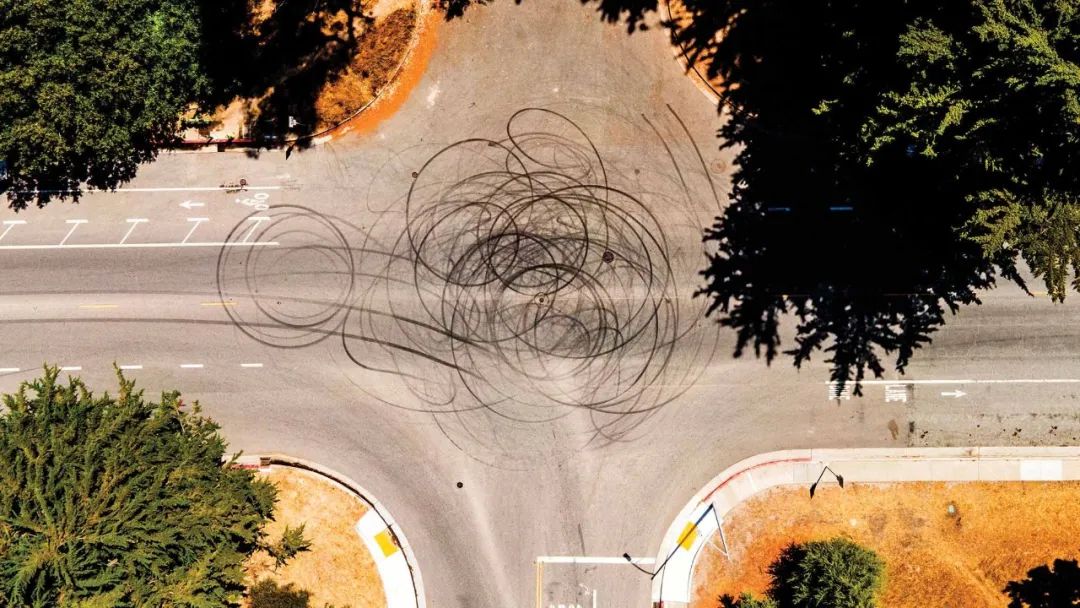

2023年10月,一辆自动驾驶汽车在美国旧金山发生了一起严重的交通事故,该自动驾驶汽车由通用汽车旗下的自动驾驶出租车公司Cruise运营。当时,一辆由人类驾驶的日产汽车与行人发生碰撞,该行人被撞后,被抛到了行驶中的自动驾驶汽车面前。

独立工程顾问对这起事故的调查结果显示,在当时的情况下,即便由最谨慎的人类司机驾驶,涉事车辆也无法及时转向避开行人。但在Cruise最初向监管机构提交的报告中,却遗漏了一个关键事实:碰撞发生后,该行人被卷入车底又拖行了约6米远。这位女性行人受伤严重,但最终得以幸存。

尽管这起碰撞事故责任不在Cruise,但事故仍引发了公司危机。该公司因未能及时报告事故相关信息,被美国国家公路交通安全管理局(NHTSA)处以150万美元罚款。此外,美国司法部还对事故展开了刑事调查,最终Cruise支付了50万美元罚款以达成和解。然而,事情并没有就此结束。Cruise在旧金山的运营许可证被吊销。公司半数员工被裁撤,CEO辞职,公司估值缩水超过50%。整个自动驾驶汽车行业也受到波及。事发后不过数月,一辆Alphabet旗下的Waymo无人驾驶出租车在旧金山遭到人群袭击并被纵火焚烧,美国国家公路交通安全管理局还对Waymo和亚马逊旗下的Zoox等多家自动驾驶技术公司展开调查。2024年底,通用汽车宣布完全终止其对自动驾驶出租车业务的开发。

从汽车到聊天机器人,AI应用正在各个领域快速铺开。但Cruise的案例揭示了一个残酷现实:AI迟早会“翻车”。当这种情况发生时,涉事AI所属的组织(无论是自己研发AI系统的组织,还是整合他人AI系统的公司),都难免成为众矢之的。人们在推广AI以促进其普及方面已经做了不少文章,但很少有人关注该如何在营销的同时,为不可避免的技术“翻车”情况留好后手。

过去七年间,我从市场营销的角度出发,开展了七项关于AI失效风险的研究。通过这些研究,我提炼出了消费者对AI失效的认知和反应模式。敏锐的营销人员必须注意,消费者的态度中隐藏着五大陷阱——这些陷阱在AI出错之前和之后都可能出现。在本文中,我将探讨企业应如何做好AI失效的应对准备,以及当AI真的“翻车”后该如何补救。我会分析企业营销AI的方式是否存在风险,详细介绍一些组织应对AI失效事件的案例,并为希望在推广AI系统的同时保护品牌、增强消费者信任的管理者提供实用建议。下面让我们逐一剖析这五大陷阱。

人们有事先怪AI

为了深入理解公众和监管机构对Cruise事件强烈反应的发生机理,我和同事开展了一项涵盖5000多名参与者的研究。我们向参与者展示了一个与Cruise案例类似的事故情境:一位人类司机驾车撞飞一名行人,该行人被抛向另一辆无责车。其中一组参与者被告知这辆无责车是自动驾驶的,另一组则被告知无责车由人类驾驶。随后,我们请参与者评估车辆制造商应在多大程度上承担责任。

结果表明,就算涉事车辆客观上无论如何也无法避开相撞,“自动驾驶组”受访者认为车企应负责任的程度仍显著高于“人类驾驶组”。受访者还判定,就算具备自动驾驶功能的无责车事发时正由人类驾驶者控制,车企的责任也依然更大。该结果已被中国的一支独立研究团队重复验证,表明上述偏见在不同文化背景下均存在。

在这些案例中,责任被错置的原因是受访者受到“自动驾驶汽车”这个新奇概念的诱导,开始想象如果不存在自动驾驶汽车,事情会如何发展。值得注意的是,在这种情况下,他们往往设想一个“完美”司机会怎么做,从而对AI设定了超过合理范围的高标准。他们会得出结论,认为自动驾驶汽车本可以通过某种方式提前转向规避碰撞,而这在现实中根本不可能实现。这种违背事实的设想导致他们倾向于认为,自动驾驶系统比处于同样情境中的人类司机更应对事故负责。

在后续测试中,我们发现将关注焦点转移到肇事司机(最初引发事故的一方)身上,能够有效降低受访者对AI的指责程度。当人们的注意力从“自动驾驶”的噱头转移到其他显著因素时,就不太会去“脑补”脱离实际的场景。但必须注意的是,转移人们对新技术的关注不应被误解为刻意误导利益相关方:企业高管不应隐瞒AI在事故中表现的详细情况。Cruise公司高层只强调了人类司机的过错,却没有披露其车辆拖拽行人造成二次伤害的情况。当这一事实被揭露后,Cruise不仅失去了对媒体舆论的掌控,更严重损害了监管机构对其的信任。

一家AI“翻车”,整个行业“躺枪”

Cruise事件对Waymo、Zoox等其他企业造成的连锁反应,揭示了与AI失效相伴的次生风险:当某家公司的AI出现问题时,人们往往会认为其他公司的AI系统同样存在缺陷。这种“污染效应”(contamination effect)可能会对公众对各类AI技术的认知造成负面影响。

基亚拉·隆戈尼(Chiara Longoni)教授、卢卡·奇安(Luca Cian)教授和艾莉·耿(Ellie Kyung)教授合作开展的一项研究很好地体现了“污染效应”的发生机制。他们首先向3724名参与者讲述了一个失误案例:美国阿肯色州相关部门没有按规定给一位残障人士发放福利金。一组受访者被告知这是人类员工的失误,另一组则被告知是算法的问题。随后,研究人员询问受访者:在另一个州(美国肯塔基州),由相关部门员工或算法处理福利分配时,是否也可能会犯类似错误?结果显示,受访者更倾向于认为,肯塔基州的预测算法也会出错,而非人类员工。研究人员还在多种其他AI失效场景下,如误发社保金等,发现同样存在这种对AI更高的“连带怀疑”倾向。

研究人员发现,受访者之所以会有这样的反应,是因为大多数人并不了解AI的工作原理。他们倾向于认为“天下AI是一家”,具有相同的基本特性;他们不会把一个个AI方案视为各有长短,互不相干的独立系统。

为避免其他公司AI失效造成的连带影响,企业应重点突出与竞争产品相比,自身的差异化优势,包括专有算法、安全防护措施和人类监管等。以AI公司Anthropic及其生成式AI模型Claude为例,该公司将其产品定位为“新一代AI助手...经过训练确保安全、准确和可靠,以帮助用户发挥出最佳工作表现”。Anthropic表示,他们采用“宪法”式训练方法,使Claude更加透明、更易理解,并且符合人类价值观。通过这样的差异化定位,Anthropic将Claude与ChatGPT、Bard等采用不同训练方式的主流竞品区分开来。当这些竞争对手产品因存在偏见或生成不准确信息而出现问题时,Anthropic通过前期建立的差异化基础,可以有效降低潜在连带影响。

另一项预防措施是明确告知AI决策过程中存在人类监督环节,即由人类决定是否采纳AI的建议。当在“人类参与其中”(human in the loop)机制下出现失误时,公众通常不会认为其他AI系统也同样存在缺陷。这很可能是因为人们不会将此类失误简单归咎于AI技术本身。

企业夸大AI能力会招致更严厉指责

特斯拉将其驾驶辅助系统命名为“Autopilot”(自动驾驶),但实际使用仍需驾驶员在道路上进行主动监督。在发生多起涉及启用Autopilot功能的致命事故后,这家汽车制造商陷入了一系列诉讼纠纷,其中包括美国司法部对其产品命名是否构成“误导性营销”的调查。美国国家公路交通安全管理局也要求特斯拉确保其在对外宣传中,更准确反映系统的实际能力与局限。特斯拉CEO埃隆·马斯克过去曾为“Autopilot”这一称谓辩护,称其借鉴自航空领域,飞机上的“Autopilot”功能仅作为飞行员的辅助工具,而非完全自主的系统。但消费者是否也会这样理解呢?

我和同事就“误导性表述”问题开展了一项研究,针对9492名参与者,结合模拟驾驶和假设性事故情境展开测试。我们告知参与者,某车企计划推出一款新型自动驾驶汽车。其中一组被告知该车具有“Autopilot”系统(“自动驾驶”,暗示高阶AI能力),另一组则被告知该车具有“Copilot”系统(“副驾驶”,暗示中等程度的AI能力)。随后,参与者被置于一个模拟驾驶场景中,要求根据自身判断,在他们认为需要干预时随时接管方向盘。在模拟过程中,当车辆驶向一个繁忙的十字路口时,若不及时干预,车辆将会撞向乱穿马路的行人。

结果表明,标注“Autopilot”的车辆,参与者接管控制的时机明显晚于标注“Copilot”的车辆。这意味着命名方式直接影响参与者的安全意识——他们在名称引导下认为车辆的能力越强,自己介入控制的时机就会越晚。在其他研究中我们也发现,企业给产品起的名字越是暗示其性能优越,人们就越倾向于认为企业对事故负有责任。这表明,夸大命名一方面降低了消费者的警惕性,另一方面也抬高了事故后人们对车企的责任预期。

基于上述研究结果,我和同事提出一个假设:在AI产品营销中,常见的“宣称自家产品优于竞争对手”的营销策略,在AI失效时可能会适得其反。后续研究证实了这一假设:当企业这样宣传时,会抬高消费者对系统能力的预期,从而在出现故障时招致更严厉的责任认定。例如,通用汽车曾使用“人类是很糟糕的司机”这类广告语,可能反而加剧了消费者在Cruise卷入事故时对其的责难。

这种现象的产生源于AI系统存在一个从“部分自主”(人类承担主要操作责任)到“完全自主”(AI全权控制)的能力谱系。然而大多数消费者难以准确判断具体AI产品在这个谱系中的实际位置。这种认知鸿沟给营销人员带来了两难困境:虽然实话实说能反映系统真实水平,但企业往往倾向于使用夸大性能的表达来促进销售。

若企业选择使用具有误导性的AI产品名,则应该在其他渠道(如官网或产品上的小字)准确清晰地阐明AI的真实能力。研究发现,相比单纯使用误导性命名的企业,那些在误导性命名的同时披露AI实际能力的企业,在系统失效时面临的追责更轻。当然,另一种选择是从源头避免使用误导性命名。这种做法虽然无法增强消费者对AI能力的认知,但至少能完全规避相关风险。

人们对拟人化AI的评判更加严苛

如今,越来越多的企业开始部署具有人类特征的AI系统。心理健康应用Wysa使用卡通形象帮助用户完成练习,而像Replika这样的AI伴侣应用则采用能表达“情感”和“思考”的真人形象。

这些设计元素会让用户产生错觉,以为聊天机器人真的具备情感、目标和欲望等它实际上并不存在的特质。与中性机器人相比,拟人化设计能为企业带来多重优势:显著提升消费者的购买意愿、信任程度、品牌忠诚度,以及配合服务商要求和披露个人信息的意愿。值得注意的是,即便用户明知交谈对象是机器,这种拟人化效应依然存在。

在拉吉·斯里尼瓦桑(Raji Srinivasan)教授和居伦·萨里亚尔-阿比(Gülen Sarial-Abi)教授开展的研究中,他们告知参与者一家金融投资公司因失误导致客户蒙受损失。一组参与者获悉失误原因是“算法程序”出错,另一组则得知肇事者是一个名为“查尔斯”的拟人化AI。结果显示,当失误归因于拟人化AI时,参与者对品牌的负面评价更为强烈。后续研究表明,拟人化设计会让人们以为AI具备记忆、理解、规划和思考等心智能力,进而对其失误施加更高的责任认定。另一项由卡米·克罗利克(Cammy Crolic)主导的研究发现:当聊天机器人同时采用语言(如使用第一人称、自称“杰米”)和视觉(女性形象)拟人化特征时,其服务失败引发的负面评价比仅采用语言拟人化时更为严重。这证明不同类型的拟人化特征会叠加放大用户对AI失效的负面反应。

在客户可能产生激烈情绪的场景中,使用聊天机器人时要格外谨慎。在克罗利克团队开展的另一项研究中,研究人员分析了某国际电信公司约50万次的客服对话记录,发现顾客越是以对待人类的方式与机器人互动(如在对话中直呼机器人名字),在生气时对公司的不满情绪就越重。要减轻这种效应,可以有选择性地仅在产品搜索等中性场景使用拟人化机器人,而在客服等易引发顾客愤怒的环节减少拟人化AI的使用频率。企业方面还可以在对话伊始就主动降低预期,例如Slack的聊天机器人会声明:“你好,我是Slackbot。我尽力提供帮助(但我只是个机器人,抱歉!)。”这类“丑话说在前面”的机器人在出现服务失误时就不那么容易激怒顾客。

人们对预设偏好感到愤怒

2016年,梅赛德斯-奔驰一位高管表示,在开发自动驾驶汽车时,公司将优先保护车内乘客而非行人和其他道路使用者的安全。其逻辑很直接:若只能救一人,应该救车内人员。这番言论引发了舆论风暴,某报纸头条直接指责奔驰为了保护司乘人员,“宁愿碾过儿童也不肯转向”。事发后不过几周时间,奔驰做了公开澄清,称工程师和自动驾驶系统都不应对人类生命价值做出评判。这一事件激起的公众情绪表明,人们认为企业将基于年龄、性别或用户身份等群体特征预设的偏好植入AI系统是不道德的。

为验证这一假设,我与哈佛大学的米娜·奇卡拉(Mina Cikara)教授合作开展了研究。我们让826名来自美国的参与者设想一辆全自动驾驶汽车面临的各种道德困境,比如是撞向一位老人还是一名儿童,然后我们呈现出最终撞上其中一类人的情景。我们控制的关键变量在于:车辆的选择是随机的,还是基于预设的群体偏好。研究发现,相比随机选择,任何预设的群体偏好都会引发更强烈的愤怒情绪。这表明企业应避免公开宣扬其系统内存在基于群体特征的决策逻辑。某些情况下,甚至需要从一开始就避免收集种族、性别、年龄等可能影响AI决策的特征数据。另一种方式是采用情境结构特征作为决策依据,比如让系统优先采用能拯救更多人的方案。约哈南·比格曼(Yochanan Bigman)和库尔特·格雷(Kurt Gray)的研究发现,相比群体偏好,公众更支持AI使用基于结构特征的决策逻辑。这可能是因为结构偏好具有明确的功利主义合理性,更容易获得普遍认同。

AI的失效不可避免。营销人员必须认识到,那些在当下能够促进AI推广的营销手段——特别是过度宣扬产品优势和优越性的做法,很可能在AI出现失误时引发严重后果。因此,在制定营销策略前,务必充分理解与AI相关的五大陷阱。企业仔细评估这些风险后制定相应的市场营销策略,既能实现当前的产品推广目标,又可以在将来出现失效情况时,降低法律责任和品牌声誉风险。

朱利安·德弗雷塔斯(Julian De Freitas)| 文

朱利安·德弗雷塔斯是哈佛商学院市场营销教研室副教授。

DeepSeek | 初译 高晓萌 | 译校 廖琦菁 | 编辑

本文选自《哈佛商业评论》中文版2025年8月刊。