Scaling Law撞墙了,这话AI圈已经听了一年多。

从Gary Marcus的减收益批评,到坊间关于 OpenAI下一代模型“Orion” 进展不顺的传闻,再到 GPT-5 发布时不少人感到“并不惊艳”。进步是有的,但没有那种让人眼前一亮的跃升。连 Ilya 都说,我们正从扩展时代回到研究时代。大力出奇迹的配方,似乎真的到头了。

然后Gemini 3来了。Gemini 3 不只是变强,而是跨越了过去两年 Google 所有被批评的点,第一次在全面维度,能力、推理、速度、成本、生态,真正追上和整体超越 OpenAI。看不到任何墙。

关键是,Gemini 3不是靠换一套全新架构做到的。Google说,突破来自预训练和后训练两个阶段的配方升级。具体怎么升级的,外界只能猜测,也许是Google积累了25年的独家数据终于派上用场,也许是找到了处理数据的新技术。但不管原因是什么,Google愿意公开说"预训练仍有改进空间",这本身就是一个信号:Scaling的两条主线:预训练和后训练,都还没走到头。

大模型训练变成了“重资产游戏”

Gemini联合负责人Oriol Vinyals说得更直接:2.5到3.0之间的性能跃迁是他们见过最大的一次,“看不到任何墙”。

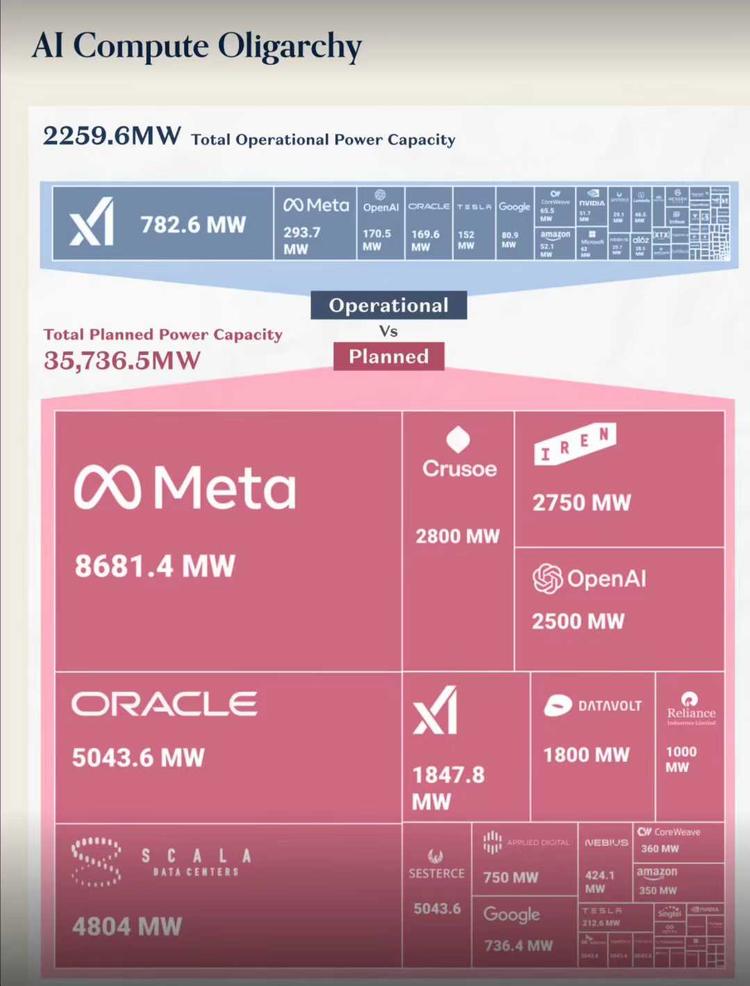

同一时间,马斯克的xAI宣布其超算集群Colossus已扩展到20万块GPU,目标是100万块。OpenAI、Anthropic、微软也在砸下数千亿美元扩建数据中心。

如果Scaling Law真的死了,这些人在赌什么?

墙不存在

先看最直接的证据。

Gemini 3证明了算法改进遇上更好的算力,预训练Scaling依然有效。前DeepMind的研究科学家Oriol Vinyals把Gemini 3的提升归功于预训练和后训练的双重改进,不是换了一套全新的方法论,而是把现有方法做得更好,换句话说,不是Scaling不行了,是之前的方法还不够好。

黄仁勋提出了一个更系统的框架:现在有三条Scaling曲线同时在起作用,预训练Scaling、后训练Scaling、以及推理时Scaling(test-time compute)。传统的预训练Scaling是用更多数据和算力训练更大的模型;后训练Scaling是通过RLHF、DPO等技术在训练后继续优化;推理时Scaling则是让模型在回答问题时花更多时间“思考”,比如OpenAI的o1系列。

Sam Altman在2025年初的博客里写得更直白。他说,模型的智能水平大致等于用于训练和运行它的资源的对数。这听起来像是坏消息,但反过来理解,只要你愿意持续投入,模型就会持续变好。曲线没有弯曲,只是斜率需要用对数坐标来理解。

Google DeepMind的CEO Demis Hassabis态度同样明确。他在一次公开活动上说,现有系统的扩展必须推到极限,因为它至少会是最终AGI系统的关键组成部分,甚至可能就是全部。

如果Scaling Law真的撞墙了,你很难解释为什么整个行业还在以前所未有的速度往里砸钱。这些人在赌什么?即使退一步说,算力可以用于推理而非训练,但这种规模的投入也需要模型能力的持续提升来支撑,否则推理什么呢,一个能力停滞的模型,值得为它建造价值万亿美元的基础设施吗?

他们吵的不是同一件事

不过,如果你仔细听各方的表态,会发现一个有意思的现象,大家嘴里说的Scaling Law,可能根本不是同一个东西。

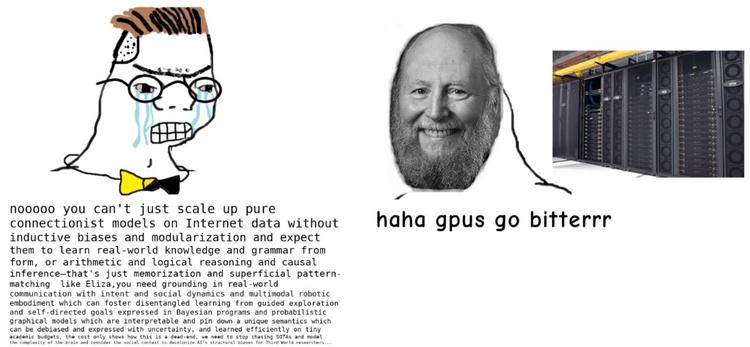

传统意义上的Scaling Law很简单:更多数据、更大模型、更多算力,等于更强性能。这是2020年OpenAI那篇著名论文确立的范式,也是过去几年大模型竞赛的底层逻辑。如果你说的是这条曲线,那确实在放缓。数据快被用完了,单纯堆参数的边际收益在下降,这是事实。

但现在行业里讨论的Scaling,早就不只是这一个维度了。

黄仁勋提出的三阶段框架就是一个例子。预训练是第一阶段,相当于让模型上大学,获取广泛的基础知识。后训练是第二阶段,相当于读研,针对特定领域深造。测试时计算是第三阶段,相当于让模型在回答问题之前先想一想,而不是脱口而出。o1、DeepSeek-R1这些推理模型的出现,本质上就是在第三阶段做文章。

还有一个更有意思的视角,来自IBM的一档播客Mixture of Experts。几位嘉宾讨论Gemini 3的时候提出了一个观点:我们是不是应该把它叫做Scaling Experimentation Law,而不是Scaling Law?他们的意思是,算力增加的真正作用,不是直接转化成智能,而是让研究人员能够更快地跑实验、试错、迭代。更多的算力等于更快的实验速度,等于更好的算法,最终等于更强的模型。这才是Scaling的真正含义。所以哪怕继续Scale的收益下降,头部公司也有不能不跟的博弈压力。

从这个角度看,Ilya Sutskever说的回归研究时代,和其他人说的Scaling Law没死,其实并不矛盾。Ilya的意思是,那个简单粗暴的配方用完了,不能再指望光靠堆资源就能出奇迹。但他从来没说算力不重要,他说的是我们带着大型计算机回到了研究时代。算力是前提,但不再是唯一的变量。

当然,Ilya的表态也不能完全当作纯粹的技术判断来听。他现在在做Safe Superintelligence,走的是少商业化、重基础研究的路线。说扩展时代结束、研究时代回归,某种程度上也是在为自己的新公司找一个差异化的叙事。

所以,与其问Scaling死没死,不如问,哪条曲线在放缓、哪条曲线在加速。

各方立场

说到立场和利益,这场争论里每个人的位置其实都很清楚。

英伟达是最明显的。无论Scaling Law怎么演变,无论你是堆预训练、堆后训练还是堆推理,都需要GPU。三条曲线变成一条还是十条,对他来说没区别,只要大家还在Scaling,他就是卖铲子的那个人。所以他当然要说没死,而且要说还有三条。

OpenAI、Google、Anthropic这些模型公司也是一样。他们正在建造或者规划中的数据中心,投资规模是百亿甚至千亿美元级别的。这些钱已经花出去了,或者已经承诺出去了。这时候说Scaling Law失效,相当于说自己在做一笔糟糕的投资。从公司利益的角度,他们必须相信,也必须让投资人相信,Scaling仍然有效。

马斯克的xAI也是这个逻辑。他多次警告,目前 AI 最大的中长期瓶颈会从芯片,转向电力生产和电网,数据中心和 AI 集群会在未来几年吃掉极其可观的全球电力,对电网形成硬约束。再结合他疯狂堆GPU、建算力超级工厂/超级集群的行为,很难说他主观上相信再堆算力也没什么提升。

看起来站在另一边的是Ilya和他的SSI。但仔细想想,他的位置其实也合理。SSI融资规模和OpenAI、Google不在一个量级,拼算力拼不过。这时候说Scaling时代结束、研究突破更重要,既是技术判断,也是竞争策略。他需要让投资人相信,有另一条路可以通向超级智能,而那条路也许不需要万亿美元的基础设施。

另一种是“世界模型派”,Yann LeCun和李飞飞都认为靠现在这一套 LLM 路线,怎么 scale 都很难做出真正AGI。Yann LeCun创办了一家专注世界模型的公司AMI,他认为LLM很有用,但只是“高级自动补全”,真正通用的智能需要世界模型 + 自监督学习 + 规划 + 持久记忆 + 具身交互 的新架构。

李飞飞创立的 World Labs 把赌注压在 world models 和空间智能上,主攻能重建和生成 3D 世界的基础模型,而不是再做一套更大的聊天 LLM。从这个意义上说,它们都代表了一条有别于“单纯把语言模型做大”的 scaling 路线,世界模型意味着学到环境的动态和结构,而不是只学 token。

所以这场争论,与其说是技术分歧,不如说是各方在自己的位置上讲述对自己有利的不同版本的故事。

DeepSeek的一句话

在这场争论里,中国AI公司是一个特殊的存在,而DeepSeek可能是最有代表性的案例。

过去一年,DeepSeek靠着极高的算力利用效率,用远低于硅谷同行的成本做出了能打的模型。这一度被解读为Scaling Law的反例,你看,不用砸那么多钱也能做出好东西。

但这可能是一个误读。

DeepSeek真正证明的是,架构优化和工程能力可以让你在同样的算力预算下获得更好的结果。用他们自己的话说,是把Scaling曲线往更省算力的方向平移了。但曲线本身还在那里,你想往上走,还是要投入更多资源。

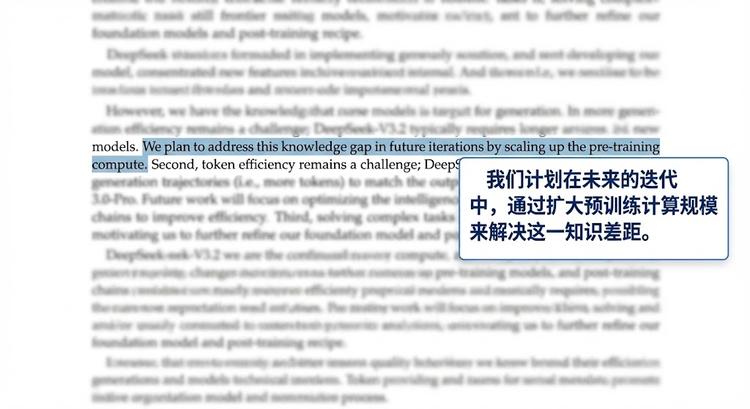

这一点在DeepSeek-V3.2的技术报告里说得很清楚。他们在结论部分直接承认,模型在世界知识广度上的不足,根本原因是总训练算力比前沿闭源模型少。要补这个短板,只有一个办法,扩大预训练算力。

翻译成白话:我们要买更多卡了。这可能会在接下一代模型上应验。

对中国AI公司来说,这是一个现实的处境。算法优化、工程效率,这些是现阶段的护城河,但不是永久的。长期来看,如果Scaling Law继续有效,算力就是绕不过去的坎。而在芯片受限的情况下,这意味着要么找到其他的路,要么在有限的资源里把效率做到极致。

苦涩的教训:只要我 GPU 足够多、算力足够大,我就能碾压你们

Scaling Law死了,Scaling Law万岁

回到最初的问题,Scaling Law到底死没死?

从目前的证据来看,答案是没有。Gemini 3的表现、各家公司的持续投入、技术演进的方向,都指向同一个结论,Scaling仍然有效,只是方式变了。

过去那种简单粗暴的配方,更大、更多、更强,确实在遇到瓶颈。但Scaling的内涵正在变化。预训练、后训练、测试时计算,三个阶段都有各自的增长曲线。算力的价值也从直接转化成智能,变成了加速实验和迭代的基础设施。

对头部厂商而言,Scaling不仅是技术问题,更是资产负债表问题。已经宣布和在建的数据中心项目,未来会持续压在头上,要求模型能力不断提高来消化这些投入。

所以这不意味着一切都很乐观,模型在变强,但变强的速度是否足以支撑当前的估值和投资规模,这是另一个问题。

华尔街有句话:“趋势是你的朋友,直到它不是。”Scaling Law也一样,它会一直有效,直到它不有效。但那一天,显然还没到来。