Arm 介绍 SME2 可伸缩矩阵扩展:助力 CPU 集群 AI 性能提升 4.7 倍

13 小时前

/ 阅读约2分钟

来源:IT之家

Arm在峰会上介绍了C1系列CPU搭载的SME2技术,该技术显著提升了AI性能,让实时端侧AI推理成为现实,并展示了在实际场景中的效益,预计到2030年将为超30亿台设备新增超100亿TOPS计算能力。

IT之家 9 月 10 日消息,Arm 今日在 ARM UNLOCKED 峰会上重点介绍了 C1 系列 Arm CPU 搭载的 SME2 第二代可伸缩矩阵扩展。

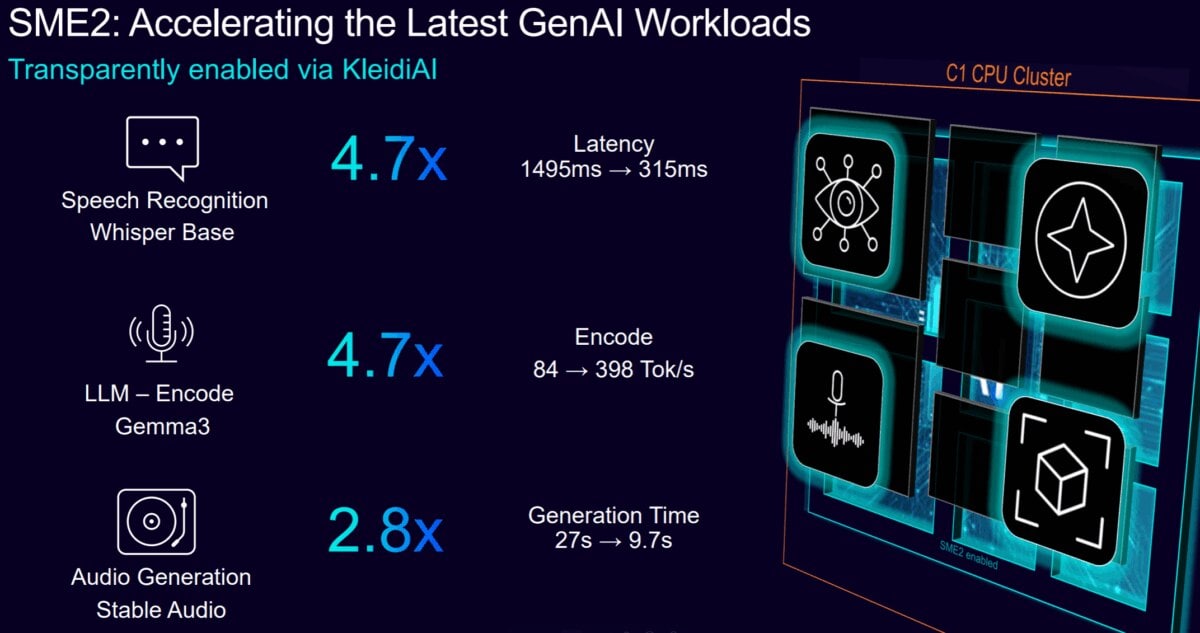

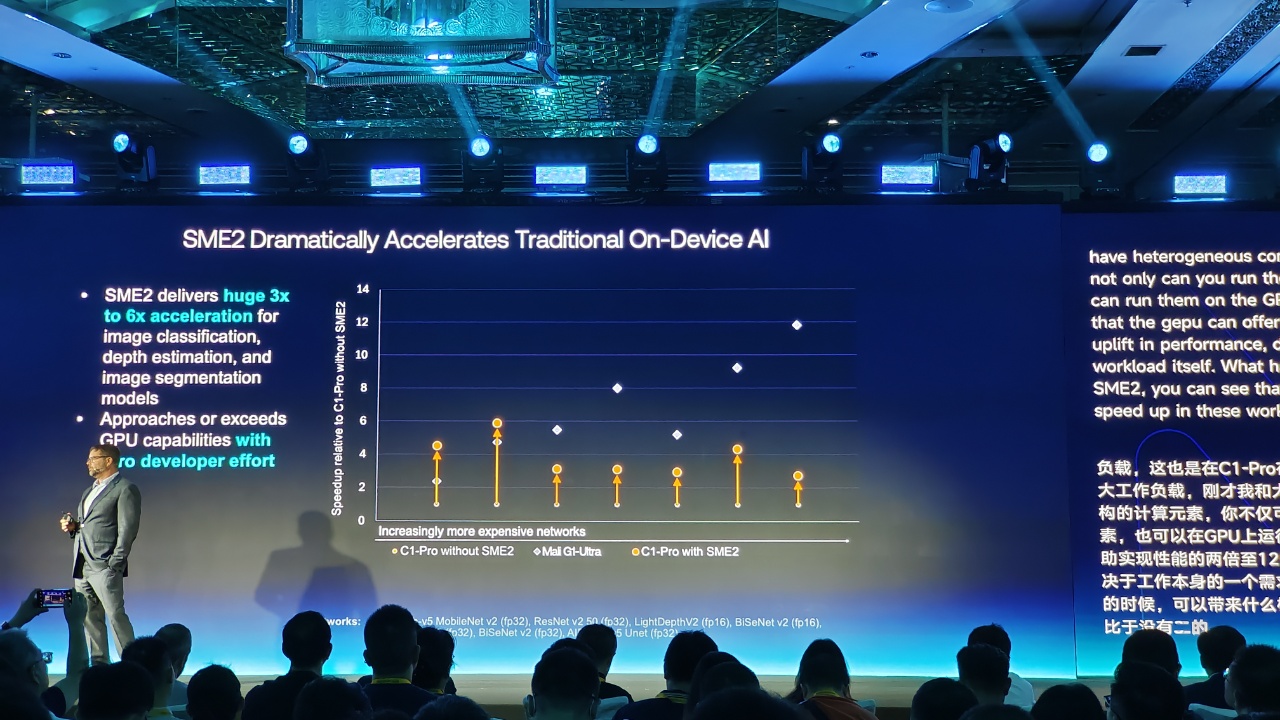

得益于 SME2 技术的加持,Arm C1 CPU 集群在实际 AI 驱动型任务上实现了显著的 AI 性能提升,让实时的端侧 AI 推理成为现实:AI 性能提升 4.7 倍 (Google Gemma 3)、语音类工作负载延迟降低 4.7 倍 (Whisper Base)、音频生成速度提升 2.8 倍 (Stability AI Stable Audio)。

Arm 还展示了 SME2 在实际场景应用中的效益:

在“智能瑜伽教练”演示应用中,SME2 推动文本转语音生成速度提升了 2.4 倍,这意味着用户能即时获得姿势反馈与指导,且全程不用担心设备的电池续航问题;

通过与支付宝、vivo 的三方合作,大语言模型 (LLM) 的交互响应时间缩短了多达 40%。

此外在计算摄影方面,搭载 SME2 的单个核心可运行 1080p 120fps 或 4K 30fps 的神经摄像头降噪,即使在光线最暗的场景中也能捕捉到更锐利、清晰的图像。

Arm 高级副总裁兼终端事业部总经理 Chris Bergey 表示:

AI 已不再仅仅是一项技术功能,它已成为下一代移动与消费技术的支撑底座。依托 Arm Lumex 平台,我们持续提升端侧 AI 体验,以满足用户日益增长的需求与期待。为此,我们正积极将 SME2 技术扩展至每一个 CPU 平台。

预计到 2030 年,SME 与 SME2 技术将为超过 30 亿台设备新增超 100 亿 TOPS 的计算能力,为端侧 AI 性能带来指数级跃升。