黄仁勋终于得到了他最想要的东西。

本周美国政府正式批准英伟达向中国以及其他“经批准的客户”出售高端的H200 GPU芯片,但需要向美国政府缴纳25%的销售提成。这一提成比例同样适用于AMD、英特尔等其他美国芯片巨头。不过,英伟达最新的Blackwell和未来的Rubin系列GPU仍然禁止出口。

这标志着黄仁勋长达数月的游说取得成功。过去半年时间,他不断造访佛罗里达与华盛顿,随着特朗普总统一道出访和出席国宴,向白宫宴会厅建设工程捐款,就是为了这一刻。就在上周,他再一次来到白宫会见总统,终于如愿以偿得到了解锁禁运令。

受这一利好消息推动,英伟达股价盘后应声上涨。受美国政府连续多道芯片加码禁运令限制,过去两年时间,英伟达一步步失去迅猛增长的中国市场,丢掉了在AI GPU市场原先高达95%的份额。在英伟达最核心的数据中心业务,中国市场的营收占比也从原先的四分之一急剧下滑。

心急如焚的黄仁勋在两个月前公开抱怨,“我们已经失去了全球最大的市场之一,在中国市场完全出局,市场份额已经归零。”即便是向美国政府缴纳四分之一的提成,对英伟达的业绩营收也意义重大,因为中国AI GPU今年规模估计高达200亿-300亿美元(中商产业研究院数据)。

然而,黄仁勋在努力争取重新打开另一个市场的时候,或许还要担忧自己的后方。因为群狼已经围上来了:他们最大的AI芯片客户,谷歌、亚马逊、微软这三大巨头,即Hyperscalers(超大规模云服务商),正在加速普及自己的自研芯片。

英伟达无疑是生成式AI时代的领军公司。在AI芯片这个万亿级赛道中,英伟达以压倒的性能优势和CUDA平台优势占据主导地位,其GPU 产品线几乎垄断了八成 以上的市场份额。英伟达也因此成为全球最具价值的上市公司,市值甚至一度突破5万亿美元。

虽然英伟达数据中心业务营收高达1300亿美元(最近财年),但却存在一个巨大隐患:客户集中度过高,过度依赖于几大AI巨头。其中,前两大客户营收占比39%,前三大客户营收占比高达53%。

据媒体猜测,黄仁勋的前五大客户正是:微软、谷歌、亚马逊、Meta和甲骨文。而这前三大巨头正在加速转用自研芯片,同时拉拢第四大客户。这些自研芯片的部署,不仅会直接减少英伟达的芯片订单,更有可能在公开市场给英伟达带来威胁。

AWS低成本推理杀手

在上周拉斯维加斯召开的re:Invent年度开发者大会上,全球云计算市场的领头羊亚马逊AWS连续公布了一系列重磅产品,清晰地展示了在AI热潮中占据市场主导以及推动行业潮流变化的雄心。

最引人注目的当属亚马逊新一代自研 AI 芯片:Trainium 3。 诸多媒体将Trainium3 誉为“对英伟达的直接宣战”。这是亚马逊自2022年以来的第三代AI芯片,主打低成本与推理两大优势。

AWS CEO马特·加曼(Matt Garman)宣布,第三代芯片训练速度比前代快 4 倍,成本减半, 特别适合亚马逊Nova 2 模型家族的部署,支持百万芯片级集群。 与英伟达相当的 GPU 系统相比Trainium3 可节省 50% 训练费用。现场演示显示,Trainium3 在 Llama 3.1 训练中,仅需 24 小时完成相当于 H100 集群一周的任务。

低成本是最大的卖点,AWS官方将 Trainium3 定位为英伟达GPU的低成本替代品。他们表示,对于愿意采用其 Neuron软件栈和 Trainium实例的客户,基于 Trainium 的实例可以将大型模型的训练成本(通常还包括推理成本)比同类GPU集群可以降低高达约 50%。

亚马逊此次大会的诸多发布相当于摆明态度:要用自研芯片、自研模型、私有化部署以及智能体全家桶,把从训练到推理、从云端到本地、从通用模型到定制模型的整条 AI 赛道都牢牢攥在自己手里。云计算巨头AWS摆明自研方向,这无疑会对AI基础设施市场的未来走向带来重大影响。

目前AWS 在云计算市场仍保持巨大领先优势,为大大小小的客户提供云端 AI 算力,支持他们自由选择各种大模型。AWS目前的市场份额超过三成,而排名二三位的微软与谷歌市场份额为20%与16%。(基于Synergy Research的统计数据)

从Anthopic到OpenAI再到Meta,诸多AI巨头与创业公司都在广泛使用亚马逊的AWS云服务。就在上个月,OpenAI宣布与AWS签署合作协议,七年采购价值380亿美元的AI基础设施服务。AWS还强调,Anthropic等 AI 初创公司已转向 Trainium,节省了超过三成的预算。

谷歌拉到Meta大客户

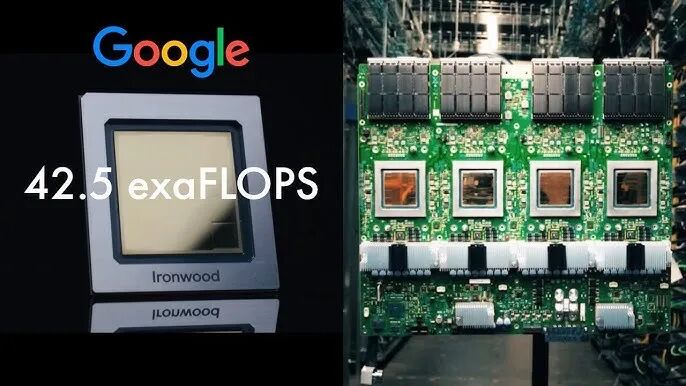

谷歌是行业最早自研芯片的巨头,其第一代TPU早在2016年发布,已经成为AI基础设施巨头挑战英伟达的行业标杆。就在上个月,谷歌在他们的Cloud Next云计算大会上发布第七代TPU v7 Ironwood,进一步让英伟达感受到了压力。

Ironwood 的核心亮点是性能跃升:单芯片 FP8 计算达4.6 PFLOPS(每秒 1000 万亿次浮点计算),比 第五代TPU提升 10 倍,是第六代TPU的 4 倍。

谷歌强调 Ironwood 专为“高吞吐、低延迟”推理优化,适用于 Gemini 3 等多模态模型。相比英伟达王牌的Blackwell,Ironwood 在能效上领先 20%,功耗仅 300W/芯片。 这得益于其 systolic array架构和自定义互连,可以专攻矩阵乘法等 AI 核心运算。

谷歌在TPU 的演进上稳步前进:从 v1 的纯训练芯片,到 v7 原生支持 FP8,谷歌已覆盖从边缘设备(Edge TPU)到超大规模 Pod 的全栈。从战略上看,Google 的 TPU 不仅是硬件,更是云生态的“杀手锏”。

对英伟达来说,谷歌带来的威胁已经日益明显。2025 年,谷歌的 AI 芯片市场份额预计已经达到 8%, 尤其在占 AI 算力 80% 的推理领域。SemiAnalysis 分析称,Ironwood “显著缩小了与 NVIDIA 旗舰的浮点计算性能差距”。

谷歌声称,使用 TPU 可将训练成本降 40%,吸引了 Meta 等第三方客户。据媒体报道,Meta已经计划在2027年部署谷歌TPU,绕过英伟达的芯片。谷歌Ironwood 服务器将交由富士康代工。而Meta正是英伟达AI芯片的第四大客户。这一打击是双重的。

虽然黄仁勋依然以乐观口吻应对谷歌TPU带来的威胁,强调英伟达的多平台兼容与供应链优势,认为巨头自研芯片不会动摇英伟达的“护城河”(生态和软件栈),但他也不得不承认市场竞争会让投资者感到担忧。

微软抢不过巨头量产延误

相比亚马逊和谷歌在自研芯片方面的稳步推进和大规模部署,微软在这领域暂时还在交学费,遭受了跳票挫折。微软自研芯片首代 Maia 100 于 2024 年推出,专为自家的Azure AI 优化,今年开始大规模部署。但原本计划今年发布的 Maia 200(代号 Braga)的大规模量产已经推迟至2026 年。

今年10月,微软宣布 Maia 100 已部署于 Azure 数据中心,支持 OpenAI 模型训练。 这是微软与博通合作开发的芯片,预计比英伟达的H100芯片成本低40%。而未来三代(代号分别为Braga、Braga-R 和 Cobalt)计划覆盖训练、推理和边缘。

Maia芯片的最大优势自然是与微软Azure的原生态结合——集成 DirectML 框架,吸引企业客户私有化部署。Maia 系列聚焦多模态 AI,例如突出微软Copilot的语音和视觉处理,单芯片 BF16 性能达 2 PFLOPS。

微软CTO凯文·斯科特(Kevin Scott)表示,公司未来将“主要使用自家芯片”,目标减少对英伟达芯片的严重依赖。但微软的这一目标却遭到了Maia量产推迟的打击。根据媒体报道,Maia 200量产延误主要是由于设计变更、仿真不稳定等技术与内部因素。

但另一方面,台积电的产能瓶颈也是现实限制因素。毕竟台积电先进制程(如 N3/N2/高级封装)目前是全球最抢手的生产能力,英伟达、苹果、AMD等巨头客户都在争抢产能。产线几乎被预定一空,排期非常紧张。

台积电通常会根据订单时间、技术节点、客户战略价值等进行安排。微软既不是台积电的大客户,自身芯片设计也没有完善,只能排在后面的非优先级。微软想减少对英伟达的依赖,这是战略必要,但芯片从设计到大规模量产之间仍有长期供应链竞争。

在台积电那里产能抢不过芯片巨头,微软只能转向英特尔的18A节点,计划在明年实现量产。这一延误给微软带来了巨大的额外开支。如果Maia二代不能及时规模部署,微软明年可能还要投入100亿美元购买英伟达芯片。

性能vs成本巅峰对决

虽然目前英伟达依然在AI 芯片领域占据绝对话语权,但 三大巨头的自研浪潮正给市场带来巨大变数。2025 年谷歌、亚马逊和微软先后发布的最新自研芯片,预示着 2026 年将是一场“性能 vs. 成本”的巅峰对决。

性能技术依然是英伟达的核心优势,谷歌微软亚马逊的自研芯片都只能强调成本优势。英伟达今年的Blackwell 架构B200 GPU,单芯片 FP8 计算能力达 20 PFLOPS(每秒千万亿次浮点运算),比前代 H100 提升 4 倍。

在推理任务中,Blackwell的能效比谷歌TPU 高出 30%,这得益于其先进的 NVLink 互联技术和 Transformer 引擎优化。黄仁勋对此充满信心,正如在 GTC 2025 大会上宣称:“我们的 GPU 领先竞争对手整整一代。”

这种领先不仅体现在峰值性能,还包括软件栈的深度整合:CUDA 平台支持 4000 多个 AI 框架和库,开发者生态庞大到“开箱即用”。这才是英伟达的真正护城河。相比之下,AI巨头们的自研芯片往往需额外适配,增加了开发者的迁移成本。

但成本却是AI巨头自研芯片的最大卖点。亚马逊Trainium3 已宣称可将训练成本降至前代的 50%, 谷歌 Ironwood TPU 在推理任务中,能效比英伟达H100 高出 20-30%。进入 2026 年,这一差距将进一步拉大。

此外,AI巨头正通过“渐进式”策略蚕食英伟达的CUDA优势。谷歌的JAX 和 PyTorch/XLA 集成已覆盖 70% AI 工作负载, AWS Neuron SDK 支持 Llama 和 Stable Diffusion 等开源模型, 而 微软的DirectML 则无缝嵌入 Visual Studio,吸引企业开发者。

亚马逊AWS 计划在 Trainium4 上集成 NVLink 兼容技术,实现与 英伟达GPU 的无缝混合部署,预计训练费用再降 40%。 与此同时,2027年商用的谷歌TPU v8将引入光子互联和更先进的 systolic array 架构,针对多模态模型如 Gemini 4 的推理优化,成本优势或达 50% 以上。

四分之一市场份额

亚马逊的目标是在明年达到50%的自研占比,推动AWS在 AI 云市场的份额从 31% 升至 35%。他们是Anthropic的最大投资者和云服务商。因此Anthropic的大模型训练主要靠AWS Trainium芯片。

而谷歌TPU 的市场份额更是已悄然攀升至 8%。他们从今年开始向外部客户积极销售原先自用的TPU,目前的外部销售占比已经达到了20%。随着2027年Meta转用TPU,英伟达将真正感受到谷歌带来的竞争压力。

今年10月,Anthropic与谷歌签署了价值数百亿美元的协议,计划使用多达100万片TPU,其中包括40万片Ironwood,其余通过谷歌云租赁。换句话说,现在AI大模型公司都在推动芯片多元化,尽可能同时使用多家芯片,而不是只依赖于英伟达GPU。

黄仁勋传记作者、非常了解英伟达的史蒂芬·维特(Stephen Witt)认为,“英伟达最大的风险显然是谷歌,如果谷歌证明他们可以用自家芯片维持领先AI开发,那么这将给其他巨头树立榜样。”

即便加紧部署自研芯片,这些巨头也会未来几年继续采购英伟达。一个值得体会的细节是,谷歌和亚马逊在发布自研芯片时,都会提前通知英伟达,因为他们希望继续维持与英伟达的良好关系,继续保证自己的芯片供应。

未来这些巨头自研芯片会达到多少份额?黄仁勋的直接竞争对手、AMD CEO苏姿丰对谷歌TPU给出了非常高的评价。“多年来,谷歌在 TPU 架构上做得很好。但 TPU 是一种更偏向特定用途的设计,它缺乏 GPU 所具备的可编程性、模型灵活性,以及训练与推理能力之间的平衡。GPU 将高度并行架构与高可编程性相结合,从而能够实现快速创新。”

“从我们的角度来看,各种类型的加速器都有空间。然而,在未来五年内,GPU 仍将明显占据市场大部分份额,因为我们仍处于行业周期的早期阶段,软件开发者希望拥有实验新算法的灵活性。因此,给 ASIC 类加速器(三大巨头的自研芯片都是)留出 20%–25% 的市场份额是合理的。”

换句话说,她认为三大巨头的自研芯片可能在未来夺走四分之一的市场份额。而且,苏姿丰还计划AMD在未来3-5年,抢到两位数的市场份额。以及,英伟达在中国市场同样要面临华为、寒武纪等本土竞争对手。