5月20日凌晨,微软Build 2025正式登场。

敏锐抓住了大模型窗口期,再次带队微软转型的微软现任CEO萨提亚·纳德拉( Satya Nadella),在这场发布会上带来了不少新产品。

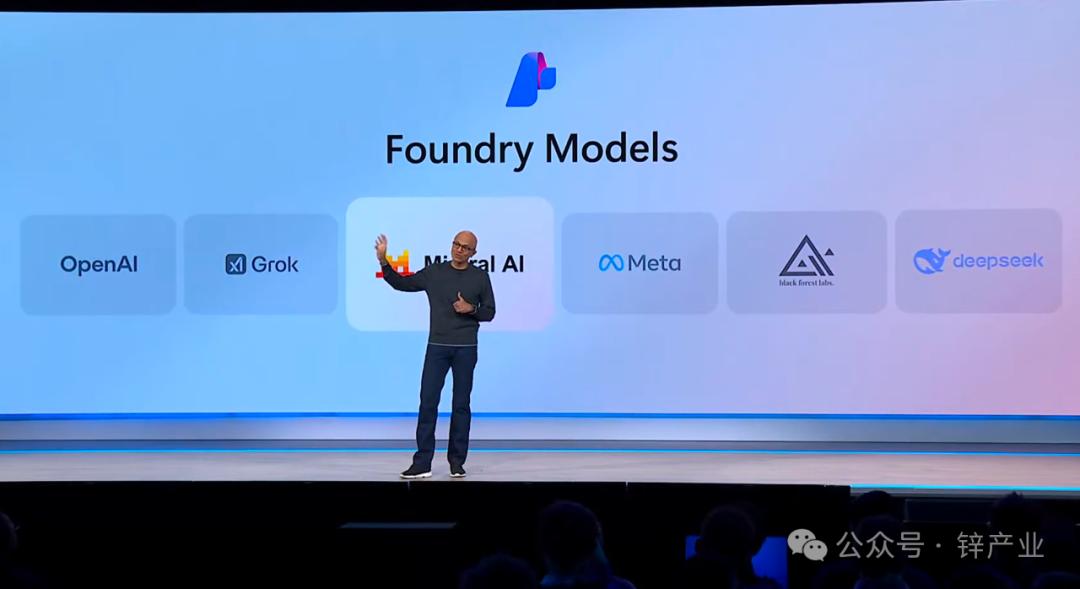

有面向开发者的编程智能体Coding Agent,有面向打工人的Microsoft 365 Copilot,也有云上智能工厂Azure AI Foundry。

作为这个时代的主流叙事,无论是学术界、还是产业界,对于大模型技术发展已经不再有什么疑虑。

这时,微软已经全面AI化。

作为 当下全球最有“权势”CEO,在微软这场年度开发者大会上,萨提亚也请来了当下AI领域最炙手可热的三位顶流CEO:

OpenAI CEO萨姆·奥特曼(Sam Altman)xAI CEO埃隆·马斯克(Elon Musk)、英伟达CEO黄仁勋(Jensen Huang)。

并在大会上与这三位科技大佬分别进行了一场隔空对话,谈了OpenAI刚发布的代码智能体 Codex,谈了xAI即将上线的Grok 3.5,也谈了黄仁勋的CUDA加速一切。

以下是萨提亚和三位顶流AI大佬的对话,我们进行了不改变原意的梳理:

01 萨姆·奥特曼:全天使用Codex的人,正在完成更多工作

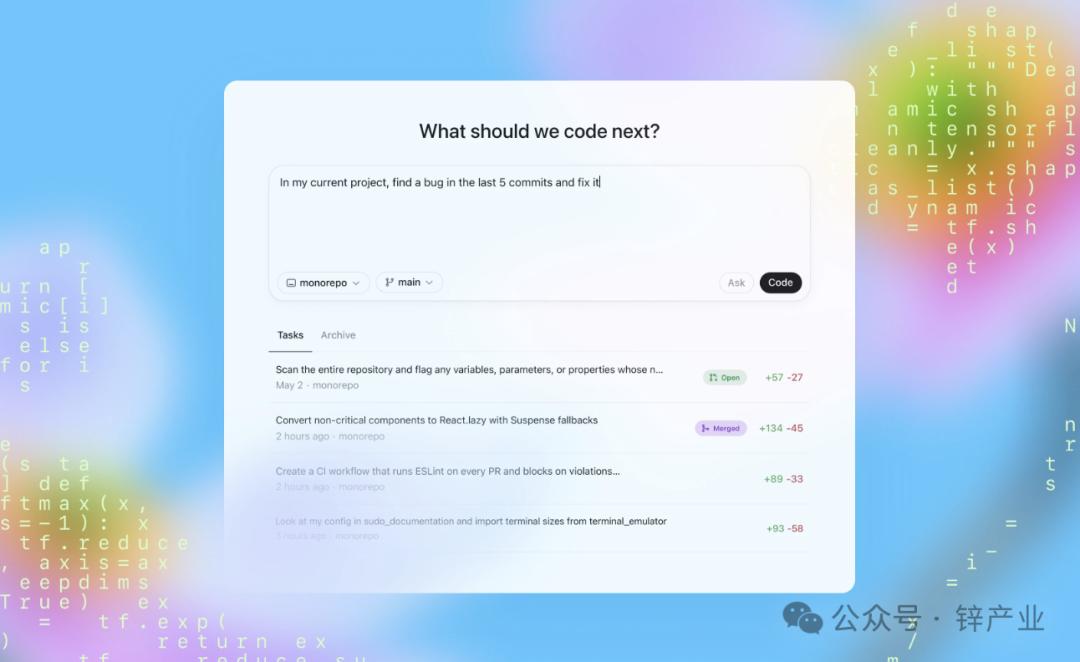

萨提亚·纳德拉:萨姆,欢迎来到Build大会,我们对OpenAI上周五发布的Codex智能体非常兴奋。

你能否谈谈你对软件工程未来发展的愿景,以及开发者将如何综合使用诸如命令行界面(CLI)和编程智能体这样的工具?

萨姆·奥特曼:我们早在2021年就一起推出了Codex的首个版本,当时我们就在讨论如何实现真正的智能编程体验。现在这一刻终于到来,我觉得这是我见过的编程领域最大的变革之一。

你现在拥有一个真正的虚拟员工,可以向它分配工作,可以让它处理你正在进行的工作,甚至是更复杂的任务。

例如,你可以说:“我有一个大想法,去工作几天把它实现。”

你可以并行发出修复漏洞、实现新功能、回答代码相关问题等 多个请求,这就像真正的将软件工作外包一样。

这种能力与GitHub深度整合,你可以给它访问代码库和环境的权限,就能完成非常了不起的工作。

萨提亚·纳德拉:这种方式让开发者能够保持专注,与智能体和其他团队成员协作,像与真正的程序员一样工作,从而加速开发流程和生命周期。

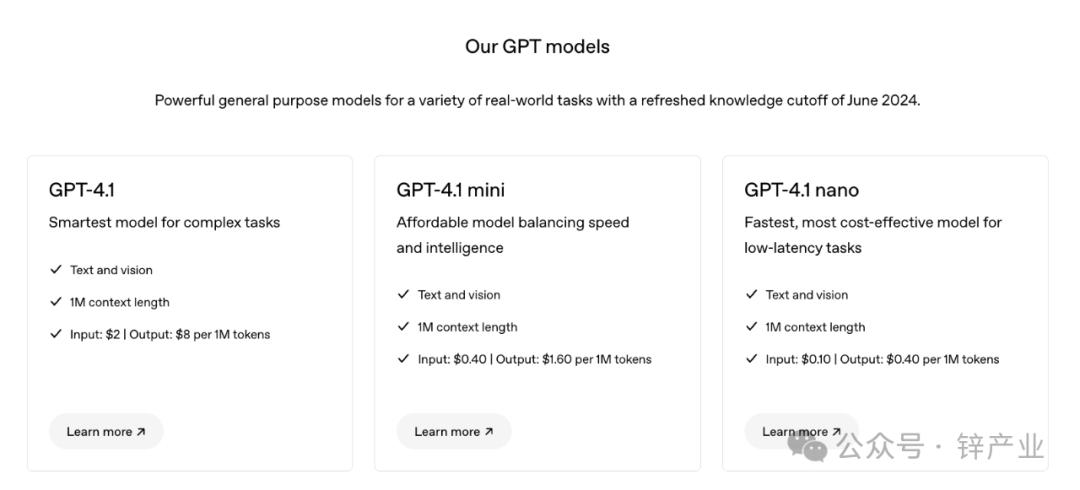

你们还在开发许多出色的模型,我们也有幸与你们同步发布了不少模型,能否分享一下针对大模型产品的未来规划?

萨姆·奥特曼:目前的大模型已经非常智能,而且会变得越来越聪明。

但更令人兴奋的是,模型将变得更易于使用,你不需要从众多模型中选择,系统会自动匹配最适合的模型完成最适合的任务。

模型的可靠性也会显著提高,你可以更放心地依赖它们。

此外,模型将支持更多功能,比如多模态能力和出色的工具集成,最终目标是让它“开箱即用”,无论是与它对话还是处理复杂的编码任务,都能轻松胜任。

我认为,大家会惊讶于我们在这些方向上的快速进展。

萨提亚·纳德拉:我们对你们的模型未来规划非常期待!

你基于OpenAI的经验,能否给开发者一些建议,特别是在构建大规模、生产级的智能体应用方面?

萨姆·奥特曼:这项工作最大的挑战之一是技术依然在快速变化。

回顾两年前、一年前和现在的可能性,再展望未来一两年,模型能力的提升速度令人难以置信。

开发者需要为这种能力增长做好规划,充分利用新的工具和流程。

这种技术变革在历史上并不多见,但每次变革来临时,早期大胆拥抱新工具的人总能获得巨大回报。

萨提亚·纳德拉:能否再分享一些你们在内部开发Codex时的观察?

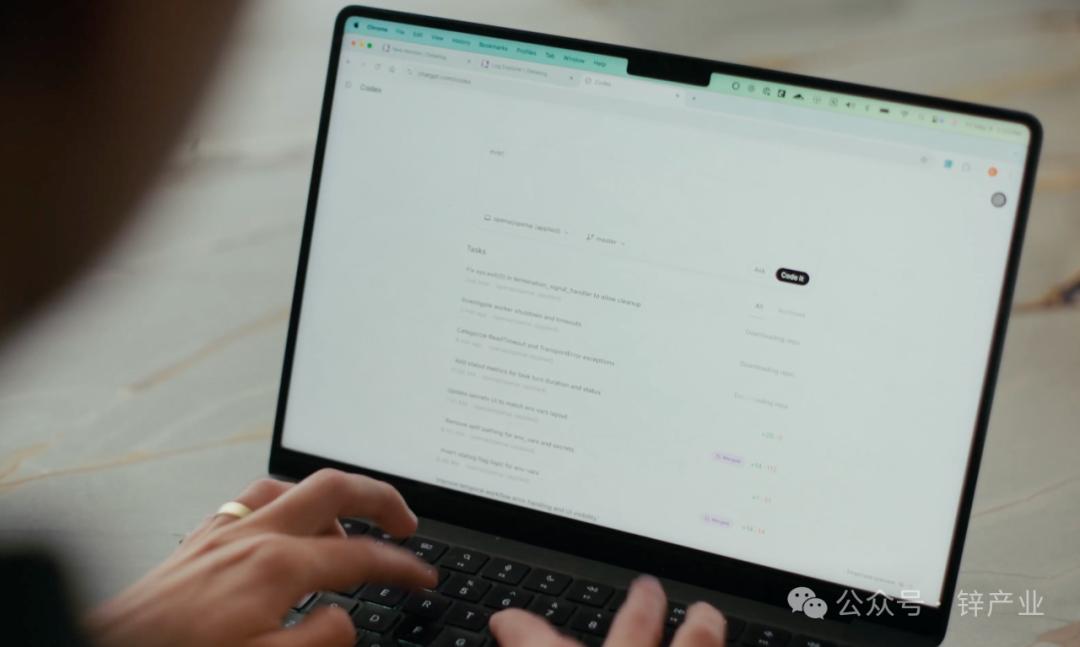

萨姆·奥特曼:在过去几个月里,我们内部使用Codex时发现,早期采用者的工作流程发生了巨大变化。

他们全天使用Codex,完成的工作量比其他人多得多,这非常有趣。

萨提亚·纳德拉:这对开发者来说是一个激动人心的时刻。

工具越来越强大,但更重要的是,这不仅仅关乎单一工具、智能体,而是所有这些如何结合在一起,让我们作为个体或软件工程团队更好地实现我们的创造力。

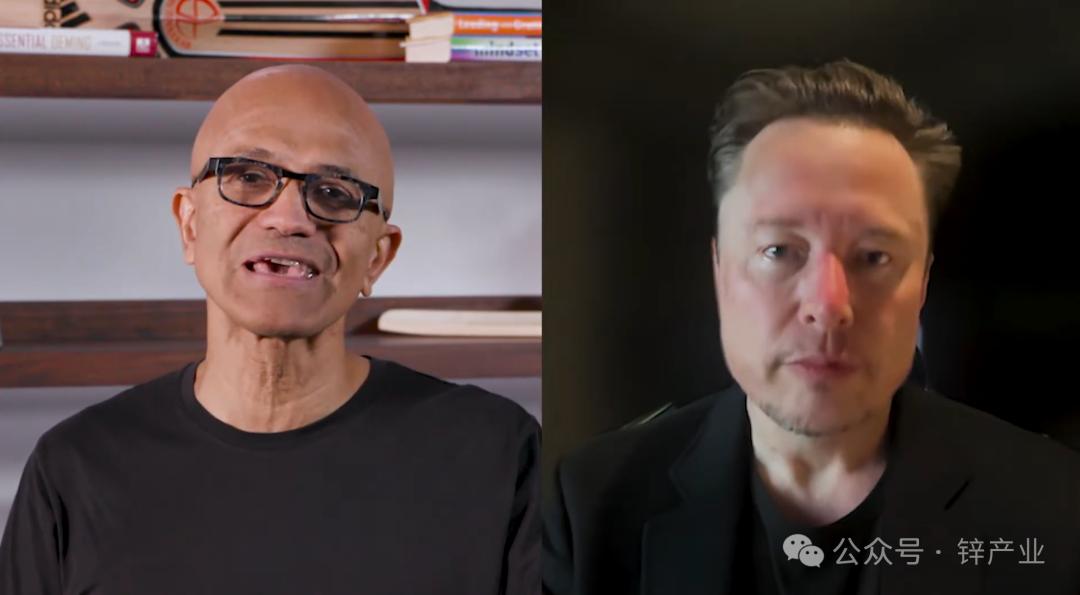

02 马斯克:Grok 3.5是应用物理学的推理工具

萨提亚·纳德拉:埃隆,感谢你参加Build大会,我们知道你曾在微软做实习生,是Windows开发者,现在依然是PC游戏爱好者。

能否分享一下你早年在Windows和DOS上的开发经历?

埃隆·马斯克:其实我在Windows之前就开始用DOS开发了,我有一台早期的IBM PC,运行MS-DOS,最初内存只有128K,后来升级到256K,感觉已经很强大了。

我在DOS上开发过视频游戏,后来也用Windows 3.1做过开发。

萨提亚·纳德拉:我们很兴奋能在Azure上推出Grok,这是一个兼具响应和推理能力的模型家族。

你能否谈谈你对xAI的愿景,以及Grok在能力和效率上的推动?

埃隆·马斯克:Grok,特别是即将发布的Grok 3.5,旨在从第一性原理出发进行推理,类似于物理学中的方法。

我们试图将问题分解到最基本的“公理元素”,这些元素最可能是正确的,然后从中进行推理。

你可以根据这些公理验证结论,就像物理学中如果违背能量守恒或动量守恒,你要么会得诺贝尔奖,要么就是错了——通常是后者。

所以,Grok 3.5的核心是应用物理学的推理工具,跨越所有推理领域,力求以最小的错误接近真理。

当然,错误在所难免,但我们致力于快速纠正错误,并以诚实为最佳策略,这对AI安全至关重要。

我认为,追求真理并不断减少错误是AI安全的重要保障。

萨提亚·纳德拉:开发者社区的反馈对Grok的改进应该至关重要,对此你怎么看?

埃隆·马斯克:完全同意。

我们会犯错,但我们希望快速纠正,我们非常期待开发者社区的反馈,告诉我们他们的需求,指出我们的不足,帮助我们改进。

我们的目标是让Grok成为开发者真正喜爱使用的工具,让他们感到自己的反馈被倾听,Grok也在不断进步以满足他们的需求。

我很激动能开启这段旅程,期待开发者如何部署Grok。

萨提亚·纳德拉:再次与埃隆交流时,他提到了Grok 3.5的诸多进展,我们希望通过API收集反馈,助力他们的路线图规划。

开发者社区的参与将推动Grok不断完善。

03 黄仁勋:CUDA提速AI 50倍

萨提亚·纳德拉:Jensen,感谢你再次参加Build开发者大会!

我们的共同目标是向世界提供更多智能,可以说是每瓦特、每美元的token数。你能否从摩尔定律的背景出发,谈谈你的看法?

黄仁勋:两年前,我们在Azure上推出了全球最大的AI超级计算机。

现在,通过新的CUDA算法、模型技术以及Azure上的AI基础设施,我们实现了比Hopper快40倍的惊人速度提升。

我们希望保持架构兼容性,确保生态系统的稳定性,让软件开发者、AI开发者和基础设施客户的投资能够跨整个系统分摊和优化。

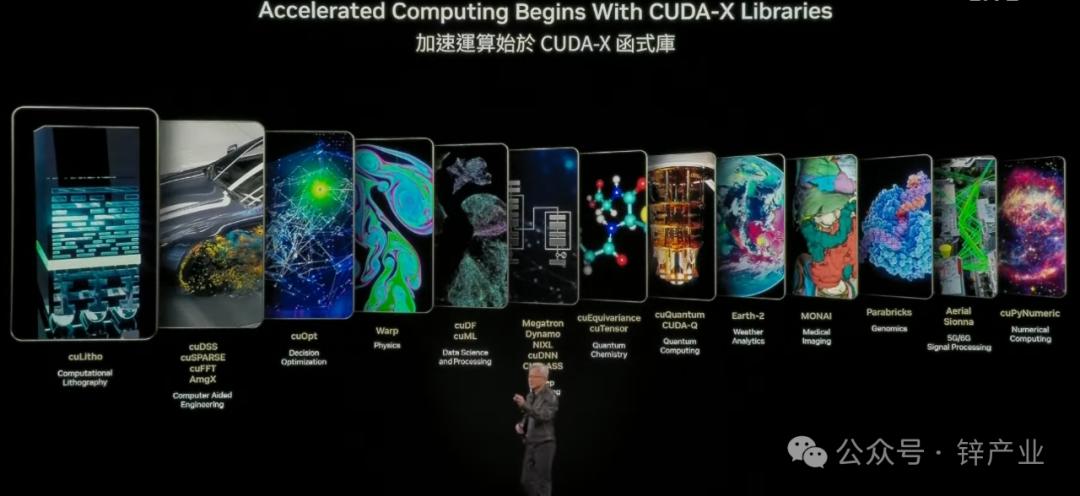

萨提亚·纳德拉:能否谈谈CUDA如何提升利用率,以及它如何加速多样化的工作负载?

黄仁勋:CUDA的安装基础非常庞大,这是一个优势。

同时,CUDA既是加速器架构,又具有相当的通用性,适用于一些最繁重的工作负载。

我们的团队正在合作加速数据处理,速度提升可达20倍到50倍,涵盖视频转码、图像处理以及其他各种模型,这些算法都能很好地映射到CUDA上。

我们的目标是,确保数据中心的所有工作负载都能得到充分加速,整个系统在生命周期内保持高利用率。

萨提亚·纳德拉:不仅是每美元、每瓦特的token数,而是所有工作负载的效率都能得到提升。

黄仁勋:感谢你的合作和领导力,我们两个企业联合起来在构建全球最先进的AI基础设施和AI工厂上高度协同。

最好的时代就在前方!