英伟达 Blackwell GPU 刷新 AI 推理速度世界纪录,实现 1000 TPS / User 里程碑

2025-05-24

/ 阅读约2分钟

来源:IT之家

英伟达表示,Blackwell 是首个在 Llama 4 上突破每用户 1000 TPS 里程碑的平台,并且整套 Blackwell 服务器系统可达 72000 TPS。

IT之家 5 月 24 日消息,当地时间周四,英伟达宣布其 Blackwell GPU 在 4000 亿参数的 Meta Llama 4 Maverick 模型上成功打破了 LLM 推理速度世界纪录。

据介绍,AI 基准测试机构 Artificial Analysis 通过配置 8 块 Blackwell GPU 的 DGX B200 节点,首次实现每用户每秒生成 1000 个 token(TPS)的性能里程碑。

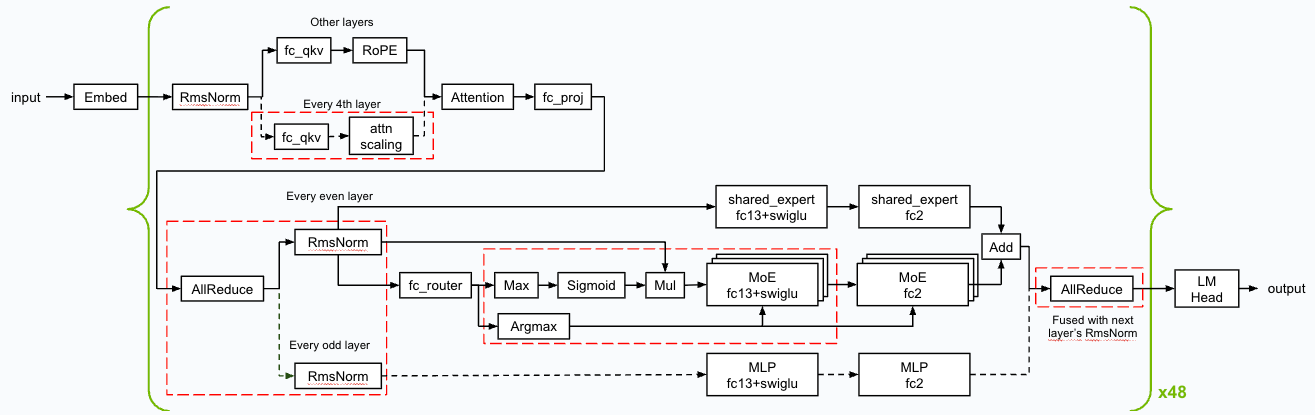

英伟达表示,技术团队通过 TensorRT-LLM 软件栈实施深度优化,并采用 EAGLE-3 技术训练推测解码草稿模型,使其性能较优化前基准提升 4 倍。整套服务器系统在峰值吞吐配置下可达每秒 72,000 token。

英伟达解释称:“推测解码是通过小型快速草稿模型预测 token 序列,再由大型目标 LLM 并行验证的加速技术。其优势在于单次迭代可能生成多个 token,代价是额外的草稿模型计算开销。”

为实现该突破,工程师团队采用基于 EAGLE3 的软件架构。该架构专为大型语言模型推理加速设计,与 GPU 硬件架构形成协同效应。IT之家注意到,测试结果显示 Blackwell 架构已完全适配 Llama 4 Maverick 级别的超大规模语言模型。

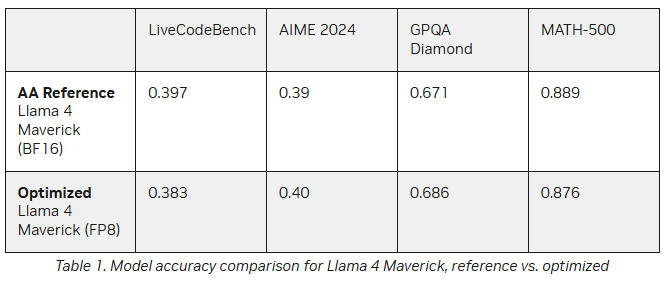

英伟达还表示,他们在保持响应准确性的同时大幅提高了性能。在许多指标上,使用 FP8 数据格式的准确性与人工分析 BF16 相当。

参考资料:

《Blackwell Breaks the 1,000 TPS/User Barrier With Meta’s Llama 4 Maverick | NVIDIA Technical Blog》