Google DeepMind 与 Google Research 联合推出的 Perch 2.0,进一步将生物声学研究推向新高度。相较于前代,Perch 2.0 以物种分类为核心训练任务,不仅纳入了更多非鸟类类群的训练数据,还采用了全新的数据增强策略与训练目标,在 BirdSET 和 BEANS 两项权威生物声学基准测试中均刷新当前 SOTA。

生物声学作为连接生物学与生态学的重要工具,在生物多样性保护与监测中扮演着关键角色。早期研究多依赖模板匹配等传统信号处理手段,在复杂自然声学环境与大规模数据面前,逐渐暴露效率低下、准确性不足的局限。

近年来,人工智能技术的爆发式发展推动深度学习等方法替代传统手段,成为生物声学事件检测与分类的核心工具。例如,基于大规模带标签鸟类声学数据训练的 BirdNET 模型,在鸟类声纹识别中表现卓越:不仅能精准区分不同物种的鸣叫,还能在一定程度上实现个体识别。此外,Perch 1.0 等模型通过持续优化迭代,在生物声学领域积累了丰富成果,为生物多样性监测与保护提供了坚实的技术支撑。

日前,Google DeepMind 与 Google Research 联合推出的 Perch 2.0,进一步将生物声学研究推向新高度。相较于前代,Perch 2.0 以物种分类为核心训练任务,不仅纳入了更多非鸟类类群的训练数据,还采用了全新的数据增强策略与训练目标。该模型在 BirdSET 和 BEANS 两项权威生物声学基准测试中均刷新当前 SOTA,彰显出强大的性能潜力与广阔的应用前景。

相关研究成果以「Perch 2.0: The Bittern Lesson for Bioacoustics」为题,发表预印本于 arXiv。

论文地址:https://arxiv.org/abs/2508.04665

数据集:训练数据构建与评估基准

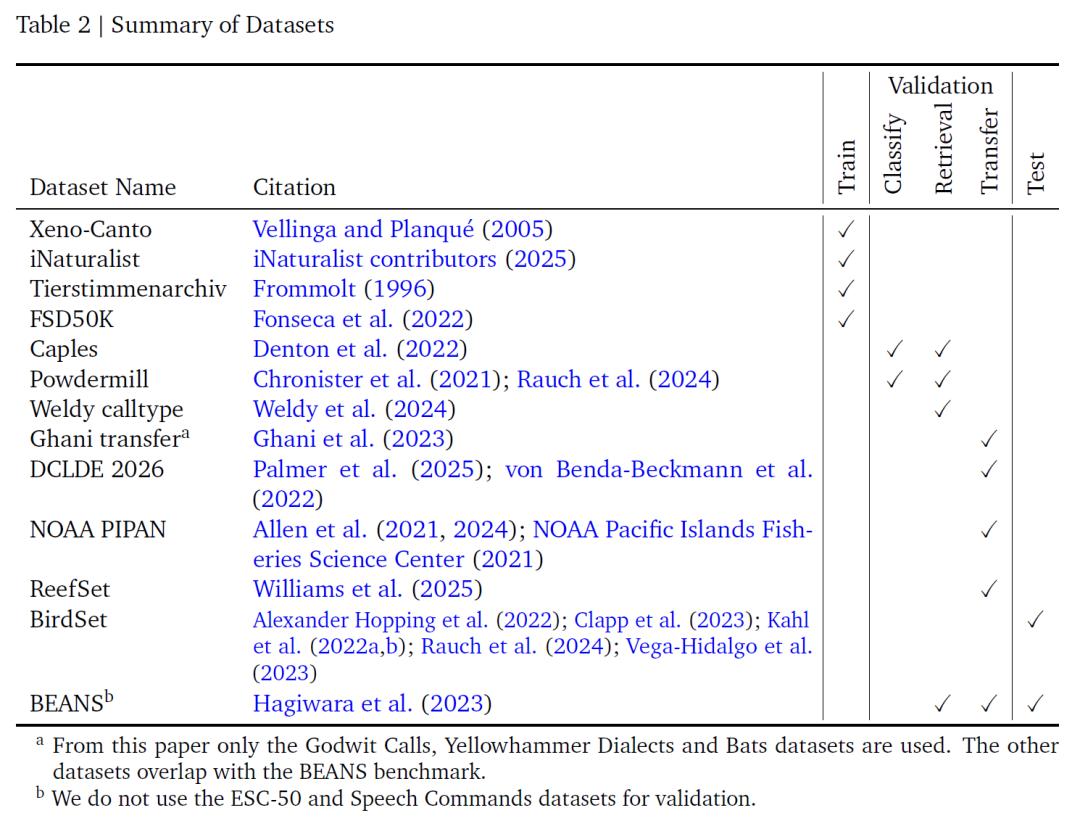

该研究为模型训练整合了 4 个带标签音频数据集——Xeno-Canto、iNaturalist、Tierstimmenarchiv 和 FSD50K,共同构成模型学习的基础数据支撑。其中,如下表所示,Xeno-Canto 与 iNaturalist 是大型公民科学库:前者通过公开 API 获取,后者源自 GBIF 平台标记为研究级的音频,二者均包含大量鸟类及其他生物的声学录音;Tierstimmenarchiv 作为柏林自然历史博物馆的动物声音档案,同样聚焦生物声学领域;而 FSD50K 则补充了多种非鸟类声音。

这四类数据共包含 14,795 个类别,其中 14,597 个为物种,其余 198 个为非物种声音事件。丰富的类别覆盖既保证了对生物声学信号的深度学习,又通过非鸟类声音数据拓展了模型的适用范围。不过,由于前三个数据集采用不同的物种分类体系,研究团队人工映射统一了类别名称,并剔除了无法用选定频谱图参数表示的蝙蝠录音,以此确保数据的一致性与适用性。

数据集摘要

考虑到不同数据源的录音时长差异极大(从不足 1 秒到超过 1 小时,多数在 5–150 秒),而模型固定以 5 秒片段为输入,研究团队设计了两种窗口选取策略:随机窗口策略在选中某条录音时随机截取 5 秒,虽可能包含目标物种未发声的片段,带来一定标签噪声,但整体处于可接受范围;能量峰值策略则沿用 Perch 1.0 的思路,通过小波变换选出录音中能量最强的 6 秒区域,再从中随机选取 5 秒,基于「高能量区域更可能包含目标物种声音」的假设提升样本有效性——这一方法与 BirdNET 等模型的检测器设计逻辑相通,能更精准捕捉有效声学信号。

为进一步提升模型对复杂声学环境的适应能力,研究团队采用了 mixup 的数据增强变体,通过混合多条音频窗口生成复合信号:先从 Beta-二项分布采样确定混合的音频条数,再通过对称 Dirichlet 分布采样权重,对选中的多条信号进行加权求和并标准化增益。

与原始 mixup 不同,该方法采用多热目标向量而非 one-hot 向量的加权平均,确保窗口内所有发声(无论响度高低)都能被高置信度识别;相关参数作为超参数调优,可增强模型对重叠声音的分辨能力,提升分类准确性。

模型评估则依托 BirdSet 与 BEANS 两大权威基准展开。BirdSet 包含来自美国本土、夏威夷、秘鲁、哥伦比亚的 6 个全标注声景数据集,评估时不进行微调,直接采用原型学习分类器的输出;BEANS 涵盖 12 项跨类群测试任务(涉及鸟类、陆生与海洋哺乳动物、无尾目及昆虫),仅用其训练集训练线性与原型探针,同样不调整嵌入网络。

Perch 2.0:一种高性能的生物声学预训练模型

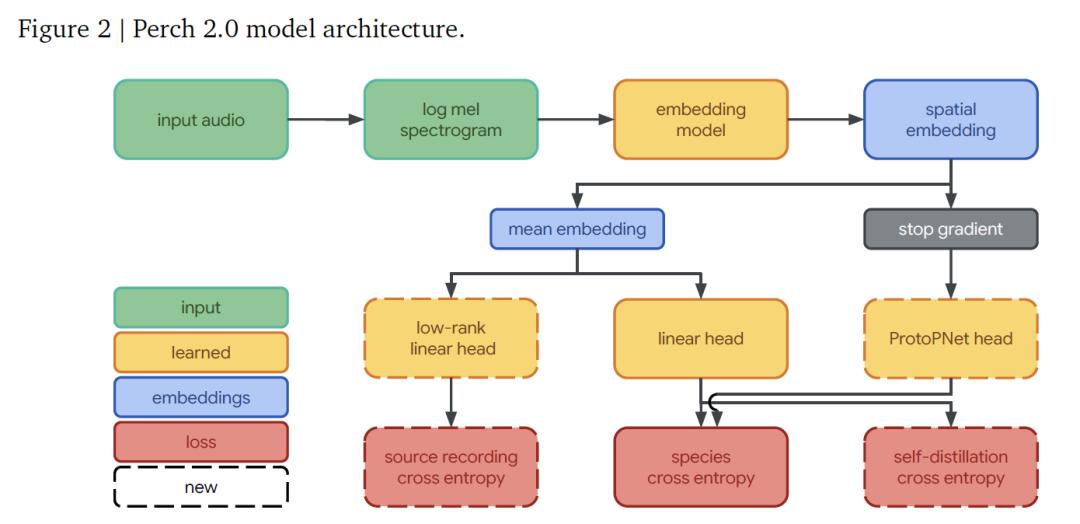

Perch 2.0 的模型架构由前端(frontend)、嵌入网络(embedding model)和一组输出头(output heads)共同构成,各部分协同实现从音频信号到物种识别的完整流程。

其中,前端负责将原始音频转换为模型可处理的特征形式,其接收 32kHz 采样的单声道音频,针对 5 秒长的片段(含 160,000 个采样点),通过 20ms 窗长、10ms 跳长的处理,生成包含 500 帧、每帧 128 个 mel 频带的 log-mel 频谱图,覆盖 60Hz 到 16kHz 的频率范围,为后续分析提供基础特征。

嵌入网络采用 EfficientNet-B3 架构——这是一款包含 1.2 亿参数的卷积残差网络,凭借深度可分离卷积设计最大化参数效率。相比上一版本 Perch 使用的 7,800 万参数 EfficientNet-B1,它的规模更大,以匹配训练数据量的增长。

通过嵌入网络处理后,会得到形状为(5, 3, 1536)的空间嵌入(维度分别对应时间、频率和特征通道),对空间维度取均值后,可获得 1536 维的全局嵌入,作为后续分类的核心特征。

输出头则承担着具体的预测与学习任务,包含 3 个部分:线性分类器将全局嵌入投影到 14,795 维的类别空间,通过训练促使不同物种的嵌入线性可分,提升后续适配新任务时的线性探测效果;原型学习分类器以空间嵌入为输入,为每个类别学习 4 个原型,取原型最大激活进行预测,这一设计源自生物声学领域的 AudioProtoPNet;来源预测头是一个线性分类器,基于全局嵌入预测音频片段的原始录音来源,由于训练集包含 150 余万条来源录音,它通过秩为 512 的低秩投影实现高效计算,服务于自监督来源预测损失的学习。

Perch 2.0 模型体系结构

模型训练通过 3 个独立目标实现端到端优化:

* 物种分类交叉熵针对线性分类器,采用 softmax 激活和交叉熵损失,对目标类别赋予均匀权重;

* 自蒸馏机制中,原型学习分类器作为「teacher」,其预测结果指导「student」线性分类器,同时通过正交损失最大化原型差异,且梯度不回传至嵌入网络;

* 来源预测作为自监督目标,将原始录音视为独立类别训练,推动模型捕捉显著特征。

训练分两阶段:第一阶段专注训练原型学习分类器(不启动自蒸馏,最多 300,000 步);第二阶段启动自蒸馏(最多 400,000 步),均使用 Adam 优化器。

超参数选择(Hyperparameter selection)依托 Vizier 算法,第一阶段搜索学习率、dropout 率等,经两轮筛选确定最优模型;第二阶段增加自蒸馏损失权重继续搜索,两种窗口采样方式贯穿始终。

结果显示,第一阶段偏好混合 2-5 条信号,来源预测损失权重 0.1-0.9;自蒸馏阶段倾向小学习率、少用 mixup,赋予自蒸馏损失 1.5-4.5 的高权重,这些参数支撑了模型性能。

Perch 2.0 的泛化能力评估:基准表现与实用价值

Perch 2.0 的评估聚焦泛化能力,既考察其在鸟类声景(与训练录音差异显著)、非物种识别任务(如叫声类型识别)中的表现,也测试向蝙蝠、海洋哺乳动物等非鸟类类群的迁移能力。考虑到从业者常需处理少量或无标签数据,评估核心原则是验证「冻结嵌入网络」的有效性,即通过一次性提取特征,快速适配聚类、小样本学习等新任务。

模型选择阶段从 3 方面验证实用性:

* 预训练分类器性能,在全标注鸟类数据集上用 ROC-AUC 评估「开箱即用」的物种预测能力;

* 一次样本检索,以余弦距离衡量聚类与搜索表现;

* 线性迁移,模拟小样本场景测试适配能力。

这些任务通过几何均值计算得分,最终 19 个子数据集的结果反映了模型真实可用性。

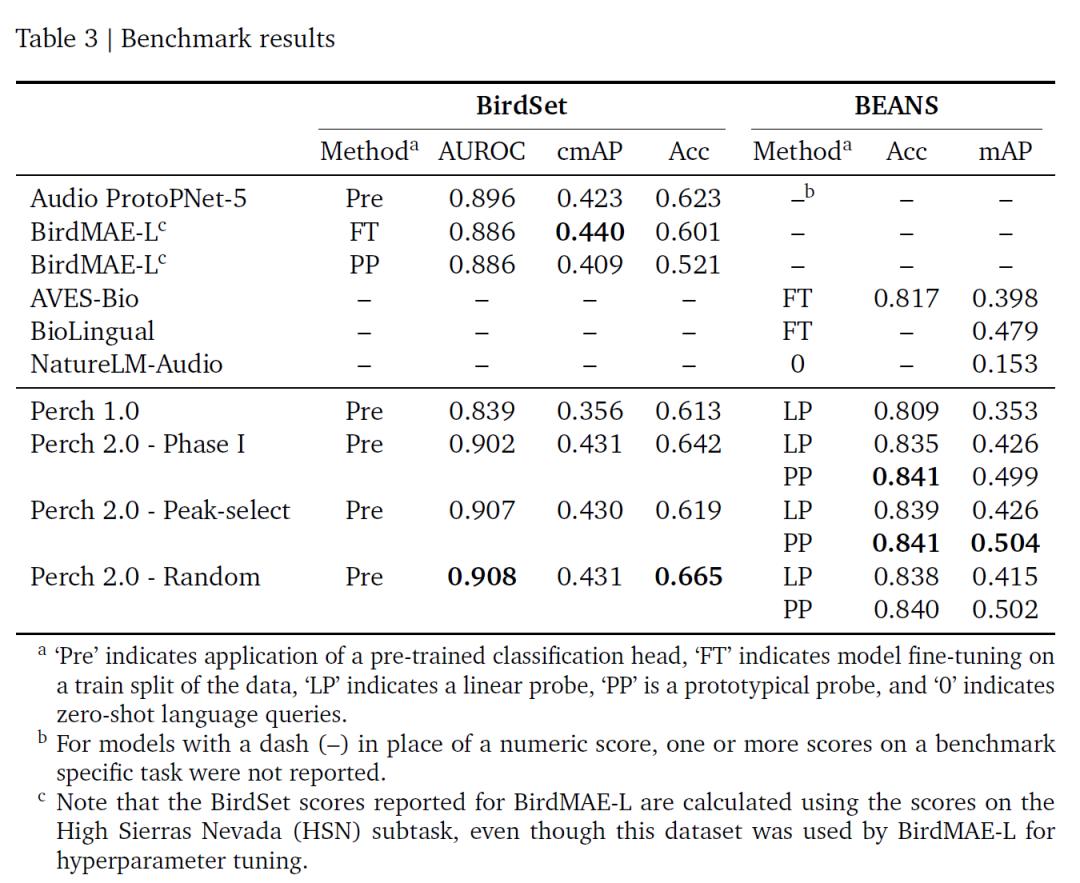

依托 BirdSet 与 BEANS 两大基准,该研究的评估结果如下表所示,Perch 2.0 在多项指标上表现突出,尤其 ROC-AUC 达当前最佳,且无需微调;其随机窗口与能量峰值窗口训练策略性能接近,推测因自蒸馏缓解了标签噪声影响。

基准测试结果

总体而言,Perch 2.0 以监督学习为核心,与生物声学特性密切相关。Perch 2.0的突破表明,高质量迁移学习无需依赖超大模型,精细调优的监督模型结合数据增强与辅助目标即可表现优异。其固定嵌入设计(无需反复微调)降低了大规模数据处理成本,为敏捷建模提供可能。未来,构建贴合实际的评估基准、利用元数据开发新任务、探索半监督学习,将是该领域的重要方向。

生物声学与人工智能的交汇

在生物声学与人工智能交叉领域,跨类群迁移学习、自监督目标设计、固定嵌入网络优化等研究方向已引发全球学术界与企业界的广泛探索。

剑桥大学团队开发的余弦距离虚拟对抗训练(CD-VAT)技术,通过一致性正则化提升声学嵌入的区分性,在大规模说话者验证任务中恢复了 32.5% 的等错误率改进,为语音识别中的半监督学习提供了新范式。

麻省理工学院与 CETI 合作的抹香鲸声纹研究,通过机器学习分离出包含节奏、韵律、震颤和装饰音的「发音字母表」,揭示其交流系统的复杂性远超预期——仅东加勒比抹香鲸部族就存在至少 143 种可区分的发声组合,其信息承载能力甚至超过人类语言的基础结构。

苏黎世联邦理工学院研发的光声成像技术,通过负载氧化铁纳米颗粒的微胶囊突破声学衍射极限,实现深层组织微血管的超分辨率成像(分辨率达 20 微米),在脑科学与肿瘤研究中展现出多参数动态监测的潜力。

同时,开源项目 BirdNET 凭借全球 1.5 亿条录音的积累,已成为生态监测的标杆工具,其轻量级版本 BirdNET-Lite 可在树莓派等边缘设备上实时运行,支持超过 6,000 种鸟类的识别,为生物多样性研究提供了低成本解决方案。

日本 Hylable 公司在日比谷公园部署的 AI 鸟鸣识别系统,通过多麦克风阵列与 DNN 结合,实现声源定位与种类识别的同步输出,准确率达 95% 以上,其技术框架已扩展至城市绿地生态评估与无障碍设施建设领域。

值得关注的是,谷歌 DeepMind 的 Project Zoonomia 项目正通过整合 240 种哺乳动物的基因组与声学数据,探索跨物种声学共性的进化机制。研究发现,犬类愉悦吠叫的谐波能量分布(3-5 次谐波能量比 0.78±0.12)与海豚社交哨声(0.81±0.09)高度同源,这种分子生物学层面的关联不仅为跨物种模型迁移提供了依据,更启发了“生物学启发式AI”的全新建模路径——将进化树信息融入嵌入网络训练,从而突破传统生物声学模型的局限性。

这些探索正在让生物声学与人工智能的结合变得更有温度。当学术探索的深度遇上产业应用的广度,那些曾藏在雨林树冠、深海暗礁里的生命信号,正被更清晰地捕捉、解读,最终化作保护濒危物种的行动指南,或是城市与自然和谐共生的智慧方案。

参考链接:

1.https://mp.weixin.qq.com/s/ZWBg8zAQq0nSRapqDeETsQ

2.https://mp.weixin.qq.com/s/UdGi6iSW-j_kcAaSsGW3-A

3.https://mp.weixin.qq.com/s/57sXpOs7vRhmopPubXTSXQ