IT之家 10 月 20 日消息,今天上午,DeepSeek-AI 团队发布《DeepSeek-OCR:Contexts Optical Compression》论文,提出利用视觉模态压缩长文本上下文的新方法。Hugging Face 页面显示,该模型的参数量为 3B。

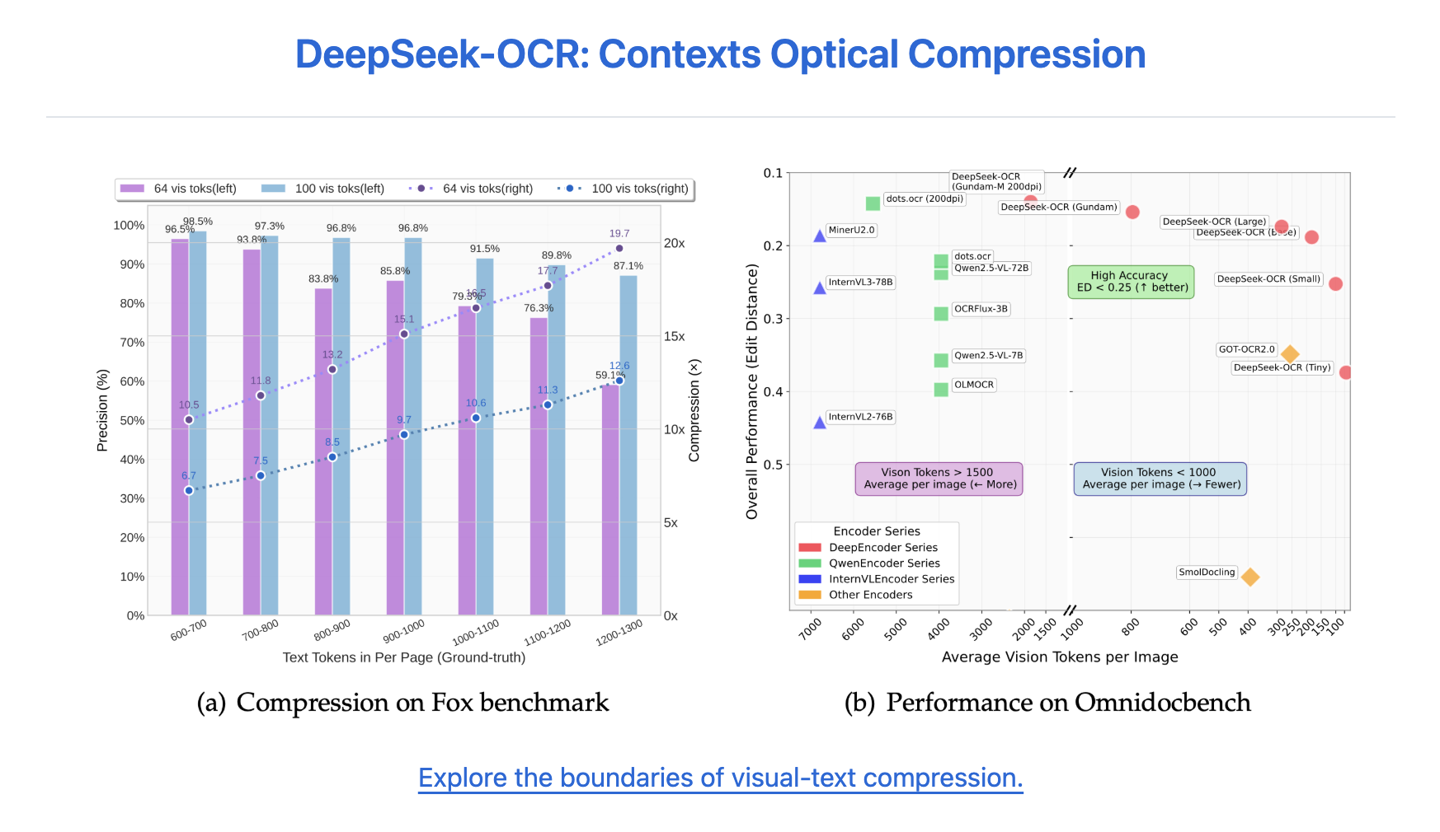

根据介绍,此次开源的 DeepSeek-OCR 由两个部分组成:核心编码器 DeepEncoder 和解码器 DeepSeek3B-MoE-A570M。DeepEncoder 专为在高分辨率输入下保持低计算激活而设计,同时实现高压缩比,以控制视觉 token 数量在可管理的范围内。实验显示,当文本 token 数量不超过视觉 token 的 10 倍(压缩比低于 10×)时,模型的 OCR 精度可达 97%;即便压缩比提高到 20×,准确率仍保持约 60%,展现出在历史文档长上下文压缩和大语言模型记忆机制研究中的巨大潜力。DeepSeek-OCR 同时具备较高的实际应用价值。

在 OmniDocBench 测试中,DeepSeek-OCR 使用 100 个视觉 token 就超过了 GOT-OCR2.0(每页 256 个 token),而使用不到 800 个视觉 token 便优于 MinerU2.0(平均每页超过 6000 个 token)。

在实际生产中,DeepSeek-OCR 可在单块 A100-40G 显卡上每天生成超过 20 万页的大语言模型 / 视觉语言模型训练数据。

IT之家附有关页面如下:

GitHub:https://github.com/deepseek-ai/DeepSeek-OCR

Hugging Face:https://huggingface.co/deepseek-ai/DeepSeek-OCR