“又来了!马斯克和他的AI芯片。”

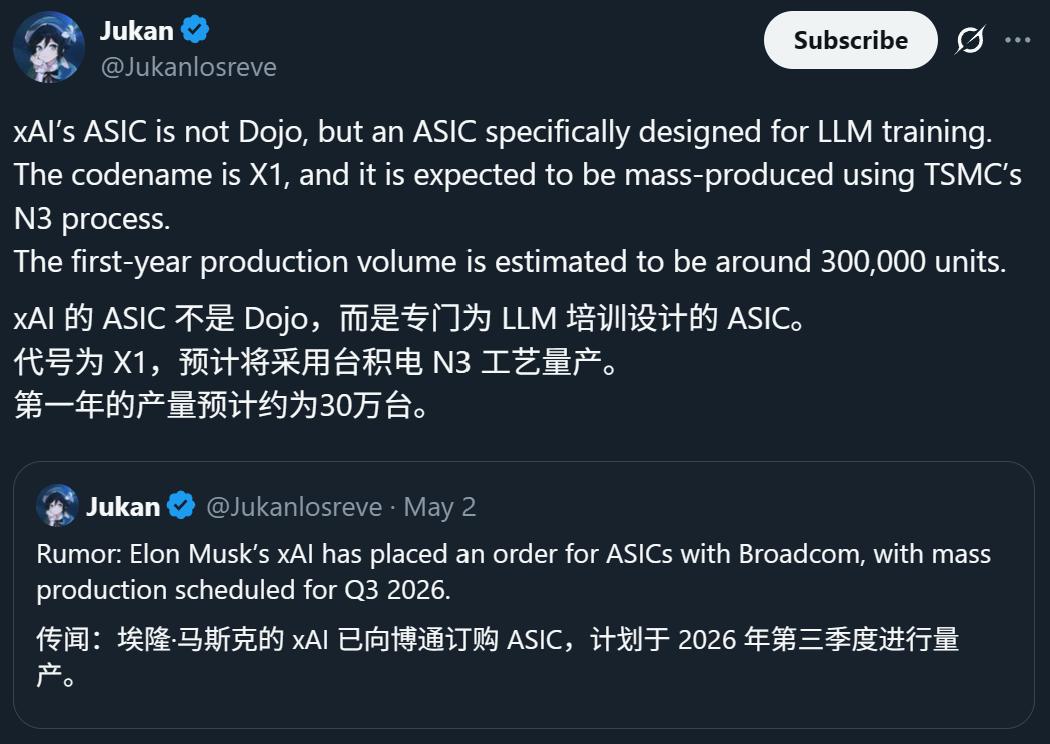

一则关于xAI正采用台积电3nm工艺自研“X1”推理芯片、目标2026年Q3量产的消息,再次引爆了全球科技圈。

表面看,这似乎只是马斯克为解决xAI“算力之渴”、兑现其“5000万块H100”豪言壮语的又一次“暴力美学”操作。

但对我们投资者而言,这颗代号“X1”的小小芯片背后,其实藏着远比“缺芯”本身更重要的信号。它们,正在深刻地、不可逆地改变着整个AI产业的估值逻辑和权力格局。

01

几乎所有的公开报道,都将巨头自研芯片的动机归结为两点:解决芯片短缺和降低采购成本。

这当然是事实,但这只是表面。真正的是三个更深层次的战略考量,每一条都足以改变一家万亿级公司的未来。

1. 摆脱“性能枷锁”

英伟达的GPU,如同成衣店里的高级西装,性能强大,适用性广,是当之无愧的“万金油”。但对于Google、Meta、xAI这些拥有自己独特大模型算法和海量数据流的巨头而言,它们真正需要的,是一套完全贴合自己身形的“高定礼服”。

自研芯片,正是为了实现这种极致的“软硬协同”。

它可以根据自家模型(如xAI的Grok)的特定算法结构和数据处理路径进行深度定制,砍掉所有冗余功能,将每一颗晶体管的效能都压榨到极限。

最终实现通用GPU无法企及的性能功耗比(Performance-per-Watt)。在动辄需要数十万张加速卡的数据中心里,能效每提升一个百分点,都意味着每年节省数亿甚至数十亿美元的电费和运营成本。

这,是花再多钱从外部采购也买不来的核心竞争力。

2. 重构“经济模型”

对于AI巨头而言,依赖外部采购芯片,意味着一笔永无止境、且不断飙升的运营成本(OpEx)。今天一块H100卖4万美元,明天Blackwell架构的B200只会更贵。公司未来的利润模型,被英伟达的定价策略牢牢钳制,这便是业界常说的“英伟达税”。

而自研芯片,则是一场财务魔术。它将这笔不可控的OpEx,转化成了一笔相对可控、且具备长期价值的资本开支(CapEx)。

前期投入数十亿美元进行研发和流片,一旦成功,这笔投入就沉淀为公司的固定资产。后续的生产成本可以被精确控制,规模越大,单位成本越低。

更重要的是,这条自给自足的产线,将成为公司一道深不见底的财务护城河。它彻底改变了公司的长期成本结构,让华尔街的分析师们不得不重新评估其盈利能力和估值模型。

3. 构筑“数据壁垒”

如果说前两点还是关于效率和成本,那么这一点则关乎生存。

专用芯片的设计,本身就是一家公司AI战略和数据处理哲学的物理化身。芯片的架构,决定了数据如何被处理、模型如何被训练和推理。当一家公司拥有了自己独一无二的芯片,就等于拥有了一个与众不同的“数据熔炉”。

这个熔炉能以最高效的方式处理自身业务产生的海量数据,从而训练出更强大的模型;而更强大的模型,又会反过来提出更极致的硬件需求,指导下一代芯片的设计。这就是一个完美的“数据-模型-芯片”正向飞轮。

当这个飞轮转动起来,数据优势就被固化为了难以逾越的物理壁垒。竞争对手即使能复刻你的算法,也无法复刻你跑在定制芯片上的极致效率。

02

媒体津津乐道于xAI与OpenAI在造芯路径上的“1:1复刻”——同样与博通合作,同样专注推理,同样瞄准2026年,同样由台积电代工。

1. 台积电的“甜蜜烦恼”

如今,谁能拿到台积电最先进的产能,谁就扼住了AI时代的咽喉。

根据供应链的最新信息,台积电的3nm工艺产能早已被瓜分殆尽。苹果是绝对的No.1客户,包揽了iPhone和Mac芯片的大部分产能。

紧随其后的,不再是高通、联发科这些传统芯片设计公司,而是Google、Meta、亚马逊、微软这些云和AI巨头。他们为自家的TPU、MTIA以及各种定制服务器芯片,正疯狂地预定2025年甚至2026年的产能。

现在,马斯克和OpenAI也加入了这场“产能战争”。

台积电,俨然成了科技世界的“中央银行”,它向谁“放贷”(分配产能),就决定了谁能在未来的AI军备竞赛中获得充足的“弹药”。半导体行业的权力中心,正以前所未有的速度,从传统Fabless厂商,向手握重金和应用场景的AI巨头们转移。

2. 英伟达的“王者围城”

面对所有顶级客户“揭竿而起”,英伟达真的危险了吗?

答案是否定的,至少现在不是。英伟达最深的护城河,从来不只是芯片本身,而是它经营了近二十年的CUDA生态系统。这是一个由无数代码库、开发工具和数百万开发者组成的软件长城,迁移成本极高。

但“围城”之势已然形成。这些AI巨头自研的芯片,并不需要在公开市场上与英伟达竞争,它们只需要在自己的数据中心里,为自己量身定制的几个核心模型服务。在这个封闭的场景下,CUDA的生态优势被大大削弱。这,才是老黄真正的远忧。

03

面对如此复杂的技术路线和资本棋局,仅仅解读公开信息,如同雾里看花,已难以做出真正高置信度的判断。

要看清牌桌下的底牌,我们需要更深度的视角。就在上周,我们硅兔君组织了一场关于“AI算力与半导体新格局”的闭门圆桌会议。一位曾在谷歌TPU团队担任核心架构师多年的资深专家,为我们的顶级投资人客户,分享了三个极具前瞻性、甚至堪称“非共识”的观点:

一:“推理成本”即将超越“训练成本”,成为AI商业化的最大瓶颈。

“市场和媒体至今仍在狂热地讨论训练万亿参数模型的算力竞赛,但这是过去的战争。未来的战争,是关于如何让数以十亿计的用户,以足够低的成本,每天使用这些模型。

训练是一次性的巨大投入,而推理是持续性的海量消耗。我们内部的模型显示,对于一个成功的AI应用,其整个生命周期的总成本中,推理成本将占到80%-90%。这正是为何xAI、OpenAI的新芯片都首先瞄准‘推理’。看懂了这一点,就看懂了AI商业化的下半场。”

二:真正的“隐形赢家”,可能是博通 (Broadcom)。

“在这场声势浩大的‘逃离英伟达’浪潮中,谁是最大的受益者?不是AMD,也不是任何一家AI创企。而是那个在幕后为Google、Meta、OpenAI、xAI提供定制化ASIC芯片设计服务—博通。

它的商业模式,不是卖标准品,而是与每一个巨头深度绑定,成为它们芯片部门的延伸。无论最终谁的AI模型胜出,只要定制化芯片的趋势不变,博通就能稳坐钓鱼台。它正在成为这场牌局里,最被市场低估的力量。”

三:真正的决战日是2026年的“产能之战”,考验的是供应链终极能力。

“芯片设计图只是入场券。真正的决战,将在2026年台积电的晶圆厂里打响。届时,苹果的A20/M6、英特尔的Lunar Lake、英伟达的‘X100’、以及所有AI巨头的自研芯片,都将汇集在3nm和2nm的产线上。

这不再是技术之争,而是资本实力、供应链管理能力和地缘政治博弈的终极对决。谁能提前锁定更多、更稳定的晶圆产能,谁才能真正将PPT上的性能,变为市场上实打实的算力。投资者现在就应该开始关注各大巨头与台积电的产能绑定协议和预付款规模。”