C114讯 9月23日消息(九九)“液冷虽然已成为主流选择,但是并不能完全取代风冷,风液融合仍是适应技术演进的重要趋势。”——在近日举行的施耐德电气卡车巡展北京站上,施耐德电气关键电源业务,IMDC及边缘计算产品经理汤熠如是说。

汤熠介绍,目前数据中心风液比的典型配置是3:7,预计未来液冷占比会进一步提高。与此同时,整个机柜的功率密度上升会更快,因此风冷的需求也会持续增长。

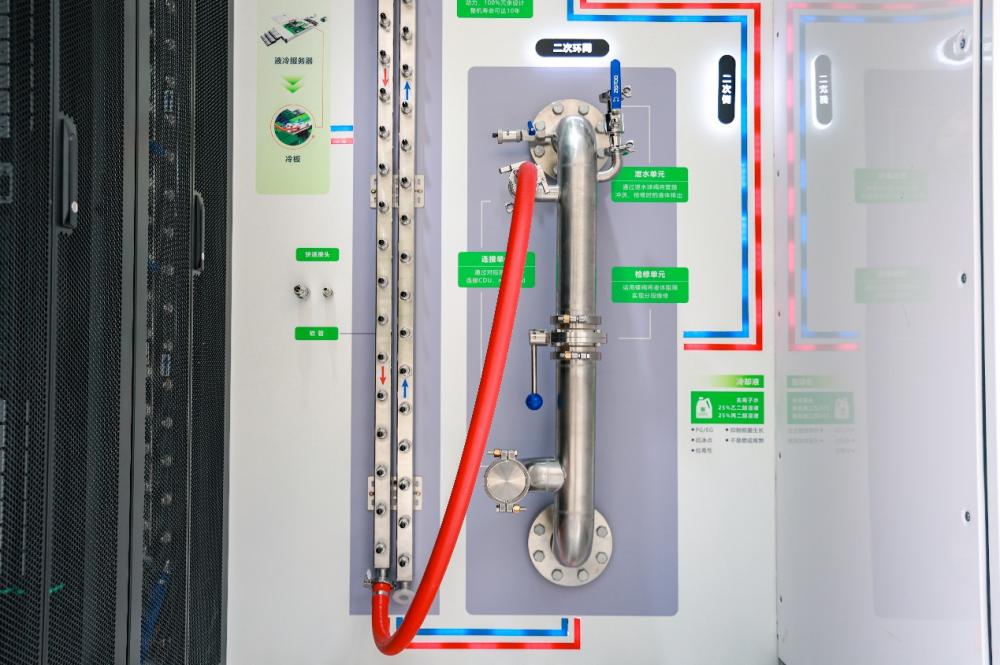

为应对这一趋势,施耐德电气推出的冷板式液冷CDU系统,构建起风液兼容的全栈制冷解决方案,将有效助力客户应对智算时代数据中心的散热挑战。

AI热潮下,数据中心由风冷向液冷平稳过渡

在持续汹涌的AI热潮下,算力产业发展迸发出无限可能,高密度人工智能集群不仅是解锁生产力的关键,也对制冷技术、可持续性等提出了全新要求。

对于机柜功率密度较低(20 kW及以下)的小型AI集群,传统风冷仍是受欢迎的制冷方案。但对于更高机柜功率密度的人工智能集群,液冷因其高效的散热性能,已经从数据中心建设和改造的“可选项”逐步发展为“必选项”。“未来超过50 kW的机柜都会配备液冷系统,这是一个全新的赛道。”汤熠说。

随着液冷应用逐渐普及,市场呈现快速增长趋势。据IDC预计,2023—2028年,中国液冷服务器市场年均复合增速将达到45.8%,2028年市场规模将达到102亿美元。

然而,数据中心全液冷解决方案不可能一蹴而就,在这一过程中,数据中心行业需要综合考量性能、能耗、成本等多重因素,并结合自身实际需求,灵活选择各类制冷方式及架构,从而实现由风冷向液冷的平稳过渡。

风液融合,破局数据中心散热和能耗挑战

在上述背景下,“全栈视角下的风液兼容”正成为破局数据中心散热和能耗挑战的最优解。

基于持续创新的冷却技术与在数据中心行业的丰富制冷实践,施耐德电气冷板式液冷CDU系统覆盖“液-液CDU”和“风-液CDU” 功能场景,为高密度人工智能集群获得更佳的制冷效果提供有效支持。

“液-液CDU”顾名思义,是将液体从冷源侧直接通过管路连接到二次侧,再进入到机柜当中,因此需要搭建的是一次侧和二次侧的管路系统,实现整个冷热液体的循环。而“风-液CDU”则是将一体式的风冷空调跟行级CDU进行整合,通过空调将热的液体转换成热空气,无需考虑管路问题,从而降低初期部署成本并实现快速上线。

“液-液CDU”需要二次侧的管网,由此而来的投资成本是巨大的。在约1 MW的液冷项目中,CDU的投入成本只占到10%~20%,其余约80%左右的投入则在工程、管网以及每一个快速接头和机柜级分水单元。在金额庞大的液冷基础设施投资背景下,诞生出了“风液同源”的设计理念,在一些边缘场景(如四联柜的部署)中,用户可以实现外部冷源与内部冷冻水空调、液-液CDU共用,同时基于机架式风-液CDU和风冷空调,通过‘服务器 - 冷板 - 直连软管’的制冷液输送设计,无需再额外部署液冷管路,有效提升了系统的部署效率,也符合边缘场景对高可用性的需求。

施耐德电气风液兼容的全栈制冷解决方案,正是立足于应用实践与创新研发技术的紧密结合,为用户提供一站式制冷解决方案的部署应用。在研发侧,上海研发中心正是施耐德电气全球唯一的液冷实验室;在供应链侧,施耐德电气珠海工厂则能提供高性价比的全套液冷解决方案。此外,施耐德电气在去年收购了Motivair公司的多数股份,进一步强化其液冷技术和产品布局,并巩固公司在冷板式液冷和高容量热能解决方案方面的专业地位。

完备产品矩阵,赋能智算中心

施耐德电气不仅提供冷板式液冷CDU,更支持电源、配电、制冷、机柜、环境监控管理等在内的物理基础设施单元的模块化、智能化、按需定制、一体交付,为客户提供开箱即用的IT服务。

这就不得不提到施耐德电气IMDC智能模块化数据中心,其全部物理组件可在到达客户现场前实现工厂预制及全面检测,通过边缘控制层级的智能管理及数字化运维软件APP,帮助客户实现快速部署,实现端到端一站式交付和远程数字化管理。

汤熠介绍,IMDC智能模块化数据中心支持所有AI机柜的模块化部署,在长度方面,可以实现20个机柜一组,最大延展到40个IT机组。同时,用户可以选择微模块的部署方式,基于自身需要设计AIDC,实现弹性扩容。

IMDC机柜门的屏幕上集成了2台算力服务器,用于AIDC的监控。汤熠表示,IMDC智能模块化数据中心不仅为AI服务器提供基础设施,也自带AI服务器,支持每8秒钟判定一次内部环境,例如空调温度是否合适等,并利用人工智能进行干涉,使AIDC空调能耗每年下降30%,大幅提升运维成本。

不止于制冷侧,供配电系统亦是AI演进过程中,行业首当其冲的一大挑战。施耐德电气关键电源业务,系统业务产品经理连博指出,AI驱动下的算力变革正在深刻重塑电力需求与使用模式。AI工作负载所具有的高密度、高能耗、波动大等显著特性,供配电系统更面临多重挑战。

未来,机柜功率密度从传统的5 kW、10 kW提升到30 kW、100 kW甚至更高,最直观的差异体现在数据中心灰区和白区的面积配比,常见数据中心灰区跟白区的比例约为1:1,但在未来可能会演变为7:3。

施耐德电气Galaxy VXL UPS能大幅提升空间利用率,其单机功率最高可达1.25 MW,其紧凑的设计仅占地面积1.2 m2。反观传统1 MW以上的UPS,占地面积基本都在4㎡以上,Galaxy VXL UPS无疑将为IT负载的部署释放更多空间。

作为高安全可靠的关键一环,施耐德电气Galaxy VXL UPS在安全可靠性上同样表现出色,其具备TÜV认证的在线插拔(Live Swap)功能,可为操作人员安全和设备安全提供强有力的保障,支持用户在系统运行时实时更换模块。这一创新功能不仅显著减少维护时间,也可确保在更换过程中,即使出现异常,拉弧能量也能被有效控制在1.2cal/cm²以下,从而极大地降低安全风险。

从冷板式液冷CDU,到智能模块化数据中心IMDC,再到Galaxy VXL UPS,施耐德电气以全链路的制冷方案、创新的配电产品和一体化的服务能力,为适配未来的智算中心提供坚实支撑。

在智算产业高速发展的背景下,施耐德电气将持续依托技术研发、供应链整合与行业实践经验,助力更多客户应对散热、能耗、供配电等核心挑战,为智算中心的高效、可持续运行注入强劲动力。