C114讯 9月24日消息(九九)2025云栖大会今天在杭州开幕,阿里巴巴集团CEO、阿里云智能集团董事长兼CEO吴泳铭发表主旨演讲。阿里巴巴集团CEO吴泳铭宣布阿里云重磅升级全栈AI体系,

数据中心内的计算范式正在发生革命性改变,从CPU为核心的传统计算,正在加速转变为以 GPU为核心的AI计算。AI计算范式需要更稠密的算力、更高效的网络、更大的集群规模,需要超大规模的基础设施和全栈的技术积累,只有超级AI云才能够承载这样的海量需求。“未来,全世界可能只会有5-6个超级云计算平台。”吴泳铭说。

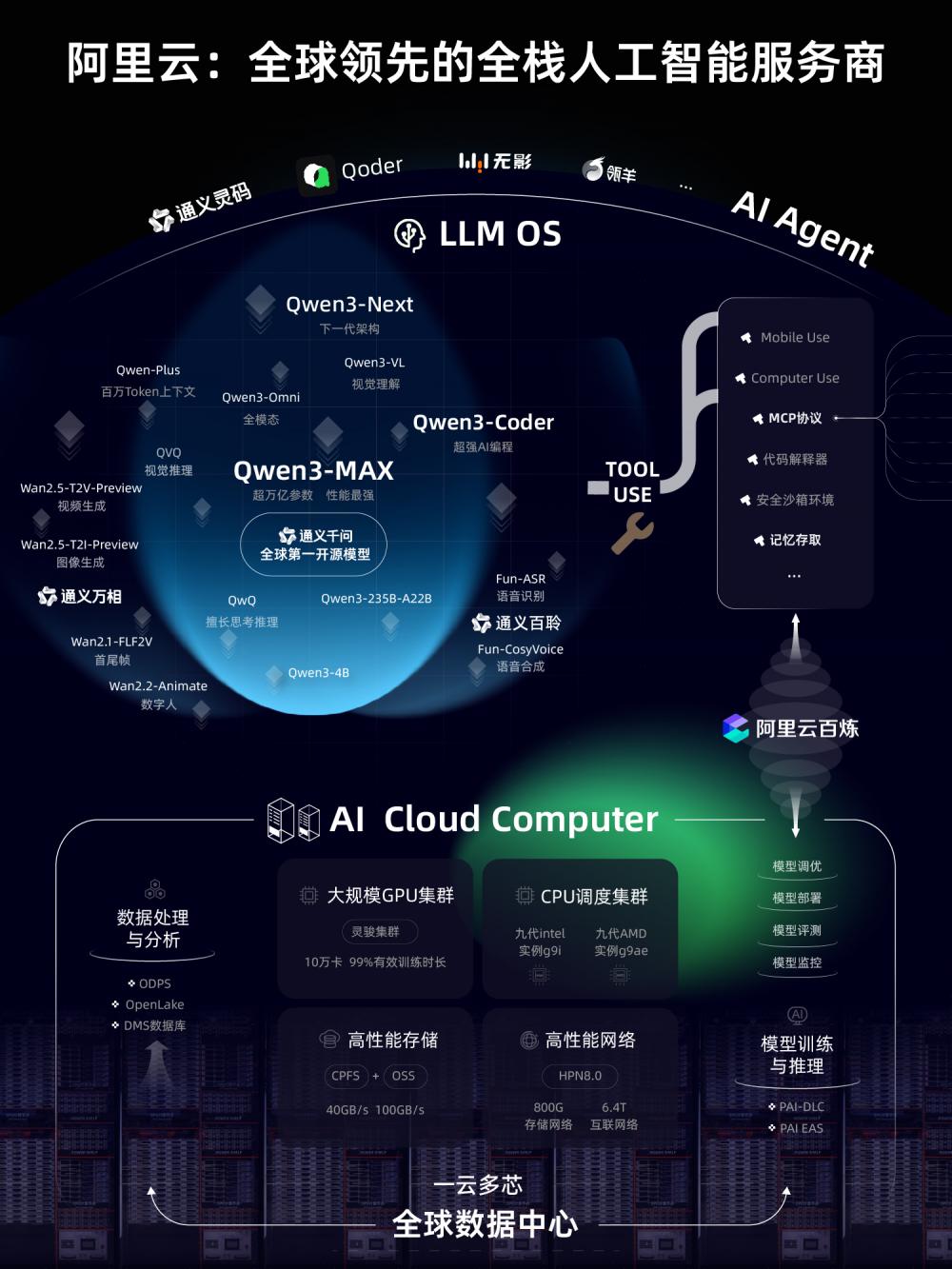

吴泳铭认为,在这个新时代,AI将会替代能源的地位,成为最重要的商品。绝大部分AI能力将以Token的形式在云计算网络上产生和输送,Token就是未来的电。在这个新时代,阿里云的定位是全栈人工智能服务商,提供世界领先的智能能力和遍布全球的AI云计算网络,向全球各地提供开发者生态友好的AI服务。

通义大模型7连发

2025云栖大会上,阿里云智能首席技术官周靖人发布多项重磅技术更新。通义大模型7连发,在模型智能水平、Agent工具调用和Coding能力、深度推理、多模态等方面实现多项突破。

在大语言模型中,阿里通义旗舰模型Qwen3-Max全新亮相,是通义千问家族中最大、最强的基础模型,预训练数据量达36T tokens,总参数超过万亿,拥有极强的Coding编程能力和Agent工具调用能力。

下一代基础模型架构Qwen3-Next及系列模型正式发布,模型总参数80B仅激活 3B ,性能即可媲美千问3旗舰版235B模型,实现模型计算效率的重大突破。

在专项模型方面,千问编程模型Qwen3-Coder重磅升级。新的Qwen3-Coder与Qwen Code、Claude Code系统联合训练,应用效果显著提升,推理速度更快,代码安全性也显著提升。

在多模态模型中,千问备受期待的视觉理解模型Qwen3-VL重磅开源,在视觉感知和多模态推理方面实现重大突破,在32项核心能力测评中超过Gemini-2.5-Pro和GPT-5。

全模态模型Qwen3-Omni惊喜亮相,音视频能力狂揽32项开源最佳性能SOTA,可像人类一样听说写,应用场景广泛,未来可部署于车载、智能眼镜和手机等。

通义大模型家族中的视觉基础模型通义万相,推出Wan2.5-preview系列模型,涵盖文生视频、图生视频、文生图和图像编辑四大模型。

此外还有通义大模型家族的全新成员——语音大模型通义百聆,包括语音识别大模型Fun-ASR、语音合成大模型Fun-CosyVoice。Fun-ASR基于数千万小时真实语音数据训练而成,具备强大的上下文理解能力与行业适应性;Fun-CosyVoice可提供上百种预制音色,可以用于客服、销售、直播电商、消费电子、有声书、儿童娱乐等场景。

据介绍,通义大模型已成为全球第一开源模型,也是中国企业选择最多的模型。截至目前,阿里通义开源300余个模型,覆盖不同大小的“全尺寸”及LLM、编程、图像、语音、视频等“全模态”,全球下载量突破6亿次,全球衍生模型17万个,稳居全球第一。超100万家客户接入通义大模型,权威调研机构沙利文2025上半年报告显示,在中国企业级大模型调用市场中,阿里通义占比第一。

百炼平台发布全新Agent开发框架

作为一站式模型服务和Agent开发平台,阿里云百炼也带来了重磅升级。大会现场,阿里云发布全新Agent开发框架ModelStudio-ADK,该框架突破以预定义编排方式开发Agent的局限,可帮助企业高效开发具备自主决策、多轮反思和循环执行能力的Agent。

随着模型能力的不断提升以及Agent应用的爆发,过去一年,阿里云百炼平台的模型日均调用量增长了15倍。

在框架层面,阿里云ModelStudio-ADK基于通义开源的AgentScope打造,可开发深度研究、硬件代理智能体、复杂检索智能体等应用。该框架还全面支持云端部署和云端组件调用,提供企业级、服务稳定、灵活部署和运行的高代码开发模式,帮助企业和开发者快速实现复杂场景Agent的开发和落地。

在模型层面,阿里云百炼持续上线全新通义千问家族旗舰模型,基于Qwen3系列模型强大的推理能力,可驱动Agent实现更高效的自主规划与决策,推理性能提高50%,决策成功率达到90%。

在组件层面,面向Agent开发和部署所需的各类组件,阿里云百炼集成了工具连接MCP Server、多模数据融合RAG Server、沙箱工具Sandbox Server、智能记忆存取Memory Server以及支付订阅服务 Pay Server等7大企业级能力。以Pay Server为例,该服务由阿里云百炼和支付宝联合首发推出,是业界首个为企业级Agent提供专业商业化支付通道的服务。

AI基础设施全面升级

阿里云围绕AI进行了软硬全栈的协同优化和系统创新,已初步形成以通义为核心的操作系统和以AI云为核心的下一代计算机。过去一年,阿里云AI算力增长超5倍,AI存力增长4倍多。

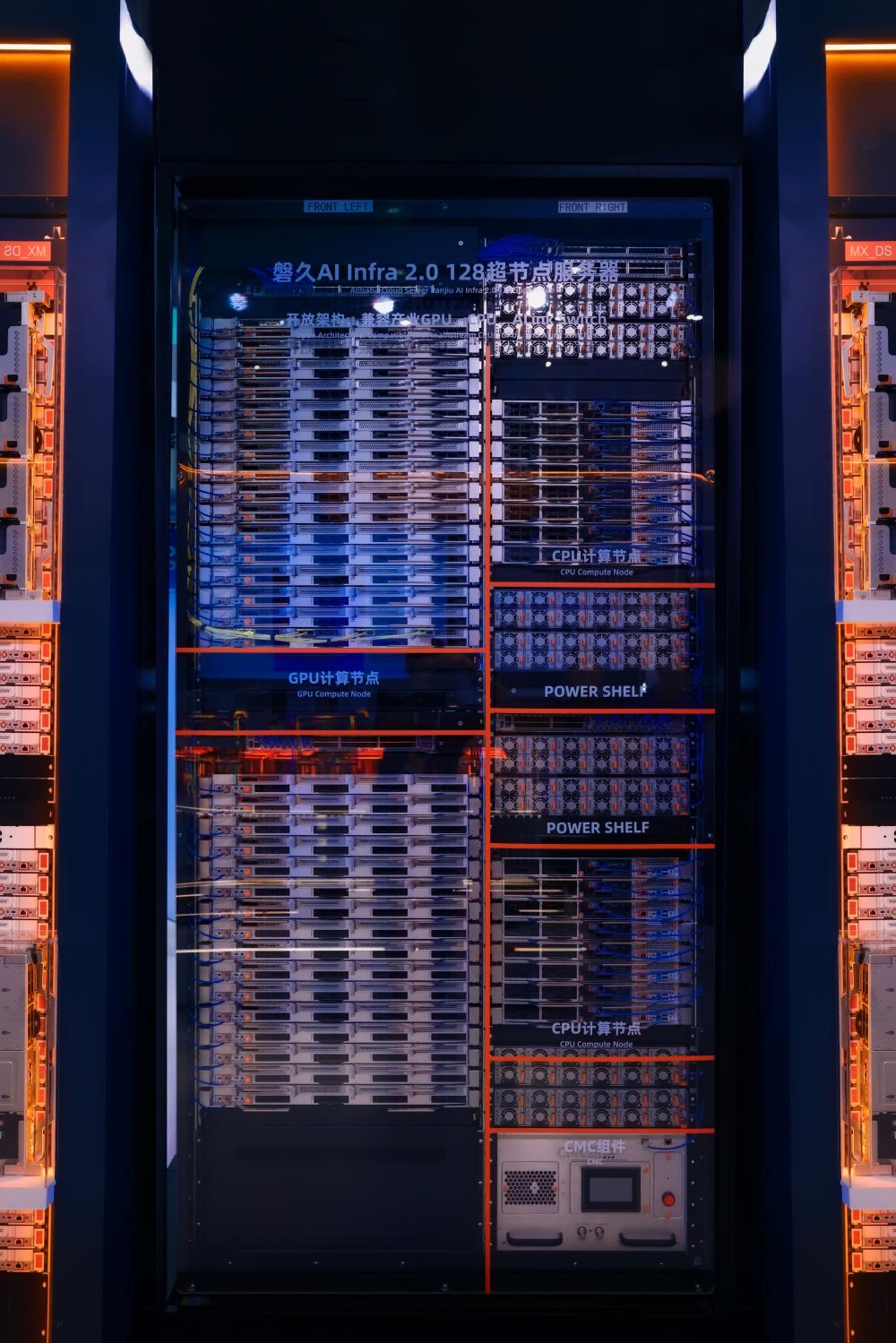

2025年云栖大会现场,全面升级的阿里云AI基础设施重磅亮相,全面展示了阿里云从底层芯片、超节点服务器、高性能网络、分布式存储、智算集群到人工智能平台、模型训练推理服务的全栈AI技术能力。

在服务器层面,阿里云发布全新一代磐久128超节点AI服务器。新一代磐久超节点服务器由阿里云自主研发设计,具备高密度、高性能和高可用的核心优势,可高效支持多种AI芯片,单柜支持128个AI计算芯片,密度刷新业界纪录。磐久超节点集成阿里自研CIPU 2.0芯片和EIC/MOC高性能网卡,采用开放架构,扩展能力极强,可实现高达Pb/s级别Scale-Up带宽和百ns极低延迟,相对于传统架构,同等AI算力下推理性能还可提升50%。

在网络层面,阿里云新一代高性能网络HPN 8.0全新亮相。为应对大模型时代对海量数据传输的需求,HPN8.0采用训推一体化架构,存储网络带宽拉升至800Gbps,GPU互联网络带宽达到6.4Tbps,可支持单集群10万卡GPU高效互联,为万卡大集群提供高性能、确定性的云上基础网络,助力AI训推提效。

在存储层面,阿里云分布式存储面向AI需求全面升级。高性能并行文件存储CPFS单客户端吞吐提升至40GB/s, 可满足AI训练对快速读取数据的极致需求;表格存储Tablestore为Agent提供高性能记忆库和知识库;对象存储OSS推出 Vector Bucket,为向量数据提供高性价比的海量存储,相比自建开源向量数据库,成本骤降95%,结合OSS MetaQuery 语义检索和内容感知能力,可快速构建RAG等AI应用。

在AI智算集群层面,智能计算灵骏集群通过多级亲和性与拓扑感知调度设计,基于HPN 网络支持10万卡稳定互联,多级可扩展的架构让每张卡间互联路径更短、带宽更优。灵骏集群面向任务的稳定性设计、故障分钟级恢复能力,有效提高了模型训练任务的集群稳定性。

AI需求爆发也带动了通用算力需求上升,阿里云通用计算全面升级。依托自研的“飞天+CIPU”架构体系,阿里云第九代企业级实例采用英特尔、AMD的最新芯片,在大幅提升算力水平的同时,可为Agent提供稳定、安全、高性能的通用CPU算力。其中,九代AMD实例g9ae提供物理核的规格,性能最高提升67%,尤其适合企业离线数据分析处理、视频转码等高并发场景。

“阿里云正在全力打造一台全新的AI超级计算机,它同时拥有最领先的AI基础设施和最领先的模型,两者可以在产品设计和运行架构上高度协同,从而确保在阿里云上调用和训练通义千问模型时,能达到最高效率。”吴泳铭表示。