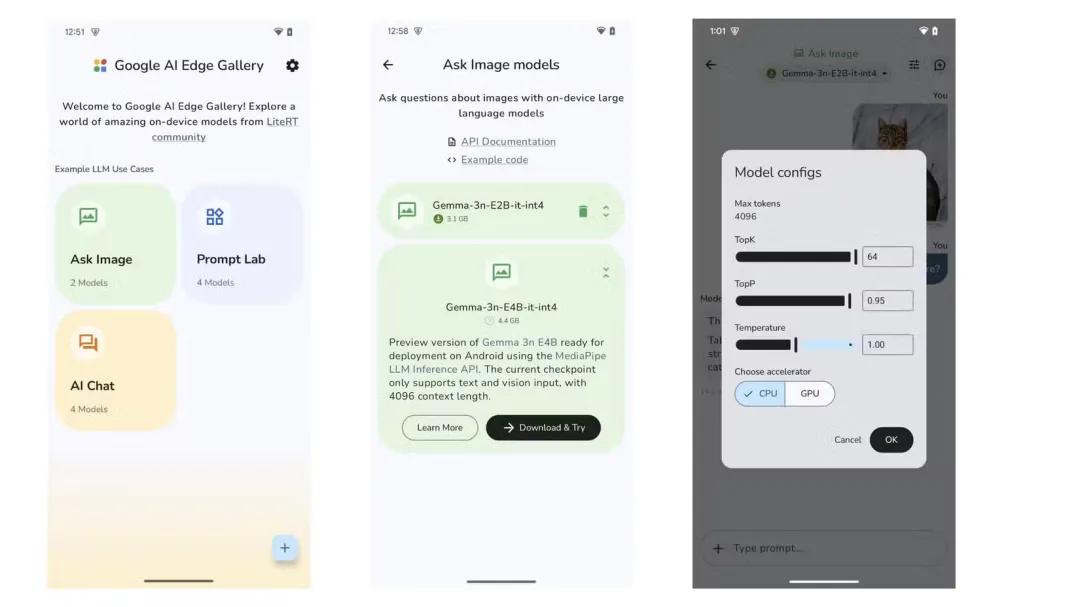

近日,据 TechCrunch 报道,谷歌悄然推出了一款名为 Google AI Edge Gallery 的应用(谷歌称之为“实验性 Alpha 版本”),用户无需 Wi-Fi 连接即可在设备上运行 AI 模型。这款应用目前仅适用于 Android 系统,允许用户使用 Hugging Face 的几款“公开可用的 AI 模型”,这标志着谷歌在将先进的 AI 技术直接引入移动设备方面迈出了重要一步。

谷歌悄然发布一款新 AI 应用

这款全新 AI 应用允许用户搜索公开可用的 AI 模型,下载后无需连接 Wi-Fi 即可在本地运行。在本地运行这些模型时,用户可以要求 AI 执行几乎所有连接 Wi-Fi 时通常会执行的操作,例如生成图像、与 AI 聊天、浏览网页、编写代码以及提问。

总结起来,主要特点包括:

- 本地运行,完全离线:无需网络连接,所有处理都可直接在本地设备上进行。

- 智能模型选择:轻松在 Hugging Face 的不同模型之间切换并比较它们的性能。

- 图像问答:上传图片并提出相关问题。获取描述、解决问题或识别物体。

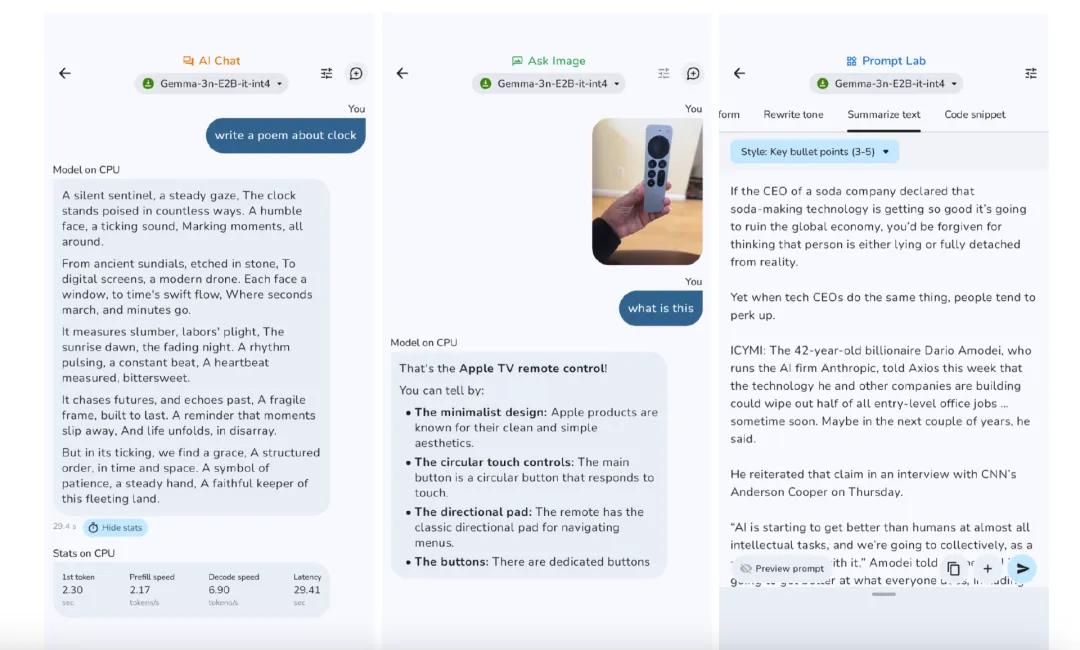

- Prompt Lab:用户可以使用它来启动由模型驱动的“单轮”任务,例如摘要和重写文本。Prompt Lab 附带多个任务模板和可配置的设置,用于微调模型的行为。

- AI 聊天:可进行多轮对话。

- 性能洞察:实时基准(TTFT、解码速度、延迟)。

- 自带模型:测试用户本地的 LiteRT.task 模型。

- 开发者资源:模型卡和源代码的快速链接。

GitHub 项目地址:https://github.com/google-ai-edge/gallery/wiki

虽然本地 AI 模型显然无法做到所有需要互联网连接的典型 AI 模型所能做到的事情,但它们仍然拥有不少优势。首先,本地 AI 模型的响应速度更快,因为无需等待服务器响应而产生延迟。

这是因为本地 AI 模型充分利用了设备处理器的强大功能,并且所有数据都在设备上运行,而不是在云端。由于所有数据都基本不离开设备,因此数据被拦截、存储或滥用的风险显著降低。

此外,对于注重隐私的用户来说,本地 AI 模型是一个绝佳的选择。当然还有另一个显而易见的好处是,无需寻找稳定的 Wi-Fi 或移动网络即可使用本地 AI 模型。

值得注意的是,谷歌警告称,实际性能可能会有所不同。拥有更强大硬件的现代设备可以预见地更快地运行模型,但模型大小也很重要。与较小的模型相比,较大的模型完成一项任务(例如,回答有关图像的问题)所需的时间会更长。

那么,Google AI Edge Gallery 是如何工作的?

事实上,可以将这款应用视为一个平台,用于运行 AI 开发平台 Hugging Face 上提供的第三方 AI 模型。应用的主屏幕包含三个独立的部分——图像问答、提示实验室和 AI 聊天。

当用户点击“Ask Image”和“AI Chat”时,该应用会向他们展示所有符合其需求的 AI 模型。“Prompt Lab”部分允许用户“总结、重写、生成代码,或使用自由形式的提示来探索单轮法学硕士(LLM)的用例”。使用“Ask Image”,您可以“上传图片并提出相关问题,获取描述、解决问题或识别物体”。

同样,AI 聊天部分可让用户与 AI 模型进行逐个对话。

Google AI Edge Gallery 目前可以在 Android 设备上下载。它目前尚未在 Play Store 上架,但用户可以使用官方用户指南并下载 APK 文件从 GitHub 获取。Google 还提到,它也即将在 iOS 设备上推出。

用户:把我手机搞崩溃了

该款应用推出后,在 Hacker News、Reddit 等平台上有许多网友进行了实际测试,有人认为这款应用体验起来感受不错,也有人称用过后把手机搞崩溃了。

就使用体验而言,有些用户认为,它并不尽如人意。

“上周 v1.0.1 刚发布时,我试用了一下,结果直接把我的 Pixel 7 搞崩溃了。几天前我又试了试 v1.0.3,情况稍微好了一些,但 CPU 推理速度很慢。我给一个也有 Pixel 7 的朋友看了,他的推理速度更快。后来,当我们尝试使用 GPU 进行后续提问时,这款应用在我们两部手机上都崩溃了。”

同样使用谷歌手机 Pixel 6a 的用户表示,的确出现了应用程序崩溃的现象。

“当我尝试在 Pixel 6a 上切换到 GPU 推理时,应用程序崩溃了。”

对于上述两位用户的评论,也有网友出来反驳称,可能是个别手机点问题,并不是普遍现象。

“我不确定你的问题是不是手机的问题。我用的是两年前的中档摩托罗拉手机(2023 MotoG Stylus),我一直用它来从截图中提取文本,至少 90% 的情况下它都能顺利运行而不会崩溃。每个上下文窗口只能显示一张图片。但 4B 每次都会让它崩溃。”

也有人晒出了该应用程序在其手机上运行的截图,截图显示该应用在网友的 Pixel 7 Pro 上运行良好。

还有人表示,无论是否运行良好,都没什么值得炫耀的,因为这并不是什么新技术,Play Store 上有多个应用程序允许在本地运行大语言模型,比如 PocketPal 和 Private AI。

比 CoreML 落后很多年?

这款产品发布后,除了网友评价褒贬不一外,还有人认为它只是对 TensorFlow Lite + MediaPipe 在新“品牌”下的重新包装,并将其与苹果核心机器学习框架产品 CoreML 做比较,认为谷歌这款应用已经落后好几年了。

“与 CoreML 和 TimyML 等框架现有的产品相比,这款应用程序落后了好几年。此外,谷歌必须首先证明他们不会为了满足下一季度投资者的预期而放弃该产品。”

Core ML 是 Apple 开发的框架,用于在 iOS、macOS、tvOS 和 watchOS 设备上运行机器学习模型。它专为设备端推理而设计,在保护数据隐私的同时,最大限度地减少内存占用和功耗。它充分利用 Apple 芯片(包括 CPU、GPU 和神经引擎),最大限度地提高速度,并最大限度地减少内存占用和功耗。

它与 Vision(用于图像和视频分析)、Natural Language(用于文本处理)以及 GameplayKit(用于游戏 AI)兼容。使用 TensorFlow、PyTorch 或其他框架训练的模型可以使用 Core ML 工具转换为 Core ML 格式,从而可以直接在 Apple 设备上部署现有模型。CoreML 的工作原理包括:

- 模型准备:ML 模型在强大的计算机上进行训练,并转换为 Core ML 格式(.mlmodel),针对 Apple 硬件进行优化 - 使用 Core ML 工具;

- 集成:文件 .mlmodel 已添加到 Xcode 项目中。Xcode 会自动为模型生成一个 Swift 或 Objective-C 类 ( .mlmodelc),提供类型安全的输入和输出访问;

- 执行:应用程序将输入数据(例如图像、文本)传递给模型。Core ML 将计算任务调度到最合适的硬件(CPU、GPU 或神经引擎),以实现高效的推理;

- 状态模型:最近的 Core ML 更新支持状态模型(例如生成式 AI 中使用的模型),管理状态(例如语言模型的键值缓存)以提高效率并降低开销;

- 性能分析: 用户可以使用 Xcode 和 Core ML Tools 中的工具分析模型性能、识别瓶颈并针对特定硬件优化模型;

有网友用亲身经历反驳了上述观点,认为谷歌的这款应用程序和苹果 Core ML 是不同的产品。没什么可比性,也并不是落后。该网友称:

“CoreML 是 Apple 生态的专用工具,允许用户将 PyTorch 模型转换为 .mlmodel 格式,从而在 iOS/macOS 设备上高效运行。

相比之下,Google MediaPipe 是一个强大的跨平台 C++ 库,支持在 iOS、Android 和 Web 等多种设备上部署机器学习流程。它不仅集成了 TensorFlow Lite(现称 LiteRT),还提供了图形化的数据处理能力,可高效执行常见的机器学习预处理任务(如图像缩放、标注等)。

虽然谷歌早期的一些产品因频繁淘汰而饱受调侃,但 MediaPipe 是开源的,这一点值得肯定。我曾基于它的一个分支开发了一款 跨平台计算机视觉产品(iOS/Android),尽管架构复杂,但运行效果出色——而这样的跨平台能力,CoreML 是无法实现的。”

使用 CoreML 一段时间的用户表示自己花了一段时间调整了一个自定义的 PyTorch 模型,让它导出到 CoreML,结果它到处都是这样那样的错误,要么是不支持,要么是分段错误,还有各种莫名其妙的错误,很让人失望。

但当他在评论区询问 Google AI Edge Gallery 是否是 CoreML 的替代品时,有用户劝他别用 Google AI Edge Gallery 了,因为也不好用。

我花了几分钟就在 Pixel 8a 上配置并测试了 Gemma3 1B 模型,整个过程出乎意料地顺利,这让我很惊喜。

但实际表现简直糟透了!它几乎无法正确理解问题,甚至都不尝试给出像样的回答,生成的英语回复也极其勉强。我就问了一个简单的问题:'为什么这么小的模型能在手机本地运行?'结果它的回答质量差到让我直接放弃了这个模型。

我原本就对 AI 没抱什么期待,这真是个很大的问题。

那么,谷歌推出这样一款产品,受众是谁?

有网友推测,这款产品的目标受众是所有需要跨平台部署机器学习模型的人,特别是那些需要超出 TFLite 运行时功能支持的人。大语言模型和计算机视觉任务就是典型的例子。

以手势识别系统为例,它可能需要完成以下步骤:

- 将输入图像预处理为特定颜色空间并调整尺寸

- 将图像数据复制到 GPU 内存

- 运行对象检测 TFLite 模型来识别手部位置

- 调整输出图像尺寸

- 运行手势识别 TFLite 模型来解析手势

- 对手势输出进行后处理,转换为有意义的指令

在 iOS 和 Android 平台上实现这样的功能,需要编写大量超出 TFLite 模型本身的代码。

Google Mediapipe 的解决方案是将这些图形处理流程和可共享的处理“节点”打包成一个 C++ 库。开发者可以从中选择需要的组件,并在不同任务间复用这些操作。这个库不仅支持跨平台编译,还为支持的任务提供了 GPU 加速选项。

该网友还猜测,Google 内部可能讨论过:是应该将这些功能扩展到 TFLite 运行时中,还是应该单独开发一个库(Mediapipe)。毕竟 TFLite 已经支持自定义编译选项和附加操作。

最后他们的结论是:让 TFLite 继续专注于“基于 Tensor 的计算”核心任务,而将大语言模型、图像处理等更广泛的功能放在单独的库中实现。

参考链接:

https://xpert.digital/en/google-ai-edge-gallery/

https://annjose.com/post/mobile-ondevice-ai/

https://techcrunch.com/2025/05/31/google-quietly-released-an-app-that-lets-you-download-and-run-ai-models-locally/