一篇发表于2015年的论文,在十年后,于国际机器学习大会(ICML)2025上,被授予了“时间检验奖”(Test of Time Award)。

这篇论文就是深度学习领域无人不晓的《Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift》。

它的出现,从根本上改变了研究者们训练深度神经网络的方式,成为AI技术发展进程中的一座关键里程碑。

一、一座无法绕过的丰碑

国际机器学习大会(ICML)的时间检验奖,旨在表彰十年前发表的、并在此后十年间对整个领域产生深远影响的论文。

获奖,意味着一项研究不仅在当时具有开创性,更重要的是,它的思想和方法经受住了时间的考验,成为了后续无数研究的基石。

Batch Normalization(批次归一化,简称BatchNorm)的获奖,可谓实至名归。

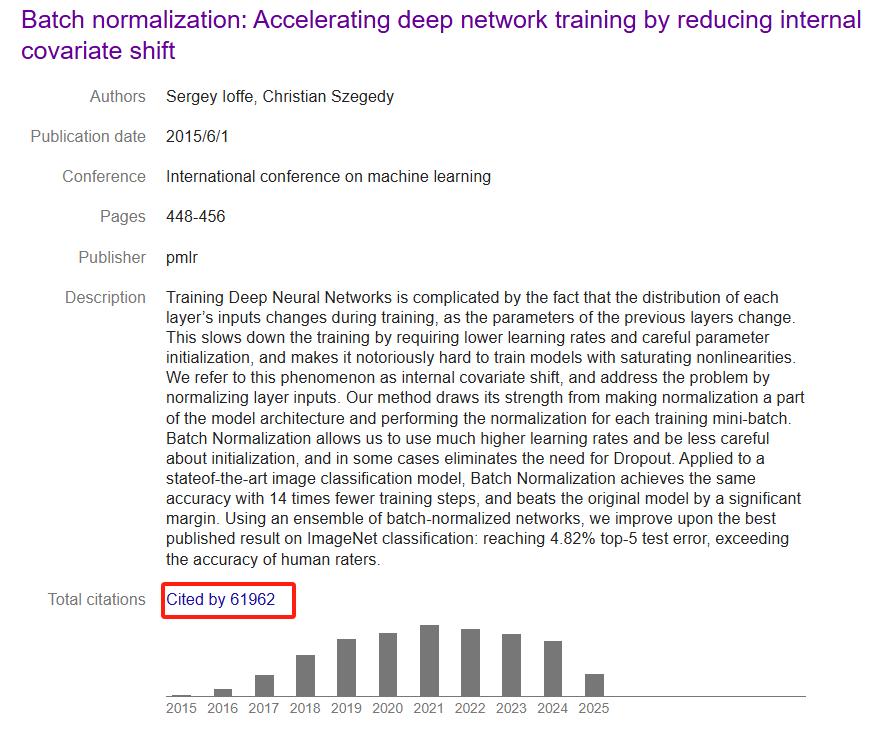

自2015年由谷歌研究员Sergey Ioffe和Christian Szegedy提出以来,这篇论文的引用量已超过六万次,是其所在时代被引用次数最多的深度学习文献之一。

在工程实践中,BatchNorm更是成为了一个“默认选项”。开发者在构建神经网络时,几乎会下意识地在卷积层或全连接层后加入一个BatchNorm层。

它就像是修建高楼时必不可少的钢筋结构,为模型的深度和稳定性提供了基础保障。

可以说,如果没有BatchNorm,今天我们所熟知的许多深度学习模型架构,或许根本无法被有效训练。

它的出现,不仅解决了一个具体的工程难题,更重要的是,它为整个领域注入了强大的动能,使得训练更深、更复杂的网络成为可能。

这座技术丰碑,至今仍然是所有深度学习从业者无法绕过的存在。

二、一场“拨乱反正”的革命

在BatchNorm出现之前,训练深度神经网络是一件充满挑战甚至痛苦的事情。

一个核心的难题,被论文作者称为“内部协变量偏移”(Internal Covariate Shift)。这个术语听起来很复杂,但它描述的现象却很直观。

在神经网络的训练过程中,网络由许多层堆叠而成,前一层的参数更新,会导致后一层接收到的输入数据分布发生变化。

这就好比一个射击手在瞄准一个不断移动的靶子,网络中的每一层都必须持续适应这种变化。

这种不稳定的学习环境,极大地拖慢了模型的训练速度。

为了应对这个问题,研究人员不得不小心翼翼地设置学习率,通常只能选择一个非常小的值,以防止梯度爆炸或消失。

同时,他们还需要对网络权重进行精巧的初始化,这本身就是一门复杂的“玄学”。

训练一个拥有饱和非线性激活函数(如Sigmoid或tanh)的深度模型,在当时被认为是极其困难的。

BatchNorm的出现,如同一场“拨乱反正”的革命,彻底改变了这一局面。

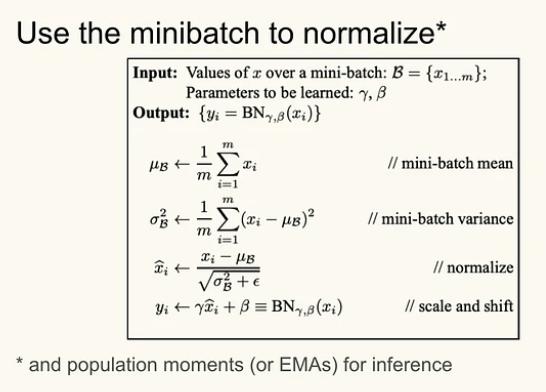

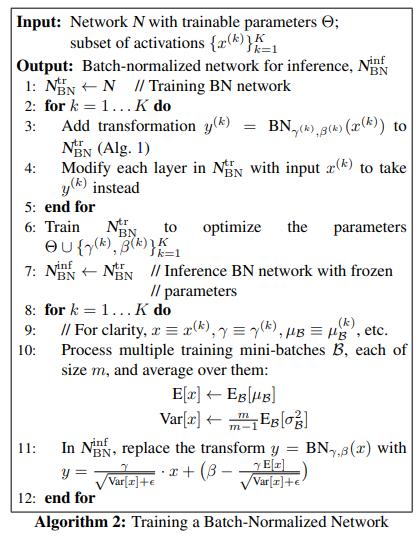

它的核心思想简单而有效:在每一层的输入端,对数据进行归一化处理。

具体来说,它在每次训练迭代中,利用当前小批量(mini-batch)的数据,计算出每个特征维度的均值和方差。

然后,用每个样本减去均值,再除以标准差,将这一批数据的分布强制“拉回”到均值为0、方差为1的标准正态分布。

这相当于为网络的每一层都提供了一个稳定的、标准化的“靶子”。

为了保证网络的表达能力不受影响,BatchNorm还引入了两个可学习的参数(gamma和beta),允许网络在归一化之后,对数据进行缩放和平移,学习恢复其原始的分布信息。

这一操作,被巧妙地设计为网络架构的一部分,随着网络的训练而自动优化。

BatchNorm带来的好处是立竿见影的。

首先,它允许研究者使用非常高的学习率,从而将训练速度提升数倍甚至数十倍。

论文中的实验表明,在一个当时最先进的图像分类模型上,使用BatchNorm后,仅用原来1/14的训练步数,就达到了相同的精度。

其次,它降低了模型对权重初始化的敏感度,研究者不再需要花费大量精力去“炼丹”般的调参。

此外,由于BatchNorm在每个小批量中引入了由该批次数据统计量带来的轻微噪声,它还起到了一种正则化的作用,在某些情况下甚至可以取代Dropout,有效防止了模型过拟合。

可以说,BatchNorm以一种优雅的工程方式,驯服了深度神经网络这匹难以驾驭的“野马”。

三、一个“喧嚣”时代的开启

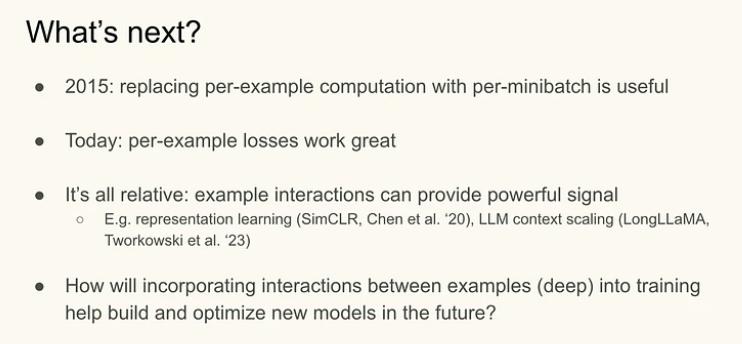

BatchNorm的成功,是工程上的巨大胜利,但围绕它的理论探讨,却开启了一个“喧嚣”的时代。

尽管论文的两位作者将其成功归因于“减少了内部协变量偏移”,但这个解释在后来的几年里,受到了持续的审视和挑战。

一些后续的研究发现,BatchNorm的有效性与内部协变量偏移的减少之间,并不存在必然的因果关系。

有实验表明,即使在某些情况下,BatchNorm反而增加了内部协变量偏移,模型的性能依然得到了提升。

新的理论开始涌现,试图从其他角度解释BatchNorm的魔力。

其中一个被广泛接受的观点认为,BatchNorm的核心作用在于平滑了优化过程中的损失函数曲面(Optimization Landscape)。

通过重新参数化网络,它让损失函数的“地形”变得更加规整,减少了许多崎岖的“山谷”和“尖峰”,使得梯度下降算法可以更稳定、更快速地找到最优解。

这种理论上的争议,丝毫没有动摇 BatchNorm 在实践中的统治地位。

它与残差连接(Residual Connections)等技术相结合,共同催生了以ResNet为代表的超深度网络架构的诞生。

没有BatchNorm提供的稳定梯度流,训练上百层甚至上千层的网络是不可想象的。

它的成功,也激发了对“归一化”这一思想的深入探索。

研究者们意识到,在网络内部对数据分布进行规范,是一个极其强大的工具。

随后,一系列新的归一化方法被提出,例如层归一化(Layer Normalization)、实例归一化(Instance Normalization)和组归一化(Group Normalization)等。

这些方法各有侧重,适用于不同的任务场景,例如RNN或者小批量尺寸不固定的情况,但它们都共享了BatchNorm的核心思想。

十年过去,BatchNorm不再是唯一的选择,但它依然是应用最广泛、最基础的归一化技术。

它不仅是一个具体的算法,更是一种设计哲学,深刻地影响了深度学习领域的思维范式。

它用一种简单、粗暴但极其有效的方式,解决了深度学习从理论走向大规模应用的关键瓶颈,开启了一个模型架构设计百花齐放的繁荣时代。这或许就是“时间检验奖”想要真正表彰的、不朽的贡献。