用 AI 检查同一份合同,两次给出的风险提示可能不同;

向智能客服咨询同样问题,得到的答案可能不一致。

这种随机性是 AI 行业长期存在的技术痛点。

OpenAI 前 CTO Mira Murati 创办的 Thinking Machines Lab(简称 TML),正针对这一问题开展研究,其最新进展或为 AI 可靠性提升提供解决方案。

Thinking Machines Lab:未出产品已获资本关注

2025 年 2 月,Mira Murati 离开 OpenAI 四个月后,正式成立 Thinking Machines Lab。

该公司成立七个月,未发布任何产品,已完成 20 亿美元种子轮融资,估值达 120 亿美元。

领投方为硅谷风投 a16z,英伟达、AMD、思科等科技企业参与投资。

TML 团队共 30 人,三分之二来自 OpenAI,包括 OpenAI 联合创始人 John Schulman、前研究副总裁 Barret Zoph,二人均为 ChatGPT 核心技术开发者。

AI 安全专家 Andrew Tulloch 拒绝扎克伯格 15 亿美元回聘邀请,选择加入 TML。

Murati 创办 TML 的思路,与她在 OpenAI 期间的思考一致。

推动 ChatGPT 面向公众开放时,她发现 AI 技术越强,越需要解决可靠性问题。

Murati 在一次采访中表示,当前 AI 的输出结果存在不可控性。

TML 的使命不是追求更强模型,而是填补 AI 能力与人类需求间的差距。

AI 随机性的核心成因:批次处理引发计算差异

9 月 11 日,TML 在研究博客 Connectionism 发布首篇文章,明确 AI 随机性的成因。

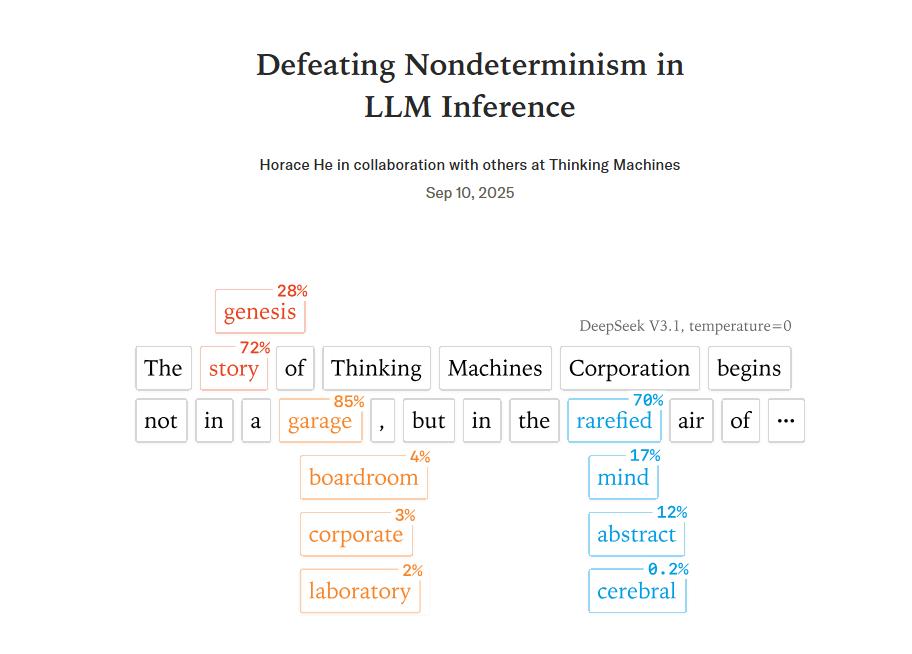

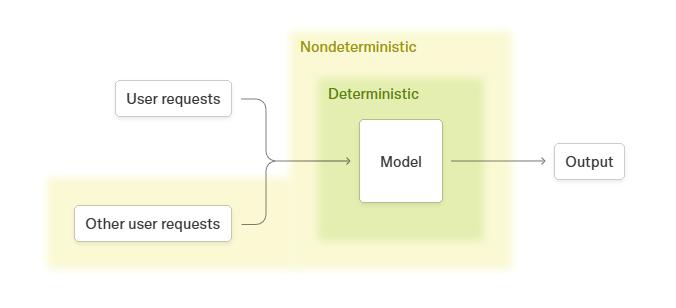

此前部分观点认为,AI 对同问题输出不同答案是因 “随机种子” 设置差异,但 TML 研究显示,核心原因是 “批次处理” 技术细节。

更为关键的发现是,并行计算策略的变化,才是导致输出不确定的根本原因。

简单来说,当服务器处理大家的 AI 请求时,会把不同用户的需求打成大小不一的 “包裹” 进行处理。

而不同的批量大小、序列长度,还有 KV 缓存状态,会影响 GPU 内核的选择策略,进而改变计算执行顺序。

再加上计算机算小数的时候,类似 (a+b)+c 和 a+(b+c) 这样的计算,结果可能会有细微差别。

这些小差别在 AI 的神经网络里会像滚雪球一样越积越大,最后就导致同一个问题,AI 给出的答案却不一样。

TML 的解决方案:批次不变内核实现结果稳定

为了攻克这个难题,TML 团队拿出了 “批次不变内核” 这个创新方案。

简单来说,这个方案规定,不管处理的数据量大小、怎么分组,AI 系统里的关键计算部分,都得按照同样的步骤算出一样的结果。

针对 AI 模型中特别重要的 RMSNorm、矩阵乘法、注意力机制这三个模块,团队也设计了专门的优化办法,就是为了让 AI 不管遇到多少数据,计算流程都能保持稳定。

光有方案还不够,团队用有 2350 亿参数的 Qwen3-235B-A22B-Instruct-2507 模型做了严格测试。

以前的 AI 系统,同样的问题每次算出来的答案都不太一样,测 1000 次能得到 80 种不同结果。

但用了 batch-invariant 方案后,只要输入的内容一样,AI 每次输出的答案就完全相同,这在大语言模型发展史上尚属首次。

刚开始,新方案让 AI 计算速度慢了将近一半,但经过优化后,现在这点性能损耗已经在可接受范围了。

这项技术突破对关键行业的实际价值尤为显著。

在医疗诊断场景下,AI 辅助系统若对同一患者的 CT 影像产生前后矛盾的分析结论,极易干扰临床医生的诊疗决策;

金融风控领域同样面临挑战,AI 模型对相同贷款申请的评估结果波动,不仅可能引发风险误判,更可能触及合规红线。

TML 研发的新技术,就像给高风险行业的 AI 上了一把 “安全锁”,让它们用起来更靠谱、更让人放心。

不同行业的突破点:让AI决策不再“玄学”

Murati 目前带领的团队研究方向,和大部分 AI 企业不太一样。

在其他公司都在努力扩大模型规模,思考如何让 AI 能生成更多东西的时候, TML 反其道行之,研究怎样才能让 AI 的表现更稳定,让大众能理解它是怎么 “思考” 的。

这其实和 Murati 在 OpenAI 的工作经历有关,

作为人工智能领域的从业者,她既了解大模型的强大之处,也明白技术失控的风险后果。

团队的研究博客取名 "Connectionism"(联结主义)颇有深意,这是 1980 年代研究神经网络与生物大脑相似性的 AI 子领域名称。

Murati 想通过这些基础研究,把 AI 的 “底细” 摸清楚,让大家不再觉得 AI 像个神秘莫测的 “黑匣子”。

目前,TML 还没有公布具体的商业化计划,但金融和医疗行业已经表现出浓厚兴趣。

让机器思维具备可预测性,虽不涉及 AI 能力边界的突破,但对 AI 技术安全融入社会至关重要。

Murati 表示,行业不需要 AI 输出不可控的结果,而是需要 AI 输出稳定可靠。