2020 年以来,OpenAI 提出的 Scaling Law 引领着大模型的快速发展 —— 模型参数和训练数据规模越大,产生的智能能力越强。然而进入 2025 年,训练开销不断扩增这一路径面临严峻的可持续发展问题。OpenAI 前首席科学家 Ilya Sutskever 在公开演讲中指出,随着互联网公开可获取的语料接近枯竭,大模型预训练将无法持续(“Pre-training as we know it will end”)。因此,大多研究者开始探索大模型的新的发展路径。

清华大学研究成果大模型“密度法则”(Densing Law) 给出了新的观察视角。近日,该成果正式发表于 Nature 子刊《自然·机器智能》(Nature Machine Intelligence),为理解大模型发展规律提供了新的维度。密度法则揭示了大语言模型的最大能力密度随时间呈指数级增长,2023 年 2 月至 2025 年 4 月,约每 3.5 个月翻一倍,这意味着每隔 3.5 个月,即可用一半参数量的模型实现当前最优性能。

论文链接:https://www.nature.com/articles/s42256-025-01137-0

受“摩尔定律”,启发的“密度法则”

回顾计算机发展史,在摩尔定律的指引下,半导体行业持续改进制造工艺、提升芯片电路密度,实现了计算设备从 27 吨的 ENIAC 到数百克的智能手机的跨越,最终带来算力普惠和信息革命。如今,全球拥有 13 亿台个人电脑、70 亿部智能手机、180 亿台 IoT 设备和 2000 亿颗正在运行的 CPU。摩尔定律的核心不是增大芯片尺寸,而是提升电路密度——单位面积容纳更多计算单元。

受此启发,研究团队提出:大模型发展同样可以从“能力密度”的角度来观察和理解。正如芯片行业通过提升电路密度实现了计算设备的小型化和普惠化,大模型也在通过提升能力密度实现高效化发展。

大模型密度法则:大模型能力密度,随时间呈指数上升趋势

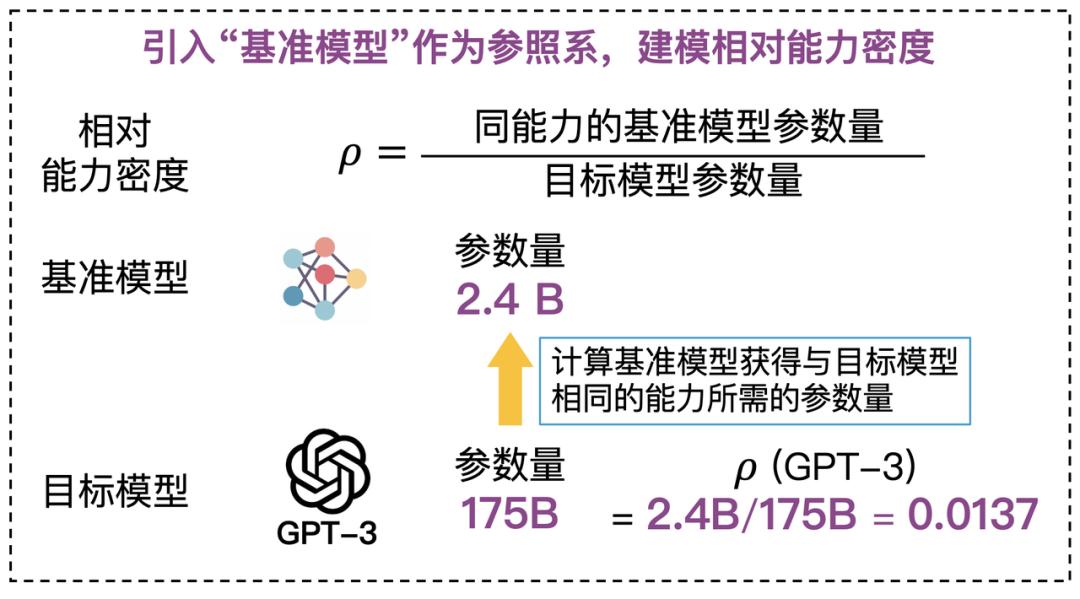

研究团队基于一个核心假设:采用相同制造工艺、充分训练的不同尺寸模型,其能力密度相同。在此基础上,研究团队选取基准模型并设定其密度为 1,作为衡量其他模型能力密度的基线。给定目标模型的能力密度被定义为:同能力的基准模型参数量与目标模型参数量的比值。

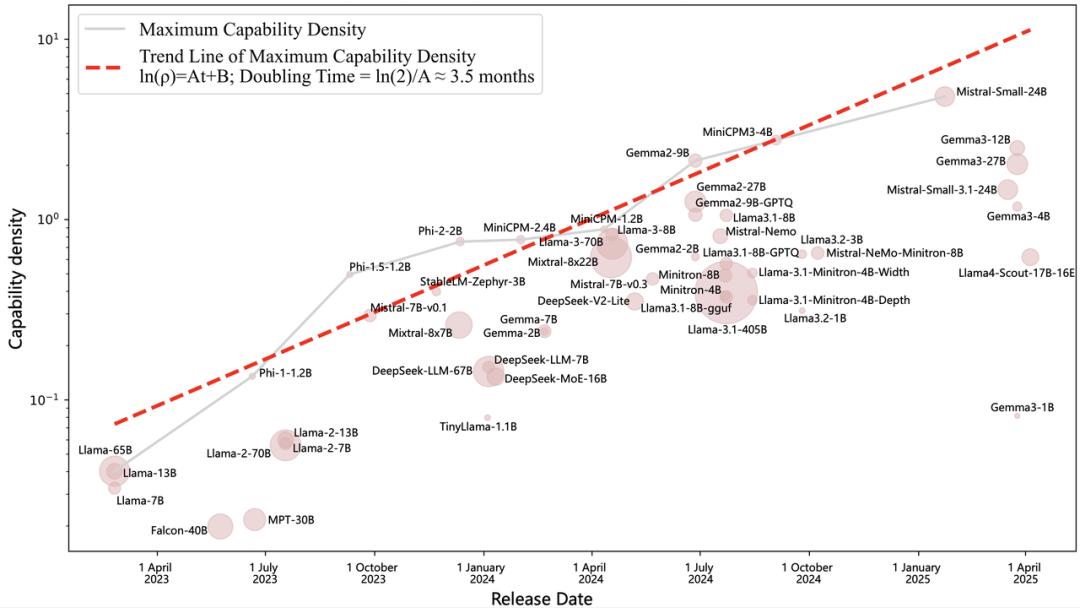

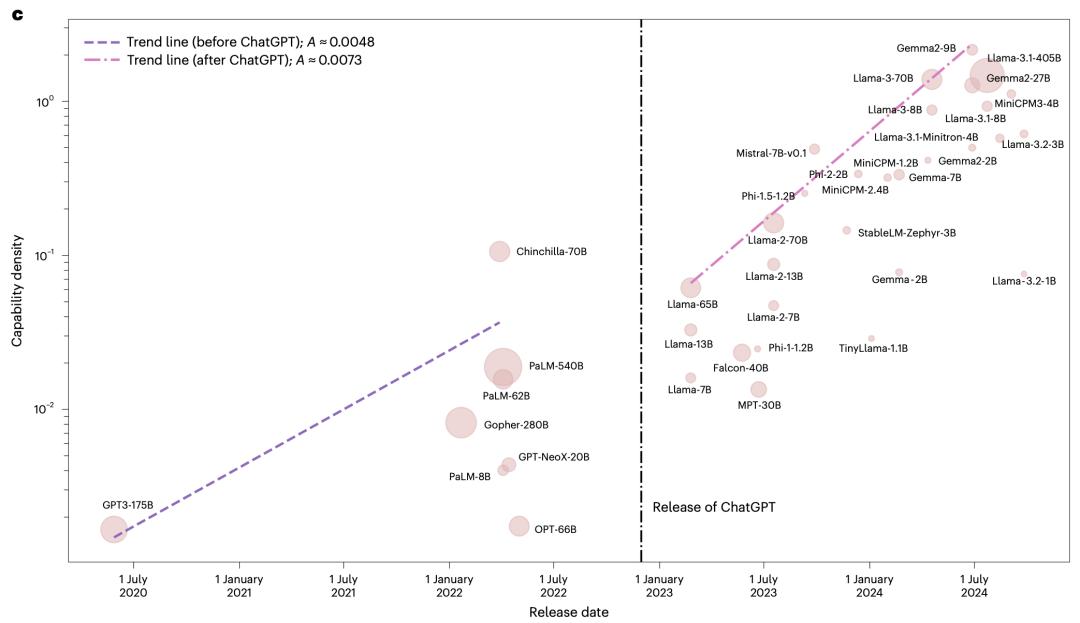

通过对 51 个近年来发布的开源大模型进行系统分析,研究团队发现了一个重要规律。大模型的最大能力密度随时间呈指数级增长,2023 年以来平均每 3.5 个月翻一倍。这意味着,随着「数据 - 算力 - 算法」的协同发展,可以用更少参数实现相同的智能水平。

根据密度定律,研究团队得出了若干重要推论。

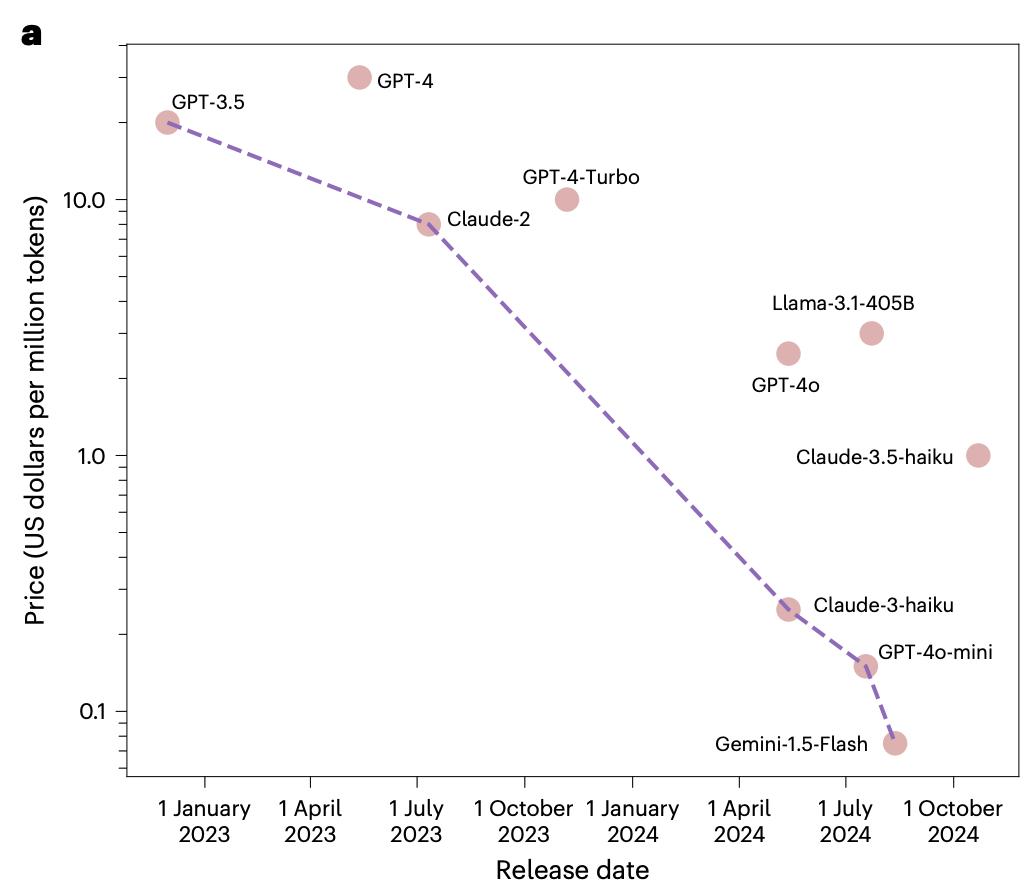

推论 1:同能力模型的推理开销随时间指数级下降

一方面,密度法则指出同能力的大模型参数每 3.5 个月减半。同时在推理系统优化方面,摩尔定律驱动芯片算力持续增强,而模型量化、投机采样、显存优化等算法技术也在不断突破,相同推理成本下,能够运行的模型大小不断提升。实证数据显示,GPT-3.5 级模型 API 价格在 20 个月内下降 266.7 倍,约每 2.5 个月下降一倍。

推论 2:大模型能力密度正在加速增强

以 MMLU 为评测基准的统计显示,ChatGPT 发布前能力密度每 4.8 个月翻倍,而 ChatGPT 发布后能力密度每 3.2 个月翻倍,密度增强速度提升了 50%。这表明,随着大模型技术的成熟和开源生态的繁荣,能力密度提升正在加速。

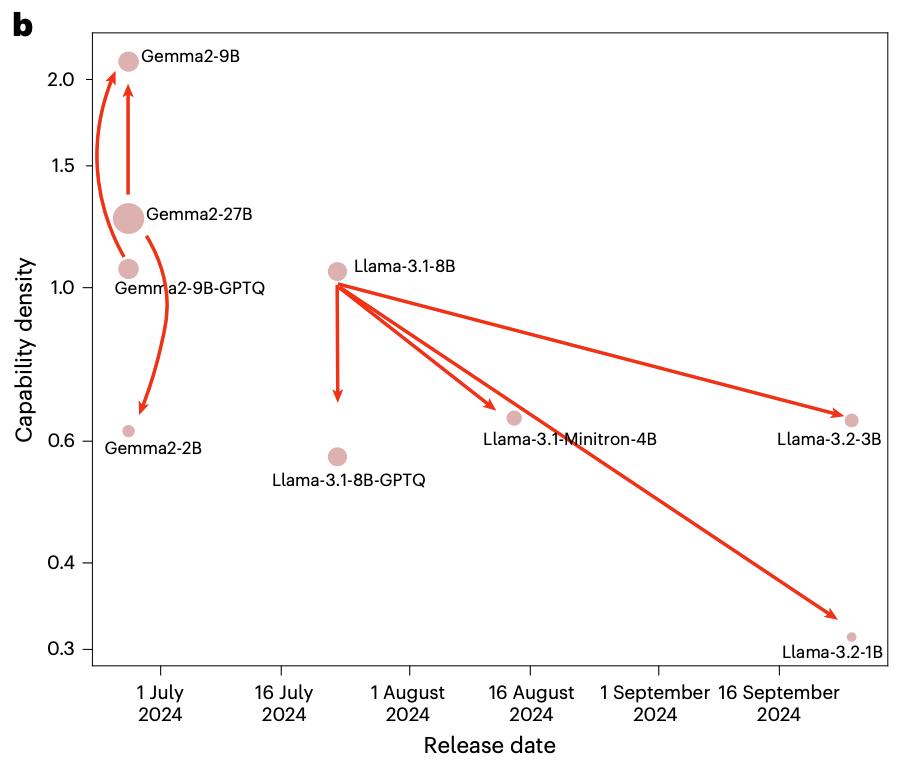

推论 3:模型压缩算法并不总能增强模型能力密度

研究团队对比了多个模型与其压缩版本的能力密度,发现除了 Gemma-2-9B 以外,如 Llama-3.2-3B/1B、Llama-3.1-minitron-4B 等其他压缩模型的密度都低于原始模型。量化技术同样会降低模型性能和能力密度。这一发现揭示了当前模型压缩技术的局限性:压缩过程中较小模型的训练往往不够充分,无法达到最优密度。

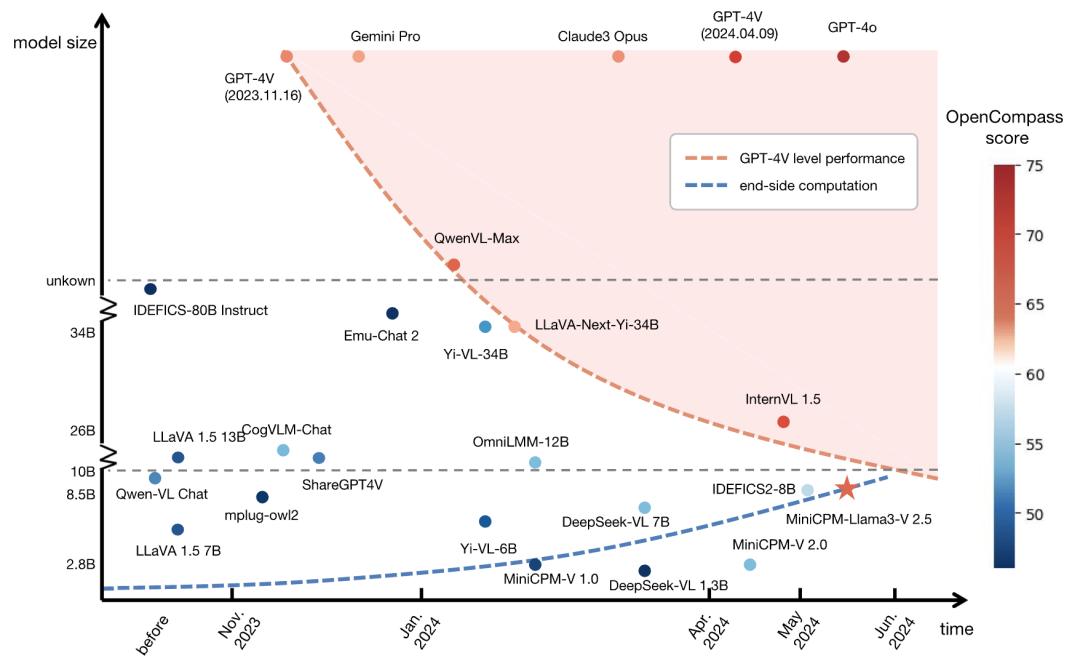

推论 4:模型小型化揭示端侧智能巨大潜力

芯片电路密度(摩尔定律)和模型能力密度(密度法则)两条曲线的交汇,意味着端侧设备将能够运行更高性能的大模型,边缘计算和终端智能将迎来爆发式增长,算力普惠将从云端走向终端。

基于密度法则的理论指导,清华大学、面壁智能团队持续推进高密度模型研发,发布了面壁小钢炮 MiniCPM、MiniCPM-V/o、VoxCPM 等一系列端侧高密度模型,凭借高效低成本的特性享誉全球,被评为 2024 年 Hugging Face 最多下载、最受欢迎的中国大模型。截至 2025 年 10 月,模型下载量接近 1500 万次,GitHub 星标接近 3 万次。