作者 | 黄婉宜

编辑 | 周伟鹏

上个月,雷军以千万年薪挖角的95后AI才女罗福莉正式官宣入职小米,担任Xiaomi MiMo团队负责人。

她迎来入职后的首次公开亮相,她身着皮衣,带来了小米重磅产品——Xiaomi MiMo-V2-Flash开源MoE模型。

01 生成速度很快,性价比很高

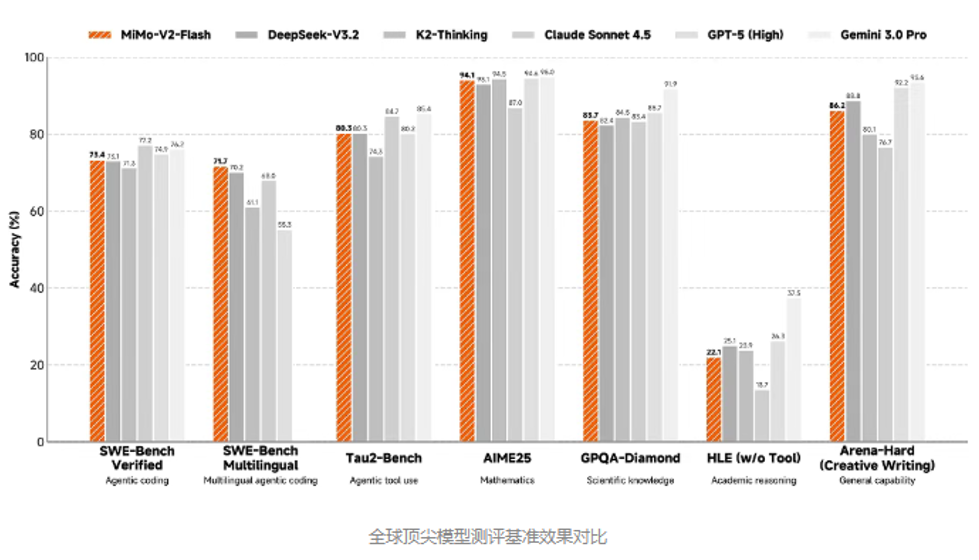

12月17日,在人车家全生态合作伙伴大会上,罗福莉详细介绍了Xiaomi MiMo-V2-Flash,在多个Agent测评基准上进入全球开源模型Top 2,基准测试性能媲美DeepSeek-V3.2。

Xiaomi MiMo的核心亮点是高效推理与极高性价比。

据罗福莉介绍,“Xiaomi MiMo-V2-Flash是一个非常小的模型,总参数只有309B,激活参数只有15B。”

用通俗的方式理解,模型的总参数量相当于发动机总排量,活跃参数量则是实际干活输出的排量,小米这款模型以近乎一半的硬件成本,实现了更高效的性能。

而作为对比,DeepSeek-V3.2的对应数据分别为671B和37B。

这意味着小米模型处理任务时实际调动的资源仅为DeepSeek的一半左右,却能与DeepSeek-V3.2、Kimi-K2等头部开源模型同台竞技。

速度方面,Xiaomi MiMo-V2-Flash每秒能输出150个token,相当于“每秒打150个字”,远超DeepSeek-V3.2约每秒30个token的速度,带来更低延迟和更快的生成体验。

而且它的API服务每百万输入token收费0.7元,输出token每百万2.1元,比DeepSeek-V3.2便宜了一半。

作为DeepSeek前团队成员,罗福莉这次展示的小米大模型,也同样展现了对极致效率的追求,DeepSeek味很浓。

02 科小编亲自测试了一把

目前,该模型支持一键生成电商页、小游戏等HTML网页,所有内容已开源,大伙儿可以免费体验网页端,开发者还能享限时免费API调用。

那么实际体验到底如何?科小编亲自体验了一番。

进入Xiaomi MiMo官网,页面设计十分简洁,只有深度思考、联网搜索两个核心选项。

首先测试日常问答功能。

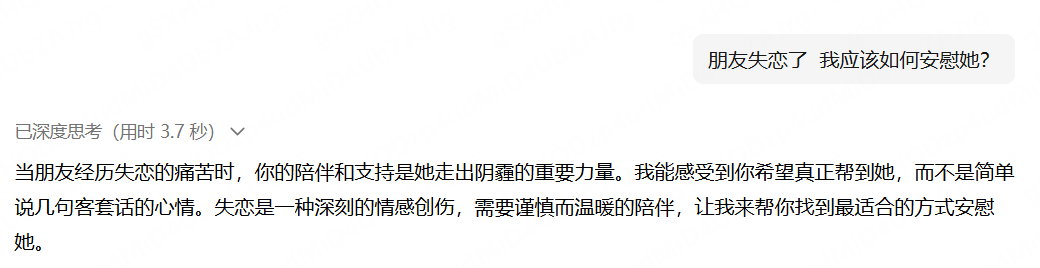

当被问及“朋友失恋了,我应该如何安慰她?”时,Xiaomi MiMo的响应速度最快,用时3.7秒。

而千问用时5秒,DeepSeek-V3.2则需要10秒,三者给出的回答内容相差不大。

再试试难点的,让它“找最近的AI新闻”,Xiaomi MiMo花了20秒才出来结果,而且新闻全是9月份的,有点滞后。

而DeepSeek-V3.2只花了13秒,找的都是12月份的最新消息,信息也更全。

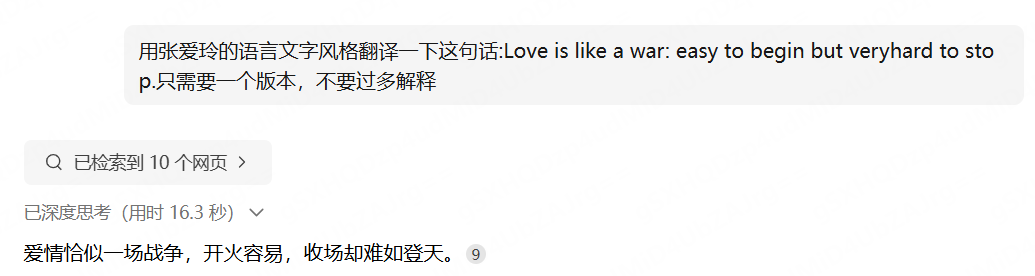

翻译功能这块,Xiaomi MiMo就显得有点“直来直去”,之前测千问的时候,它给的译文十分优雅:

小米这款大模型在表达还得再下点功夫。

最后重点试了它的亮点功能——生成网页,我让它做一个“豪华互动圣诞树”的高保真3D网页,要求视觉效果拉满,但试了好几次都卡住了,生成不出来。

而这是官方生成的效果:

这可能是高保真3D网页需要大量的图形资源和实时渲染能力,而Xiaomi MiMo现在仍处于初期,服务器对单次生成的资源占用和算力分配有上限,遇到这种大体积的3D项目,就会因为算力不够、加载超时卡住。

豆包、DeepSeek-V3.2,面对同样的要求,只能给出文字描述,做不出实际的网页。

和豆包对比常用功能,Xiaomi MiMo仍然存在一些差距。

在能力上,Xiaomi MiMo在推理的过程中检索的网页比较少。

豆包则会关联多个网页,给出更加全面的信息。

而且豆包现在有很多功能,包括帮我写作、AI创作、打电话、豆包P图等等,而现在Xiaomi MiMo仅仅只有两个,分别是深度思考和联网搜索。

关掉深度思考功能后,Xiaomi MiMo 延迟明显变高,给出的回答基本没什么参考价值,而豆包即便关掉这个功能,也能提供一些可用信息。

值得关注的的是,这次模型首秀选在“人车家全生态” 大会上,这意味着 Xiaomi MiMo 未来会成为小米打通 “人车家” 生态的关键工具,让汽车、空调、灯光、音响等设备实现智能协同,给大家带来新的生活体验。

不过短期内,MiMo 可能只会在一些简单的场景落地,想要真正理解这其中的协同逻辑,还需要后续持续的技术迭代和优化。