近两年来,关于 AI 经济学最引人注目的论战,实际上是一场关于“速度”的博弈。关于AI泡沫的讨论,最终都会还原到,「AI 多久会反映到 GDP/生产率上」这个问题上。

诺贝尔经济学奖得主 Daron Acemoglu 在 2024 年抛出了一盆冷水。他通过对当时 AI 能力(主要是 GPT-3.5 时代)的实证观察,计算出 AI 对未来十年全要素生产率(TFP)的增长贡献可能仅为微不足道的 0.07% 到 1%。他的判断主要立足于 AI 只能自动化很少一部分人类任务,且很难在短时间内大幅降低成本。

但在Agent全面接管工作流、推理模型层出不穷的当下,Acemoglu基于Chat时代的观察显得有点落伍了。

在他的论点之外,转折派、奇点飞升派等多个流派对AI、对GDP年增长的影响预测从0.07%到10%,分布在极其广阔的光谱上。

这些预期差距很大程度上源于他们对AI技术本身发展速度的理解差别。AI发展停滞、Agentic AI成功落地,以及能够自我迭代的AI进入研发流程,意味着完全不同的增长轨迹。

而斯坦福大学商学院经济学家 Charles I. Jones 在 2026 年 1 月发布的最新论文《人工智能与我们的经济未来》(A.I. and Our Economic Future),为这场争论引入了一个超越具体技术参数的宏观框架。Jones没有纠结于模型能力的范围,而是通过数学化的生产函数模型模拟了AI在不同场景下的可能。他认为,AI 确实拥有引爆经济的潜力,但这个引爆过程将被经济系统中的「薄弱环节」无情地拉长。

和过往的电气、互联网革命一样,这很可能也将是一个被驯服的奇点时代。

01 AI对经济影响的三种叙事

关于 AI 将在多大程度上提升长期 GDP 增长率,学术界目前分裂为三种截然不同的叙事。

分歧不仅源于对技术能力的判断不同,也源于他们看待经济机器运转方式的根本差异。

渐进主义视角:任务模型的摩擦 (Acemoglu)

Daron Acemoglu 是这一流派的代表。在 2024-2025 年的系列研究中,他主要通过霍尔顿定理(Hulten’s Theorem)作为依据进行论证。

霍尔顿定理的推导逻辑非常直接:AI 对总生产力的贡献,大约等于「受 AI 影响的 GDP 份额」X「这些任务的成本节约率」。根据Acemoglu的测算,即便假设 AI 能影响 20% 的任务并带来 25% 的成本降低,其在未来十年内对 TFP (全要素生产率)的累计提升仅为 0.71%,折合年均增长不到 0.1 个百分点 。

但是,Acemoglu的测算在方法论上存在根本性缺陷。他用了一个为衡量渐进式技术改进设计的工具,即霍尔顿定律,去预测一个可能改变经济结构本身的通用目的技术。如果1900年有人用霍尔顿定理计算电力影响,其结论可能是电力只能替代20%的蒸汽机任务,成本节约30%,影响有限。

但电带来的最核心改变是,工厂无需再围绕中央蒸汽机布局、因此其生产限度和范围都大幅扩展;而在微型化后,整个家用电器产业从零诞生。这些结构性变化不在替代旧技术的框架里。

然而,Acemoglu 确实敏锐的发现了一些很敏锐的现象。他注意到,当时AI的成果,比如写代码的速度提升55%,职场写作效率提高40%这类,都发生在他所谓的「易学任务」光谱里。这些任务有两个特点,依赖性,它们都有明确的对错标准;二来,互联网上有对此海量的训练数据。

但其实经济活动里大部分区域都没这么理想。比如一个医生诊断罕见病,一个律师在复杂案件中寻找突破口,一个建筑师在地形限制下设计方案,这些「难学任务」就没有明确的答案,而且必须根据语境做判断,而AI在这些领域的进步将极其缓慢。

而且因为缺乏客观的评判标准,AI只能从人类的平均表现中学习,这可能最终导致它们永远无法超越人类专家。

这一批评,在推理模型、RLVR,乃至Agent盛行的今天,甚至依然成立。

爆发论视角:自我进化的AI

在光谱的另一端,是耶鲁大学的William Nordhaus和研究机构Epoch AI代表了这一阵营。他们不只把AI看作Acemoglu眼中那种提效工具,而是看作一种全新的生产要素,一种可以无限复制的「数字劳动力」。

他们假设的基础是AGI确实会到来。在这一假设之下,AI能在几乎所有认知任务上替代人类,那么传统经济模型中「劳动力受人口增长限制」这一铁律就会被打破。经济增长将不再被人口瓶颈所束缚,而只取决于我们能以多快的速度生产算力。

这一派别采用了内生增长模型

,他们认为传统索洛模型中「劳动」和「资本」互补的假设将失效。如果 AI 技术发展到足以在绝大多数认知任务中完全替代人类,经济增长将仅受限于资本(算力)的积累,而不再受制于人口增长的停滞,长期增长率显著上移。

他们预测,如果AI能够自动化科研过程(设计更好的芯片、发现新材料、优化算法),就会形成一个正反馈循环,更强的AI →更好的硬件/算法 → 更强的AI。根据 Epoch AI 的预测,如果这一循环打通,全球GDP的年增长率可能在2030年代突破10%,甚至达到30%的爆发性水平。

融合视角:J型曲线与索洛悖论的再现

然而,目前的实证数据似乎更支持Erik Brynjolfsson 提出的「生产力 J 型曲线」解释。

该理论认为,通用目的技术(比如GPT)在引入初期,往往会导致生产力增长放缓甚至下降。这是因为企业需要进行大量的无形资产投资,这包括去重组业务流程、重新培训员工、开发配套软件。

这些投入在短期内被计为巨额成本,而收益却滞后显现。

2025年的调查数据也佐证了他的想法。尽管 GenAI 的个人使用率已极高,但许多企业正处于试点炼狱(Pilot Purgatory)之中,投了很多钱,但没看到什么规模化回报。

这种现象完美复刻了罗伯特·索洛在 1987 年的名言:“到处都能看到电脑,除了在生产力统计数据里” 。

缓慢的爆炸,被驯服的奇点

Charles Jones的新论文,其实站在了一个统合者的角色上,去看待上面提到的所有三种路径。

他既不否认AI拥有无限自我进化的革命性潜力,也不否认组织变革之类拖后腿的因素。他把这些因素都塞进了一个理论中去融合,即「薄弱环节」理论,或者说是经济发展中的木桶效应。

现实经济中,绝大多数任务是互补的,是一个由无数相互依赖的环节组成的复杂系统。比如药物研发,就包含靶点验证、毒理、临床试验、监管批准,任何一环都无法用其他部分替代。工程交付,则包含设计、供应链、施工、验收、许可,某一步过不了整体交付不了。

现代社会之所以有如此多的分工,正是因为为了保证安全和质量、完成一件足够复杂的工作,是需要很多不可替代的环节的。

而在这样一个系统中,最慢的环节决定了整体的速度,Jones就把它称为「薄弱环节」。

在论文里,Jones自己用了一个比喻去解释这套理论。

准备一顿晚餐的过程由两个步骤组成:想菜谱和做菜。现在AI来了,它超好用,能在瞬间生成一份完美的菜谱,考虑到营养搭配、时令食材、你的饮食偏好。因此在「想菜谱」这个环节,生产力直接可能飙升一万倍。

但真想让它上桌,厨师仍然需要花一个小时切菜、炒菜、摆盘。AI让你在菜谱上省了十分钟,但整个流程的瓶颈,即实际的烹饪过程并没有改变。

结果是,就算AI无敌了,你也只是把做饭时间从70分钟缩短到了60分钟,提升有,但似乎谈不上「革命」这么夸张。

当生产环节之间是高度互补时,总产出并不取决于那个最强的环节(AI),而是被锁死在那个最弱的环节(人类/物理世界)上 。只要这个薄弱环节存在,就算自动化再完善,最终总产出都由最弱环节的完成时间、成本所限制。

而在可见的未来中,这个薄弱环节都会存在。

首先是AI自身能力还需要提升,目前它缺乏长程任务的处理能力,也缺乏创新能力,更缺乏进入物理世界的具身能力。

就算这些技术卡点都解除了,算力、机房、电力也需要现实时间去搭建;组织本身的变革肯定要慢于技术的进展,薄弱环节就会移动至此。而当组织,可能都被AI重新划定好后,那些涉及伦理、信任、最终决策权、以及人类纯粹偏好的「不可替代环节」,又将成为扼住经济咽喉的那个「绝对薄弱环节」。

这些过程,即使Epoch AI预测的超进化发生,也无法被磨平。至少在人类同意将一切决策权交由AI之前,都不可能发生。

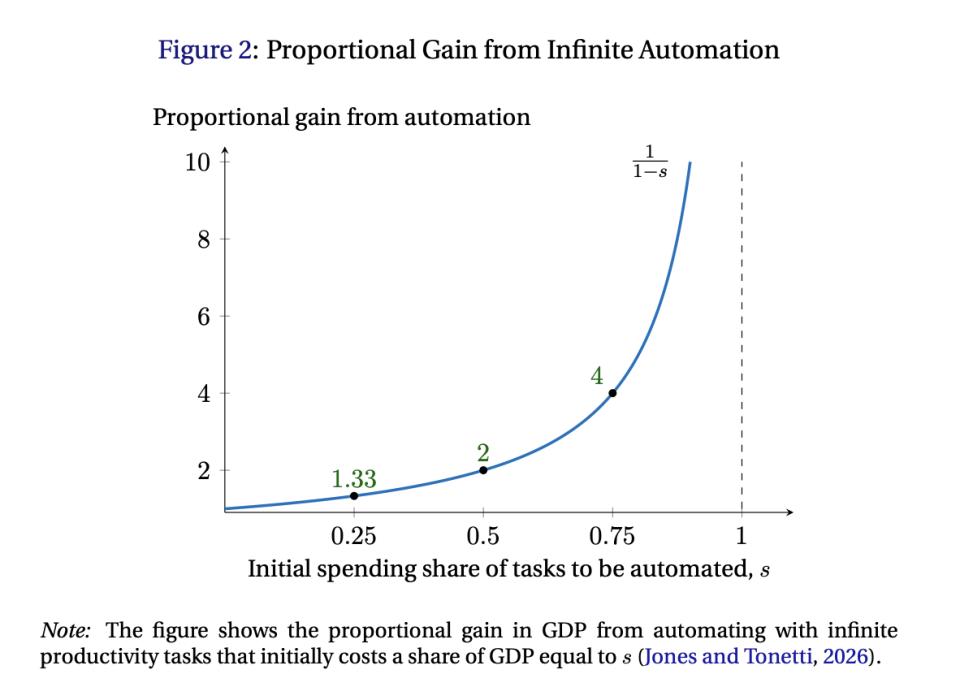

卡到什么程度呢?Jones给出了另一个公式。在一个替代弹性为一半,也就是说各项任务都相互依赖的世界里,如果你把一类任务自动化到「无限供给」,而这类任务在原本经济中占 GDP 的成本份额为 s,那么总产出的比例增益大约是:

增益=1 / 1-s

这个公式可以这么理解,把某类任务压到几乎免费,带来的最大效果,本质上就是把生产 1 单位最终产出的总成本里,那一块原本属于它的成本拿掉。

如果它原来占总成本的份额是 s,那剩下的其它必要任务就占 1−s。在这个强互补设定里,其它任务那部分成本是你无论如何都躲不开的。

在同样资源/同样预算下,你能买到的最终产出与单位成本成反比。单位成本从 100% 降到 1−s,产出能力就最多放大到原来的 1/(1−s)。

而GDP占比可以看成衡量一种经济部门在总价值与总支付中的权重,也可以近似视作成本。

比如,软件开发行业大约占美国GDP的2%。假设AI现在可以写出所有的代码,让软件开发的生产率达到无穷大。即便如此,这项突破会让GDP变成1 / (1-0.02),也就是大概102%,也就是带来约2%的增加。

听起来很扯,但这确实是事实。因为拆解开来,美国的GDP大头,基本上都完全无法用编程替代,都涉及到物理劳动、土地等「绝对薄弱环节」。

因此,在这个任务无法互相替代的框架中,经济在微观上,很多环节效率暴涨(写代码、写文案、做分析、做客服……);但宏观上产出提升依然被少数硬环节卡住(许可、责任签字、物理建设周期、供应链、信任与安全、数据生成等)。

结果就是,增长不是瞬间起飞,而是拆一个瓶颈、瓶颈迁移到下一个,呈现缓慢加速。

而且,A.I. 把某些任务变便宜后,支出份额 s 未必上升,甚至可能下降。GDP可能会更集中在卡脖子的环节之上。

基于这个框架,Jones重新计算了AI的经济影响。他的结论介于Acemoglu的极度悲观和奇点论者的极度乐观之间。

AI确实会驱动经济增长加速,年增长率最终可能突破5%的历史高位。但这不会是一夜之间的飞跃,而是一个跨越三四十年的渐进过程。在头十年,我们可能只会看到约0.5-1%的累计TFP增长,勉强高于Acemoglu的预测。

换句话说,奇点依然存在,但它被经济结构的韧性驯服了。爆炸会发生,但引线很长。

03 加速的可能

如果说 Acemoglu 的理论是基于静态的观察,那么 Jones 的理论则更好的描绘了系统的结构性阻力。他是一种极限实验,在其中假设把某类任务做到近乎无限便宜/无限供给,问总产出最多能被抬高多少。本质上是一个偏结构约束的视角。

这种结构约束就是任务间的不可替代性。

但这会是一成不变的吗?Jones 在论文中暗示,技术确实会重构经济形式。也就是说,在上面公式中,任务间无法互相替代这件事儿,可能会因技术的变化而变化。

那么现实的发展速度就有可能比他的基础预测更快。

根据不同技术情景对任务替代的不同影响,他一共设想了三种可能的重构方式。

第一个是改变生产函数本身。

当一项新技术足够强大时,我们往往会重新设计整个流程,用新的范式替代旧的瓶颈。

比如当下一些行业的分工,像法律里,有起草合同、审核文件、法庭辩护这些环节高度互补,缺一不可。但如果AI不仅能起草合同,还能直接与另一个AI代理基于智能合约达成协议,中间的许多人工审核环节就可能被彻底绕过。

这不是在原有流程上做优化,而是创造一个全新的、更少瓶颈的流程。一些原先的硬串行链条被改造成可以多开工、多条线并跑的结构。

这种范式转换会改变不可替代性的大小。如果经济活动重组后,任务之间从强互补变为弱互补甚至可替代,那么单纯堆叠算力就能带来指数级的产出增长。

于是宏观增长会更明显加速,但仍可能受到物理与制度约束,不一定立刻指数爆炸。依然是一个随着组织和渗透渐进的过程,但速度会大为增加。

理论上讲,这一改变是非常可能的,因为我们现在的劳动分工和流程化,在很大程度上都是为了人类本身的限制而设立的。如果对于一个能力高超的AI来讲,设计一栋复杂建筑的难度和原始人设计木屋的难度一样,它完全可以边设计边建造,而无须拆分流程。

第二种改变方法,是份额的内生增长。公式 1/(1-s)假设可自动化任务的份额s是固定的。

但历史告诉我们,当某种投入变得极其便宜时,我们会在所有可能的地方使用它。

比如在电力刚出现时,它只是用来照明和驱动少数机器。但随着电价下降,电力渗透到了经济的每一个角落:制冷、通讯、交通、娱乐、医疗。

类似地,如果AI推理的成本降到接近零,我们会在今天想都不敢想的地方嵌入智能,比如建筑材料会自己监测结构安全,农作物会实时优化光合作用效率,甚至一片树叶都可能成为一个微型计算节点。

在这个环境下,企业开始加强AI的渗透,替代一部分原来必须由人/组织协调完成的任务,在一定程度上取消某些环节。总体看,AI的用量扩张和任务边界扩张(把原本不属于AI的任务重新划给AI)会减少在各个层级上的「薄弱环节」,把它们同样自动化。

因此 s 并不是仅仅限制在「编程」本身的GDP占比上,而是渗透性更强,幅度更大。对GDP增长的影响也更显著。

这基本上是目前完全可见的一种潜在未来场景。这种扩张不会在一夜之间发生,但也不会像Jones的基准预测那样缓慢。

第三个则是直接通过解决「基础薄弱环节」,带来跨越式增长。

其实在Jones公式里,最大的「薄弱环节」并非算法,而是能源、材料、人力这些物理障碍。AI科学家不能直接建造核聚变反应堆,不能亲手合成新材料,也不能独自组装iPhone。

但这恰恰是AI可能产生最大杠杆效应的地方。Jones在论文中描绘了一个很接近Epoch AI提出「飞轮」场景:AI 科学家可以设计更好的机器人,机器人进行实验产生数据,实验数据则用来训练更强的 AI。

在这个过程中,一旦在AI的自我进化式研究的过程中,解决了核聚变(无限能源)和通用人形机器人(无限物理劳力)的问题,那么原本占比最大「薄弱环节」和瓶颈都会消失,进入到自动化循环中。

这就会是真正的经济奇点到来的前夜。而在当下,进化性模型正是最火热的前沿领域,AlphaEvolve带来的曙光初现。这个场景变得越来越可能。

在这三种Scenario之下,我们可以看到相对于Epoch AI和Acemoglu,Charles I. Jones 的研究框架完全可以包容前三者的所有假设。

在当下高度互补的经济系统中,AI 的局部无限能力会被那些尚未被自动化的「硬骨头」(如物理瓶颈、法律伦理、人类情感)所稀释。这就是为什么即便技术在飞速迭代,宏观经济变化却相对缓慢,因为价值会迅速从智能环节逃逸,被死死锁在那些依然昂贵且稀缺的短板上。

而随着AI的持续发展渗透,打补丁式的替代将转向彻底的重构。自动化份额逐步扩大,很多生产流程将完成从人机互补到端到端的完全替代。

更远处,利用「AI 科学家+机器人」的飞轮攻克能源与制造等物理底座,则会撬动几乎所有「薄弱环节」。

一旦我们成功拧动这些关键的「生产环节替代性」的调节旋钮,一步步消除系统中拥有一票否决权的短板,经济增长便能突破引力束缚,从线性的摩擦走向真正的指数级跃升。

当然,这些旋钮中,可能最先被拧动,是你我这样的人。

04 人的新位置

那么,在这样一个由「薄弱环节」定义的未来里,人类的位置在哪里?

从这个图景看,答案其实很简单,即人会不断向瓶颈处迁移。

在过去,掌握大量知识是高薪的保障。但在 AI 时代,这些成为了最先被无限化的廉价资源。人类的技能必须向那些 AI 尚未攻克的薄弱环节转移。

而当下尚能看到的瓶颈在哪里?

首先是物理世界的最后且最难的一公里。尤其是那些非标准化的、需要灵巧操作和复杂判断的物理工作。照顾老人、修缮古建筑、紧急情况下的复杂救援。

在这些场景中,只要机器人还没有达到人类的灵巧度,工作的薪资反而会因为「薄弱环节」理论而水涨船高。这在现实中其实完全有映照。最近,在美国修筑算力中心的蓝领工人工资就在大幅提升。

其次,是监管与信任的能力。 在一个充满了 AI 生成内容的世界里,验证变得比生成昂贵得多。法律责任的界定、伦理的审查、人际间的信任背书,这些是 AI 难以通过算力解决的硬骨头。这些问题基本没有技术解决方案,只有社会和制度的解决方案。律师、审计师、伦理顾问的工作重心会从做转向验证和担保。

最终,是定义意义的能力。 当 AI 能解决所有如何做(How)的问题时,价值就集中到了做什么(What)和为什么做(Why)上。能够发现需要AI 解决的问题;能够制定一个城市的规划愿景、一个社会的价值排序;能够定义人类应该有的生活,确认出可能不适合所有人,但适合一部分人的意义;这些工作,是缺乏生命史和生物本能的AI本身永远也无法去取代的。

直到我们达到「后丰裕时代」,把相当丰富的决定权都交予的AI的图景。

Jones 在论文的结尾没有谈论大规模失业的恐慌,而是谈到了「退休」和「夏令营」。

在传统的经济模型中,人类文明的绝大部分时间,都活在不工作就会死的重压之下。

即使在现代社会,这个恐惧只是被包装得更精致:不工作就付不起房租,看不起病,养不起孩子,失去社会身份和尊严。我们把它叫做"职业发展"、"自我实现"、"社会贡献",但底层逻辑从未改变,工作是生存的代价。

这种恐惧塑造了人类文明的几乎所有结构。教育系统,本质上是劳动力培训营,从幼儿园开始就在为将来有用做准备;时间分配,清醒时间的一半以上用于生产劳动或为生产做准备。身份认同,你是做什么的?成为认识一个人的第一个问题 。

更深层的是,生存恐惧塑造了我们对人性本身的理解。我们把理性定义为效用最大化,把成功定义为资源积累,把价值定义为市场定价。人被简化为经济人、生产要素、人力资本。

而当后丰裕时代来临时,人类会退守到哪里?

标准答案通常是,AI无法替代的高级工作,创造力、同理心、领导力。但这仍然是生存恐惧的框架,仍然在问「我能提供什么有用的东西」。

真正的新高地,可能根本不在有用的维度上。

这听起来像是一个乌托邦式的幻想,但它符合「薄弱环节」理论的最终推演:当所有的生存需求都变成「容易环节」被解决后,人类唯一剩下的「薄弱环节」,就是如何定义我们存在的意义,以及如何度过这漫长而由自己主宰的一生。

这场由 AI 引发的经济变革,或许不会像原子弹爆炸那样瞬间摧毁旧世界,而更像是一场持续数十年的气候变迁。水位会慢慢上涨,旧的大陆(传统认知工作)会慢慢淹没。

在这之前,我们都将不得不搬迁到新的高地,那些 AI 无法触及的、属于人类本质的薄弱环节之上。

回归生存恐惧之外的人性。那不是人类的终点,而是人类的起点。