芯东西1月27日报道,今日,微软宣布推出自研AI推理芯片Maia 200,并称该芯片是“目前所有超大规模数据中心中性能最高的自研芯片”,旨在显著提升AI token生成的经济效益。

Maia 200采用台积电3nm工艺制造,拥有超过1400亿颗晶体管,配备原生FP8/FP4张量核心,重新设计的内存子系统包含216GB HBM3e(读写速度高达7TB/s)和272MB片上SRAM,以及能确保海量模型快速高效运行的数据传输引擎。

Maia 200专为使用低精度计算的最新模型而设计,每块芯片在FP4精度下可提供超过10PFLOPS的性能,在FP8精度下可提供超过5PFLOPS的性能,所有这些都控制在750W的SoC TDP范围内。

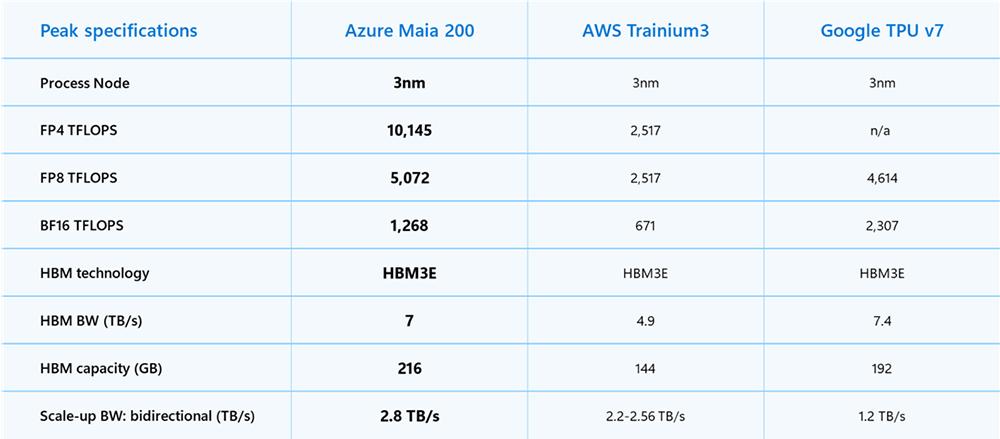

其FP4性能是亚马逊自研AI芯片AWS Trainium3的3倍多,FP8性能超过了谷歌TPU v7。

▲Azure Maia 200、AWS Trainium3、谷歌TPU v7的峰值规格对比

Maia 200重新设计的内存子系统以窄精度数据类型、专用DMA引擎、片上SRAM和用于高带宽数据传输的专用片上网络(NoC)架构为核心,从而提高token吞吐量。

互连方面,Maia 200提供2.8TB/s双向专用扩展带宽,高于AWS Trainium3的2.56TB/s和谷歌TPU v7的1.2TB/s。

Maia 200也是微软迄今为止部署的最高效推理系统,每美元性能比微软目前部署的最新一代硬件提升了30%。

01.

能运行当前最大模型,

将支持GPT-5.2

根据微软博客文章,Maia 200可轻松运行当今最大的模型,并为未来更大的模型预留了充足的性能空间。

作为微软异构AI基础设施的一部分,Maia 200将支持多种模型,包括OpenAI最新的GPT-5.2模型,从而为Microsoft Foundry和Microsoft 365 Copilot带来更高的性价比。

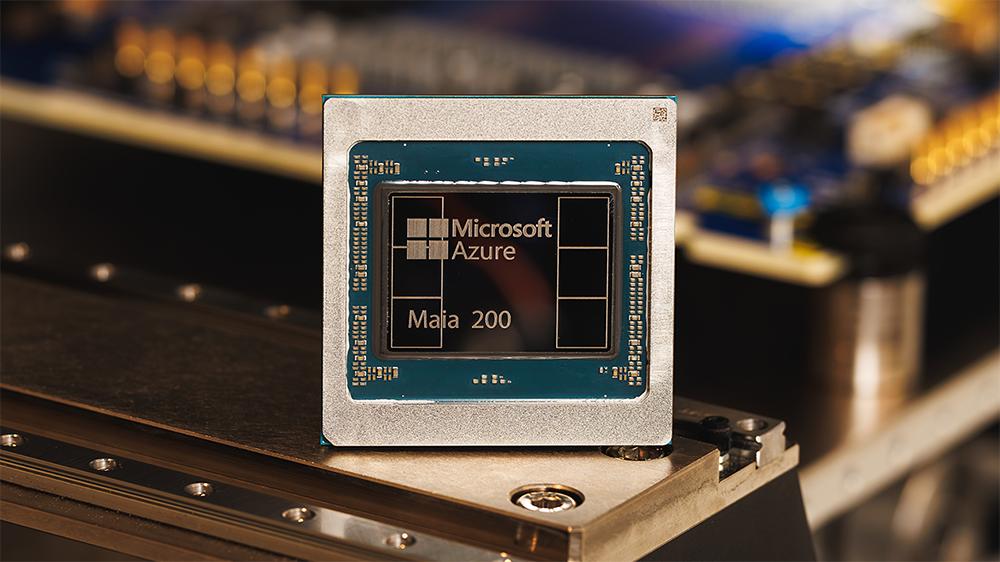

▲Maia 200芯片

Maia 200与微软Azure无缝集成。微软正在预览Maia软件开发工具包(SDK),其中包含一套完整的工具,用于构建和优化Maia 200模型。

它包含全套功能,包括PyTorch集成、Triton编译器和优化的内核库,以及对Maia底层编程语言的访问。这使开发者能够在需要时进行细粒度控制,同时实现跨异构硬件加速器的轻松模型移植。

微软超级智能团队将利用Maia 200进行合成数据生成和强化学习,以改进下一代内部模型。

在合成数据管道用例方面,Maia 200的独特设计有助于加快高质量、特定领域数据的生成和筛选速度,为下游训练提供更新、更具针对性的信号。

Maia 200已部署在微软位于爱荷华州得梅因附近的美国中部数据中心区域,接下来将部署位于亚利桑那州凤凰城附近的美国西部3数据中心区域,未来还将部署更多区域。

02.

支持2.8TB/s双向带宽、

6144块芯片互连

在系统层面,Maia 200引入了一种基于标准以太网的新型双层可扩展网络设计。定制的传输层和紧密集成的网卡无需依赖专有架构,即可实现卓越的性能、强大的可靠性和显著的成本优势。

每块芯片提供2.8TB/s双向专用扩展带宽,以及在多达6144块芯片的集群上公开可预测的高性能集体操作。

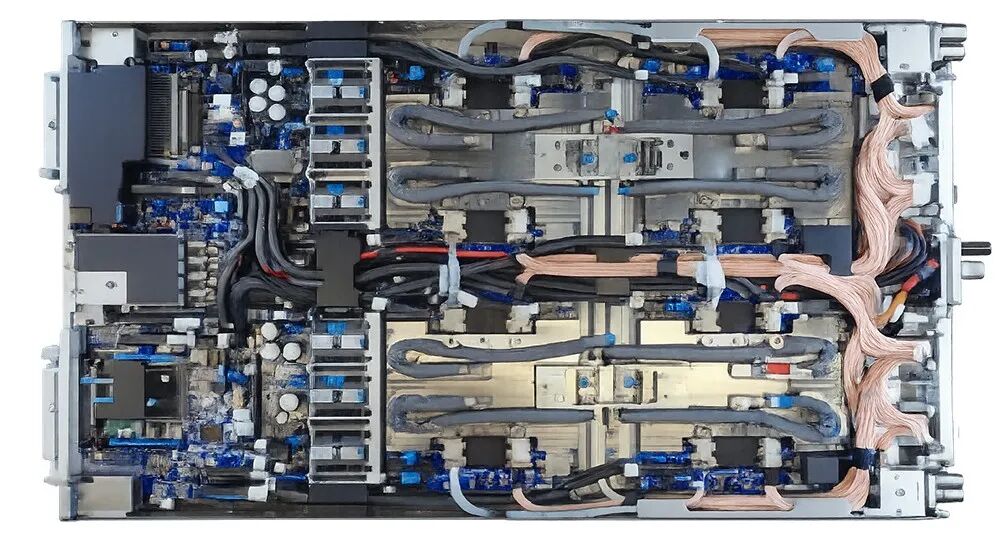

▲Maia 200刀片服务器的俯视图

每个托架内,4块Maia芯片通过直接的非交换链路完全连接,实现高带宽的本地通信,以获得最佳推理效率。

机架内和机架间联网均采用相同的通信协议,即Maia AI传输协议,能够以最小的网络跳数实现跨节点、机架和加速器集群的无缝扩展。

这种统一的架构简化了编程,提高了工作负载的灵活性,并减少了闲置容量,同时在云规模下保持了一致的性能和成本效益。

该架构可为密集推理集群提供可扩展的性能,同时降低Azure全球集群的功耗和总拥有成本。

03.

将芯片部署时间缩短一半,

提升每美元和每瓦性能

Maia 200芯片首批封装件到货后数日内,AI模型就能在其上运行,从首批芯片到首个数据中心机架部署的时间可缩短至同类AI基础设施项目的一半以上。

这种从芯片到软件再到数据中心的端到端解决方案,直接转化为更高的资源利用率、更快的生产交付速度,以及在云规模下持续提升的每美元和每瓦性能。

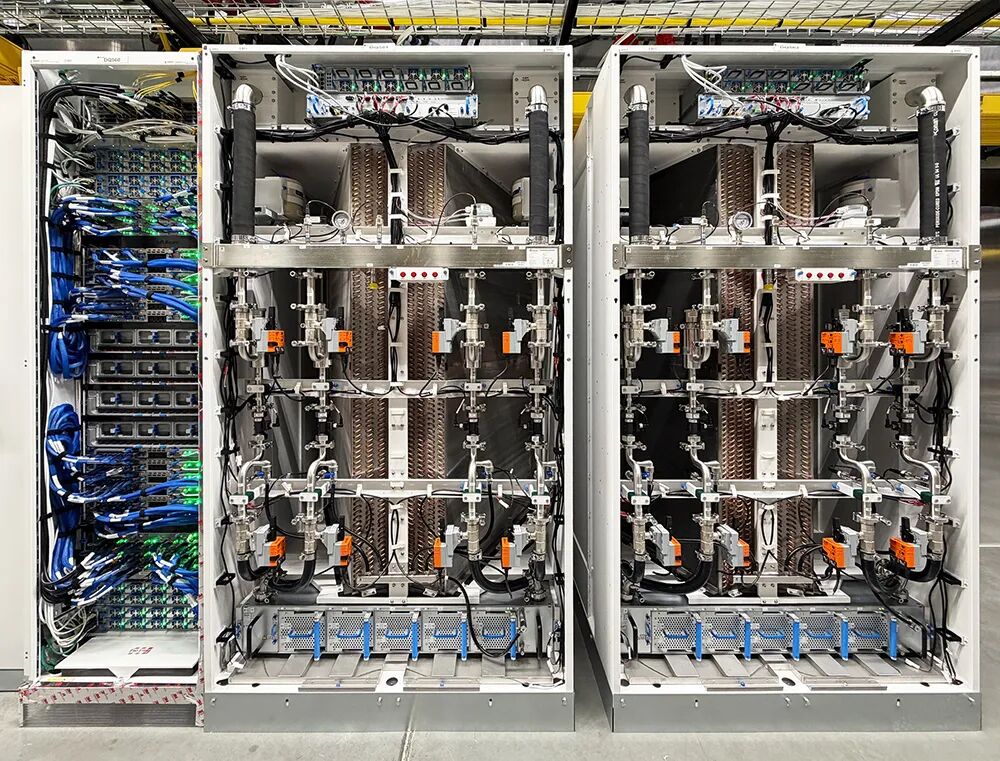

▲Maia 200机架和HXU冷却单元的视图

这归因于,微软芯片开发计划的核心原则是在最终芯片上市之前,尽可能多地验证端到端系统。

从架构的早期阶段开始,一套精密的芯片前开发环境就指导着Maia 200的开发,它能够高保真地模拟大语言模型的计算和通信模式。

这种早期协同开发环境使微软能够在首块芯片问世之前,将芯片、网络和系统软件作为一个整体进行优化。

微软从设计之初就将Maia 200定位为数据中心内快速、无缝的可用性解决方案,并对包括后端网络和第二代闭环液冷热交换器单元在内的一些最复杂的系统组件进行了早期验证。

与Azure控制平面的原生集成,可在芯片和机架级别提供安全、遥测、诊断和管理功能,从而最大限度地提高生产关键型AI工作负载的可靠性和正常运行时间。

04.

结语:在全球基础设施部署,

为未来几代AI系统托举

大规模AI时代才刚刚开始,基础设施将决定其发展的可能性。

随着微软在全球基础设施中部署Maia 200,微软已在为未来几代AI系统进行设计,并期望每一代系统都能不断树立新的标杆,为重要的AI工作负载带来更出色的性能和效率。

微软诚邀开发者、AI创企和学术界人士使用全新Maia 200 SDK开始探索早期模型和工作负载优化。

该SDK包含Triton编译器、PyTorch支持、NPL底层编程以及Maia模拟器和成本计算器,可在代码生命周期的早期阶段优化效率。