光子技术(Photonics)在数据中心加速 AI 方面发挥着越来越重要的作用。

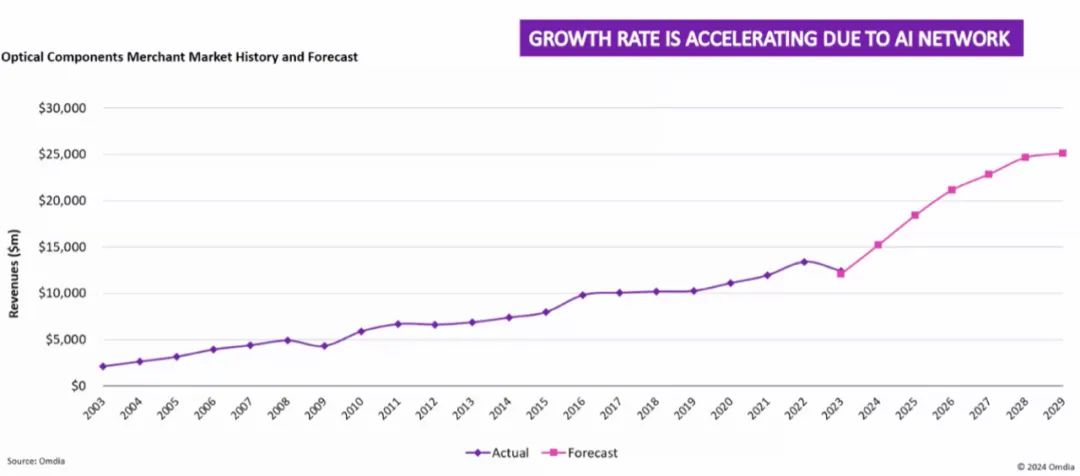

数据显示,全球光学元件市场去年规模达到 170 亿美元。从市场历史来看,电信行业(如海底电缆和光纤到户)主导着市场的核心需求。然而,随着AI驱动的数据中心快速发展,数据通信领域正在后来居上,市场份额甚至占据了60%以上。

这种市场需求的转变也驱动着光学技术快速发展。为了跟上AI集群不断提升的集群规模和性能,光传输速率正在迅速提高,并且深刻影响着数据中心未来网络发展。

图一:光学元件市场历史和预测。

摩根大通市场数据显示,当前光学元件市场最大的供应商是 Coherent 和 Innolight(各占 20% 的市场份额),Broadcom紧随其后,市场份额约为10%,还有很多份额较小的供应商参与市场竞争,众多供应商也造就了光学生态系统当下的繁荣。

大模型驱动数据中心网络高速增长

大型语言模型 (LLM) 正在推动 AI 工作负载呈指数级增长。

随着大模型能力的进步,以及越来越多人开始使用生成式AI,大模型的持续训练、智能体带来的海量推理需求,都要高性能的AI集群做支撑,并且数据处理需求也日益增长,还需要大量的内存和存储资源。

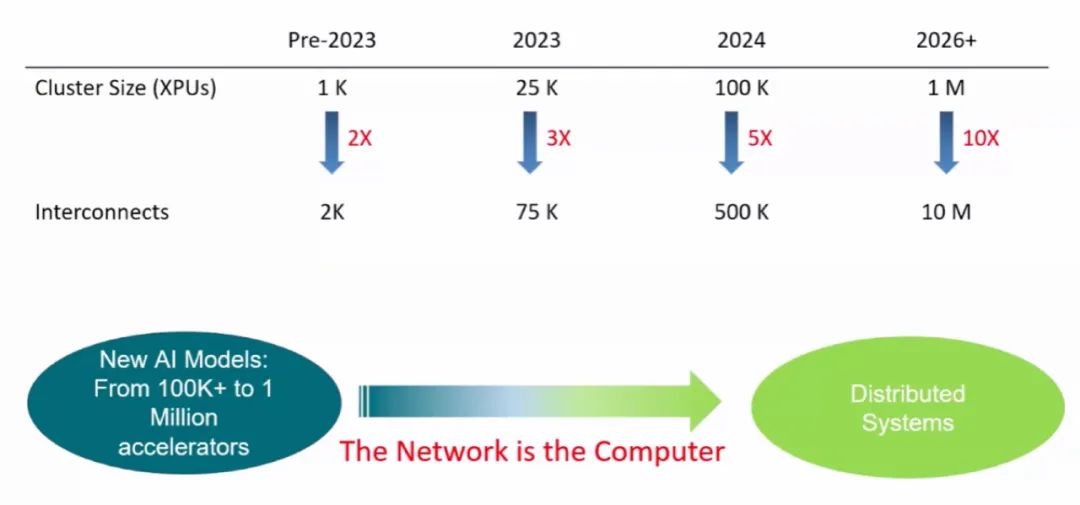

因此,保持高效的数据传输和资源分配是满足AI应用的关键,这也需要众多GPU之间协同工作,GPU之间的互联网络比传统网络提出了更高的要求。如今,互联需求的增长速度超过了 XPU 本身的数量,迫切需要高带宽、低延迟的网络解决方案。

Broadcom公司就认为,数据中心的网络成本正在攀升,从目前资本支出的 5% 到 10%,预计到 2030 年将达到 15% 到 20%。

图二:AI集群规模呈现爆炸性增长趋势

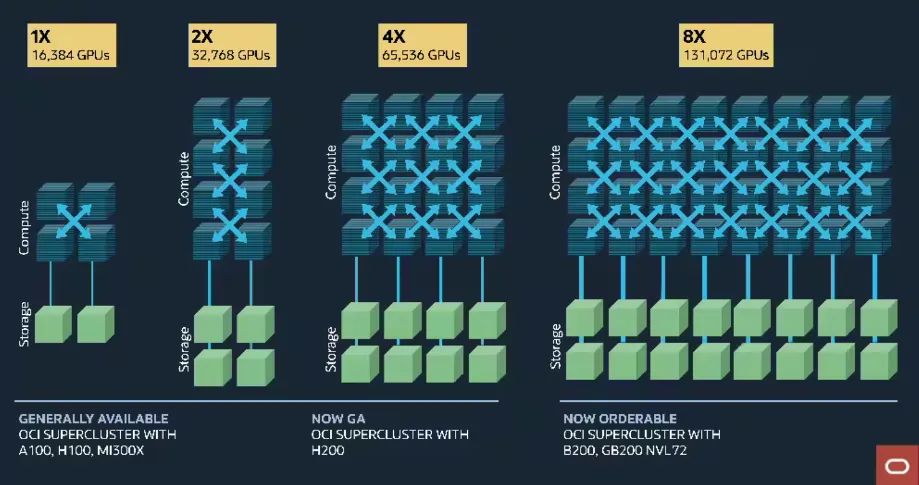

当下,无论是云服务商,还是AI巨头,其AI集群规模均在持续膨胀,网络压力在持续增加。例如,Oracle 云基础设施 (OCI) 正在部署具有 131000 个 Nvidia Blackwell GPU 的集群,这些 GPU 通过 NVLink72 互连。

图三:OCI AI超级集群

横向扩展与纵向扩展网络

如今,依靠传统的互联方案,已经无法满足AI集群所需要的高性能需求,甚至会导致延迟和带宽瓶颈,严重阻碍AI集群的表现。

传统电气互联方案存在致命弱点,那就是距离问题。在较长距离上,信号会出现衰减。并且,在100G甚至即将到来的200G连接中,还会受到单个机箱的限制。随着连接需求超越机箱,扩展到跨机架甚至多机架规模,就需要采用可插拔光学连接。

如今,光学互联网络在AI集群的性能表现上扮演着至关重要的角色。它们直接影响到模型的速度、效率、可扩展性,以及适应不断变化的需求和满足用户需求的能力。

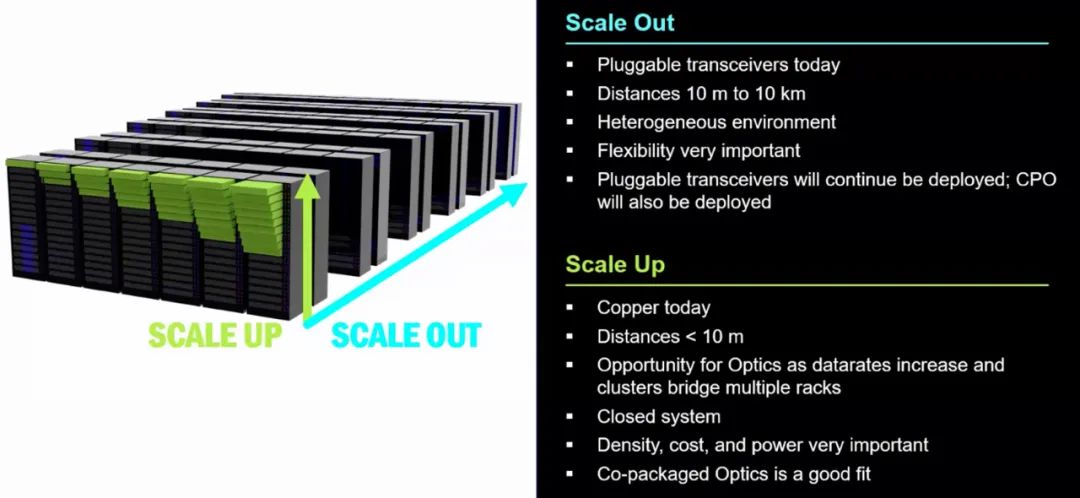

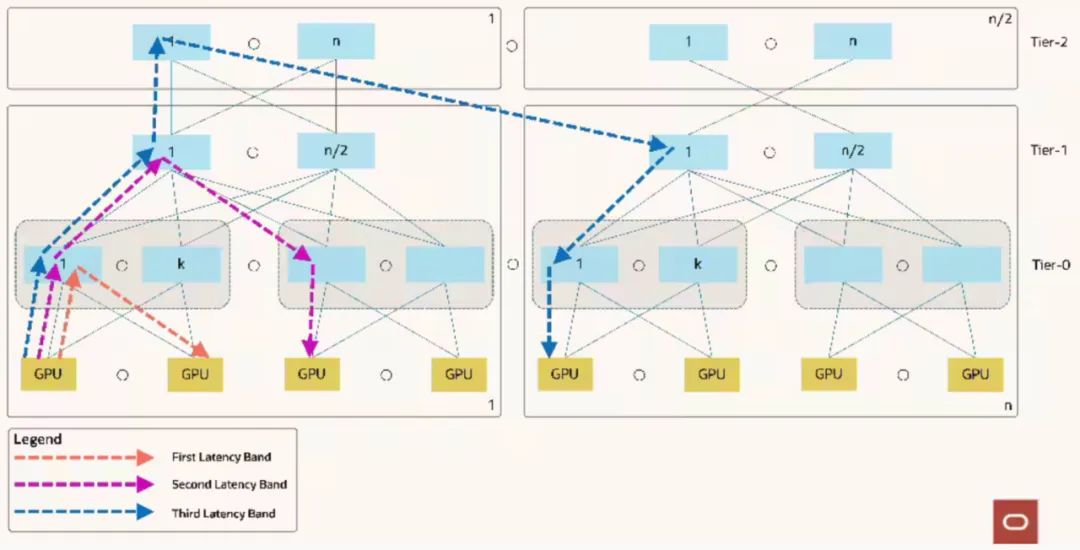

在 AI 数据中心中,基于光学的网络互联主要有两种类型:

- 横向扩展 :光链路跨机架和行连接交换机。

- 纵向扩展 :电气链路连接少量机架内部和之间的 GPU。

图四: 数据中心光学元件

虽然横向扩展网络已经是光学的,但用于纵向扩展网络的光学技术正处于过渡阶段,尚未彻底完成。

横向扩展网络的光学进展

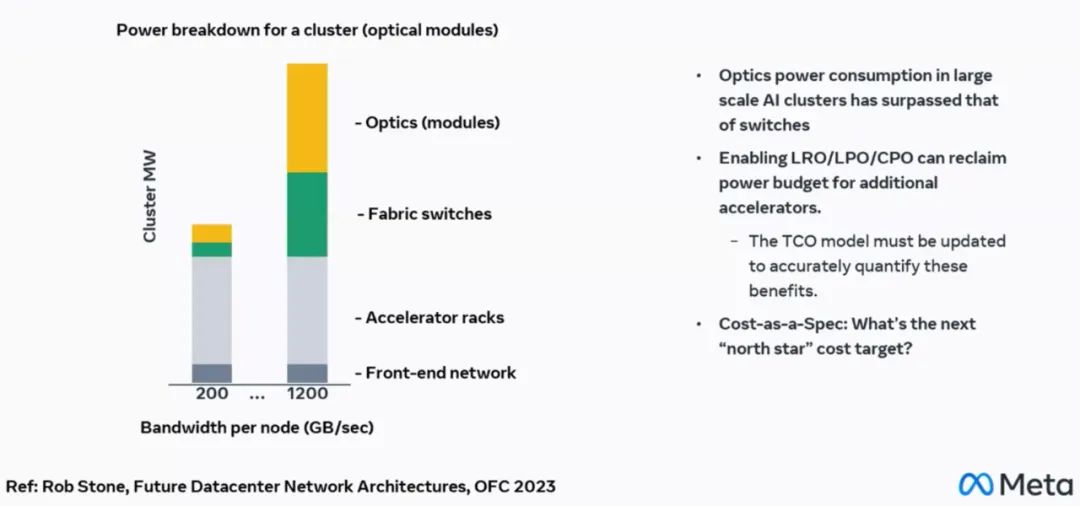

光子学是横向扩展架构的核心。如今,可插拔光收发器支持在 NIC 和交换机之间跨越数十米的数据传输。随着数据速率的升级,这些解决方案面临着越来越大的功耗和性能限制。

Oracle 的 131K-GPU 结构在其横向扩展网络的所有三个级别都使用光链路。然而,传统的可插拔光学器件会消耗大量功率。

图五:Oracle 光学集群网络结构

图六:功耗和 TCO 仍是核心关注点

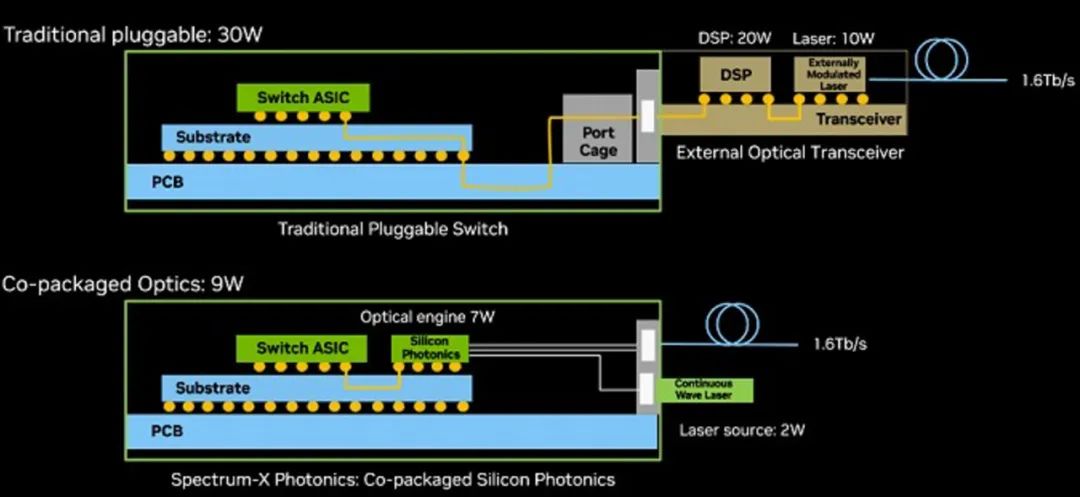

随着横向扩展网络中的数据速率增加以跟上 LLM 的增长和吞吐量需求,网络功率正在超过加速器机架的功率。据 Nvidia 称,从可插拔光学器件转向 CPO(共封装光学器件,Co-Package Optical)可以将光学器件的功率从 30W 大幅降低到 9W,以实现 1.6Tbps 链路。

在 GTC25 上,Nvidia 推出了其首款带 CPO 的横向扩展交换机。节能功能可实现更高的 GPU 密度 — 在相同的数据中心功率范围内,GPU 数量最多可增加 3 倍。

图七:使用 Spectrum-X 光学节省 3.5 倍功耗

可靠性是从铜缆转向光学器件再到 CPO 的关键考虑因素。AI 数据中心的数据量巨大且增长速度很快,就像 iPhone 一样。从统计数据来看,产量和可靠性必须非常高。Google 的平台光学总监表示,每天 0.004% 的链接故障率听起来不错,但对于 1M 链接,则每天有 40 个链接故障。光学解决方案需要设计成非常低的故障率,在非常苛刻的水平上进行测试,并且样品量非常大,以确保生产成功。

在纵向扩展网络中实现 CPO 的途径

纵向扩展互连目前仍基于铜缆。Nvidia 的 Blackwell 架构采用全铜解决方案 NVLink72,在电路板、交换机和机架背板上可以看到广泛的布线。信号频率现在非常高,以至于铜束直接连接到 GPU,绕过了传统的 PCB 走线。

图八:Nvidia 的路线图扩展到 NVLink576,它仍然使用铜缆,但不断升级的数据速率和信号完整性问题最终将需要光学解决方案

然而,铜的局限性正变得越来越明显。Nvidia 的路线图扩展到 NVLink576,它仍然使用铜缆,但不断升级的数据速率和信号完整性问题最终将需要光学解决方案。

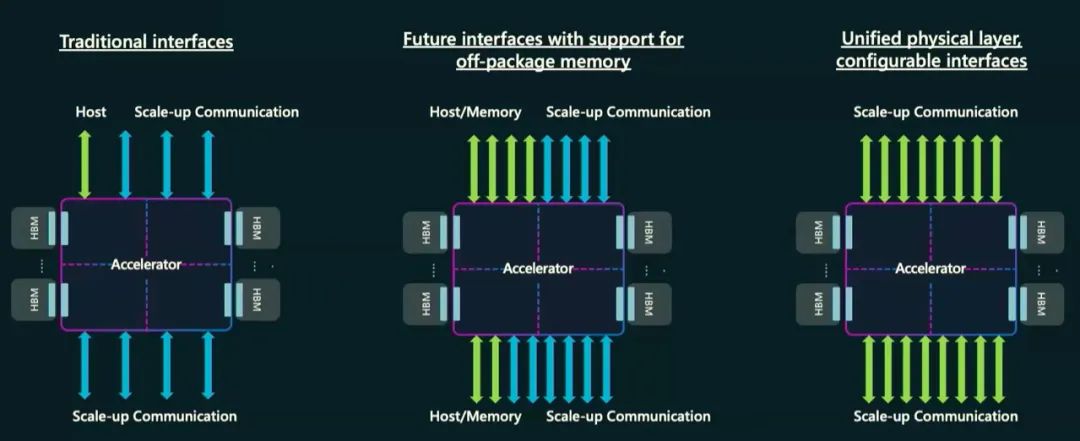

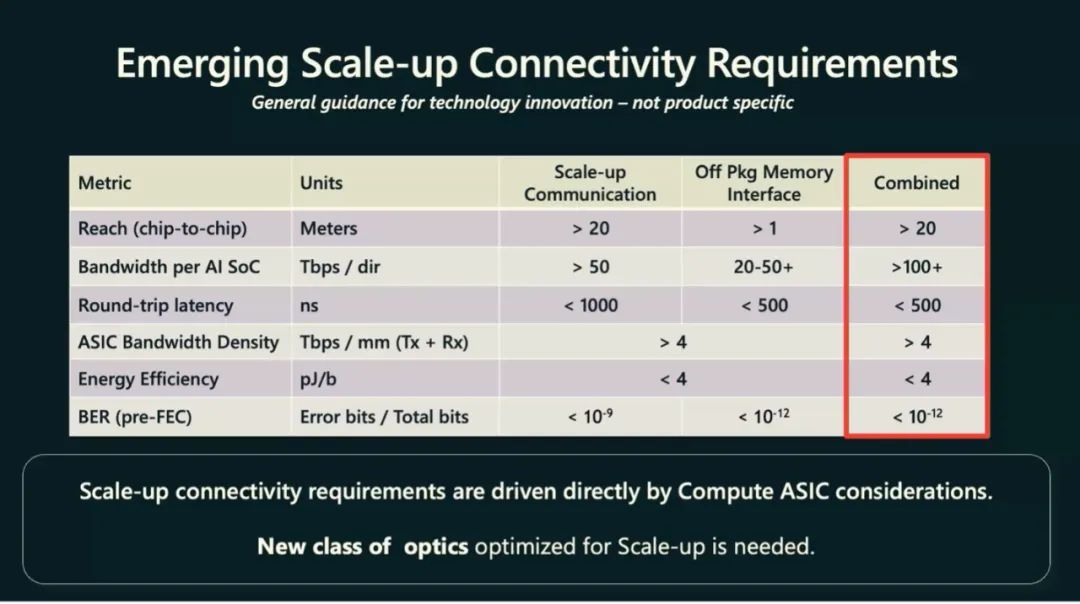

微软也介绍了他们对未来 AI 加速器的 CPO 要求。他们希望使用具有可配置接口的单个物理层来替换现有接口。

图九:新的互连场景需要具有更严格的延迟和可靠性要求的统一接口

新的统一接口需要具有“两全其美”——组合规范是他们正在取代的传统接口中的佼佼者。这使得 CPO 更具挑战性,但增加了市场。

图十: 新统一接口需要比它所取代的传统接口更好。

Nvidia 还提出了其对 CPO 与 AI 加速器集成的要求:

图十一: Nvidia 的 CPO 要求

这些是具有挑战性但可行的要求。 Needham & Company 建议,在 Scale-Up 网络中,首次转向 CPO 将发生在单个 GPU 域内的机架之间,而机架内连接暂时保持铜质。

当前,数据中心AI芯片大部分由台积电生产制造。套基础也深入参与了所有AI相关技术的路线图。在今年4月份,台积电也展示了包括共封装光学器件在内的技术路线图,正在为市场的爆发做好准备。

市场前景分析

光子技术的快速发展,正在为大规模的AI集群带来更加灵活、高性能的网络,以克服互联带宽瓶颈,超越传统互联网络的限制。,满足生成式AI的需求,对于推动AI未来创新的作用不可低估。

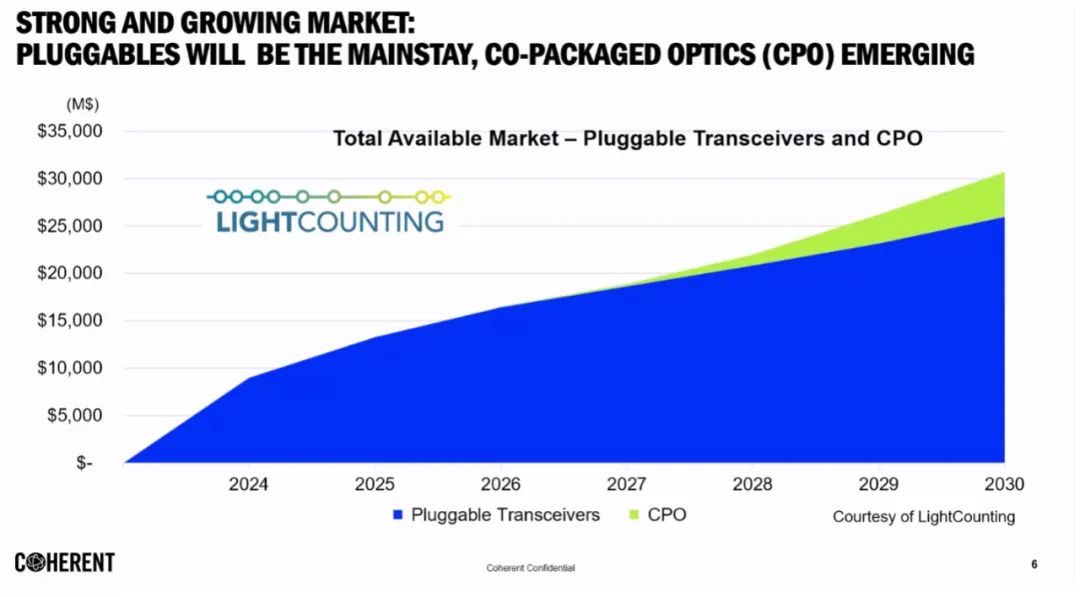

Scale-Up 网络向 CPO 的过渡预计将在未来几年内开始,并在 2030 年代广泛取代可插拔光学器件。到 2030 年,CPO 市场将从目前的零增长到 50 亿美元。Broadcom、Marvell、Ayar Labs、Celestial AI 和 Lightmatter 等早期进入者以及 Coherent 等激光器供应商都将受益。

图十二:CPO 光学器件将2027-2030 年快速增长

光子学不再仅仅支持 AI。它正在成为其大规模增长不可或缺的一部分。到 2030 年代中期,所有互联都将是光学的,并且都将是 CPO。