谷歌最新发布的Gemini Robotics 1.5系列模型,让机器人真正学会了「思考」,还能跨不同具身形态学习技能。这意味着,未来的机器人将成为和人类协作、主动完成复杂任务的智能伙伴。

谷歌又给机器人「换大脑」了!

刚刚,DeepMind发布了针对机器人和具身智能的Gemini Robotics 1.5系列家族模型,专为机器人和具身智能打造的新一代「大脑」。

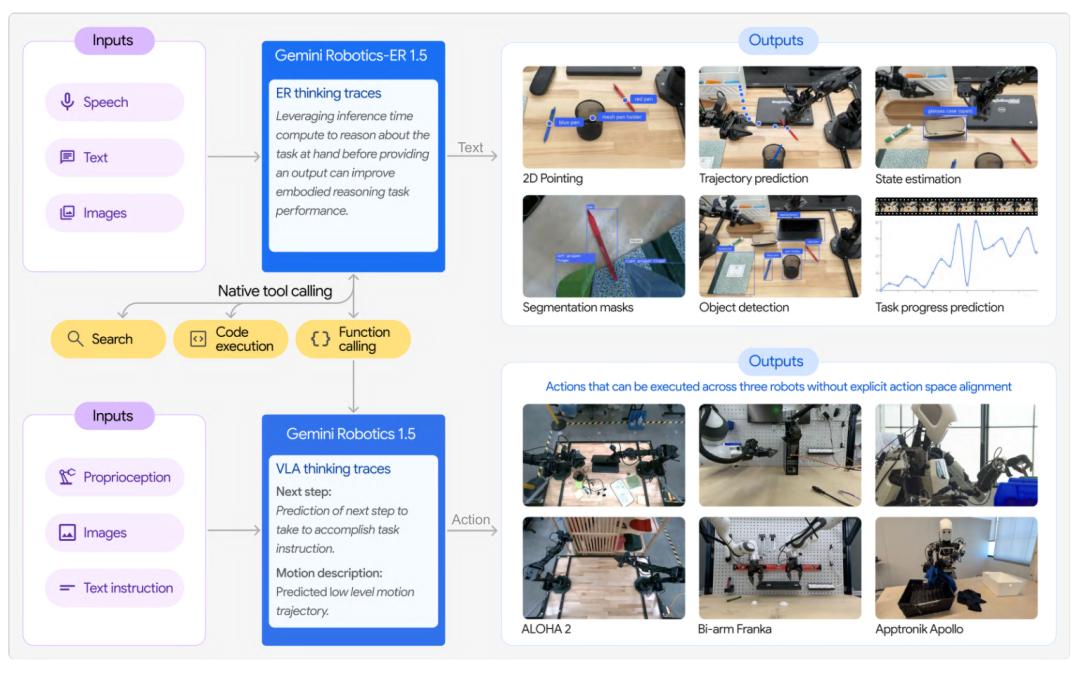

Gemini Robotics 1.5系列包括Gemini Robotics 1.5和Gemini Robotics-ER 1.5。

- Gemini Robotics 1.5,最先进的视觉-语言-行动模型,能将视觉信息和指令转化为机器人的运动指令以执行任务。

- Gemini Robotics-ER 1.5,最强大的视觉-语言模型,能够对物理世界进行推理,直接调用数字工具,并创建详细的多步骤计划来完成任务。

它们结合在一起,就构建出一个强大的智能体框架。

在下面这个1分40秒的视频,谷歌的研究科学家让两个机器人完成了两个不同任务。

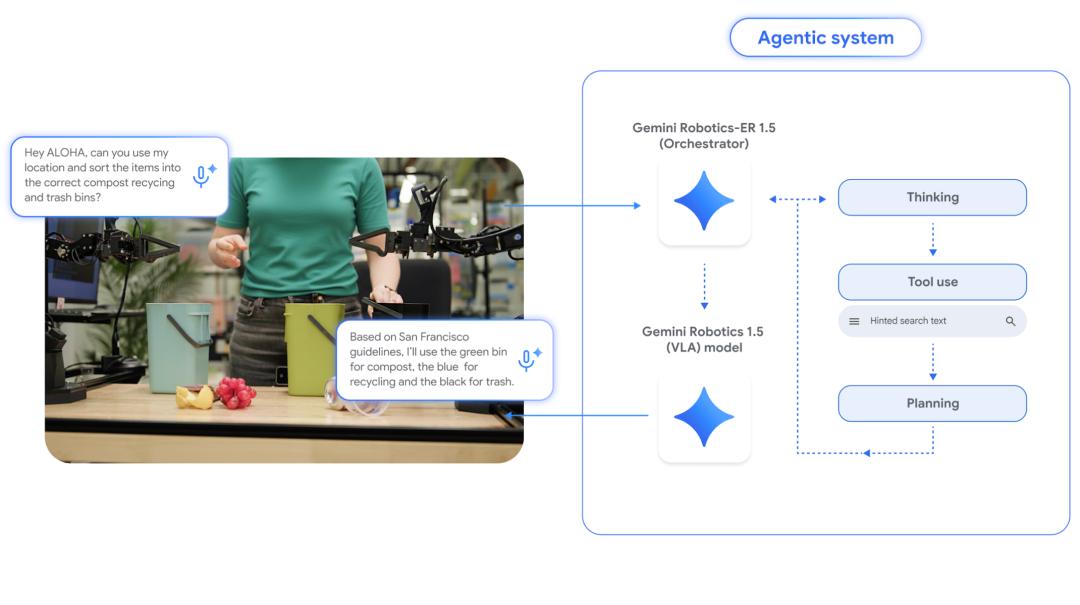

第一个任务是垃圾分类。

请Aloha根据旧金山的垃圾分类标准,把物品分到堆肥(绿桶)、回收(蓝桶)和垃圾(黑桶)里。

Aloha通过查阅规则并观察物品,完成了分类任务。

第二个任务是打包行李。

请Apollo帮忙打包去伦敦旅行的行李,并放入针织帽。

Apollo还主动查询天气,提醒伦敦多天会下雨,并贴心地把雨伞也放进包里。

整体看下来,在最新系列模型的加持下,现在机器人已经越来越有科幻电影里的那味了!

为实体任务开启智能体体验

想象一下,一个机器人不仅能看懂你家客厅的杂物,还能规划、思考并亲手收拾干净。

Gemini Robotics 1.5正是朝这个目标迈出的关键一步。

它让机器人具备「思考后行动」的能力,能在复杂环境中像人类一样理解、推理并完成多步骤任务。

这一突破,有望打开通用机器人的新时代。

Gemini Robotics-ER 1.5擅长在物理环境中进行规划与逻辑决策,拥有顶尖的空间理解能力,支持自然语言交互,可评估任务成功率与进度,并能直接调用谷歌搜索等工具获取信息或使用任何第三方用户自定义功能。

随后,Gemini Robotics-ER 1.5会为Gemini Robotics 1.5提供每一步的自然语言指令,后者则运用其视觉与语言理解能力直接执行具体动作。

Gemini Robotics 1.5还能协助机器人反思自身行为,以更好地解决语义复杂的任务,甚至能用自然语言解释其思考过程——这让它的决策更加透明。

这两款模型均基于核心Gemini模型家族构建,并通过不同数据集进行微调以专精于各自职能。

当它们协同工作时,可显著提升机器人对长周期任务和多样化环境的泛化能力。

先理解「环境」再「行动」

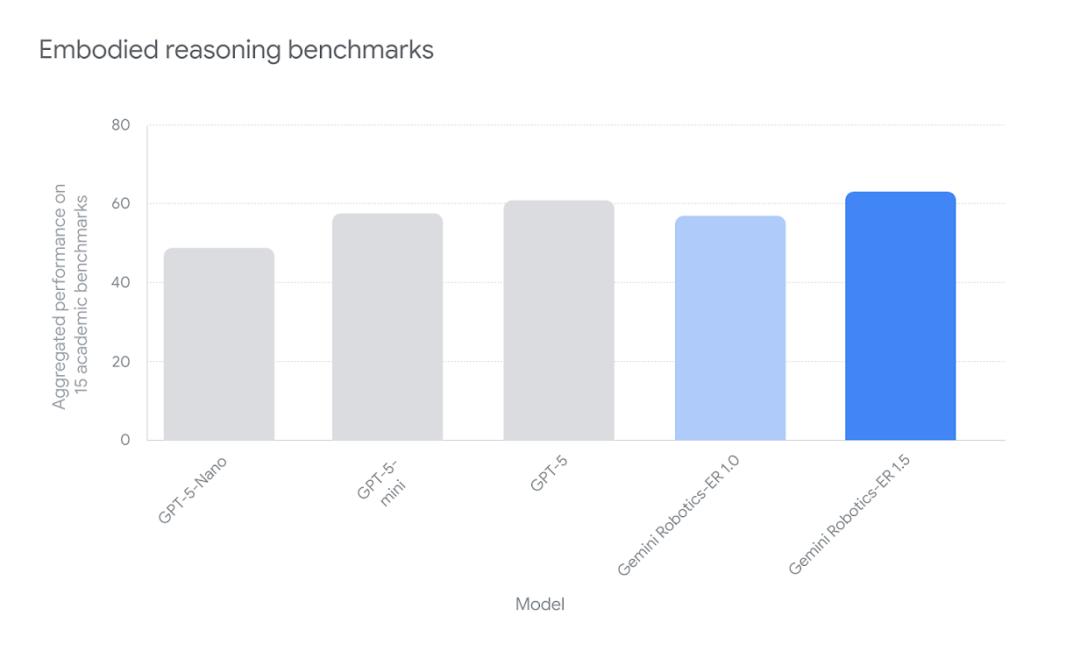

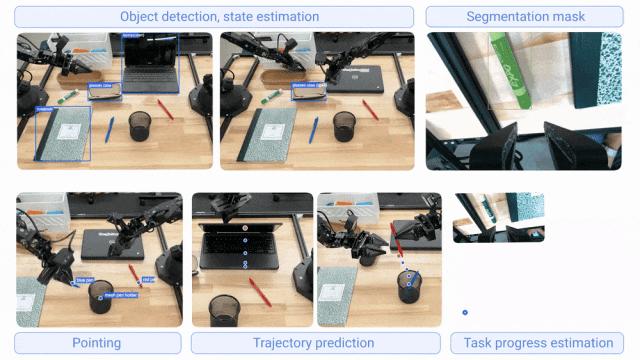

Gemini Robotics-ER 1.5是首个为具身推理优化的思维模型。

它在学术和内部基准测试中均实现了最先进的性能表现。

下面展示了Gemini Robotics-ER 1.5的部分能力,包括物体检测与状态估计、分割掩码、指向识别、轨迹预测以及任务进度评估与成功检测。

三「思」而后「行」

传统上,视觉-语言-动作模型直接将指令或语言规划转化为机器人的运动。

但Gemini Robotics 1.5不仅能翻译指令或规划,如今还能在行动前进行思考。

这意味着它能以自然语言生成内部推理与分析序列,从而执行需要多步骤或更深层语义理解的任务。

在下面这段3分40秒的视频,谷歌的科学家展示了机器人如何去完成更复杂的任务。

比如第一段将不同颜色的水果分类放到对应的盘子里。机器人需要能感知环境、分析颜色并逐步完成动作。

第二段Apollo被要求帮助分类洗衣物和打包物品。它能自主思考并在执行中展现出链式任务规划与反应能力,例如调整篮子来更好地捡起衣物,或对临时变化作出即时反应。

跨越不同形态的具身机器人学习

机器人形态各异、大小不一,具备不同的感知能力和自由度,这使得将从一个机器人学到的动作迁移到另一个机器人变得困难。

Gemini Robotics 1.5展现出卓越的跨具身学习能力。

它能将从一个机器人学到的动作迁移到另一个机器人,无需针对每种新形态专门调整模型。

这一突破加速了新行为的学习进程,助力机器人变得更智能、更实用。

在下面这段2分钟的视频里,谷歌科学家展示了不同「物种」机器人之间如何泛化学习。

在Gemini Robotics 1.5中,一个模型可以跨多个机器人使用。

比如Aloha在衣柜场景中已有经验,而Apollo从未见过,却能通过迁移学习完成开门、拿衣服等全新动作。

这展示了「跨具身学习」的潜力。

未来,不同场景中的机器人(如物流、零售)可互相学习,从而大大加快通用机器人研发的进程。

参考资料:

https://deepmind.google/discover/blog/gemini-robotics-15-brings-ai-agents-into-the-physical-world/