AI 能否被学术会议、期刊的审稿人用于论文评审?

目前,即使是在 AI 领域也尚未形成统一规范。目前全球的几大顶级会议里,ICLR 的规则是使用大模型必须进行披露,CVPR 则规定大模型在任何阶段都不能用于撰写审稿意见。

不过,面对日益膨胀的论文投稿数量,很多时候这件事由不得人类决定。在已经出台了「最严管控规则」的 ICLR 2026 上,有人统计仍有高达五分之一的审稿意见是由大模型一键生成的。

尽管如此,各大会议的审稿周期仍然十分冗长。

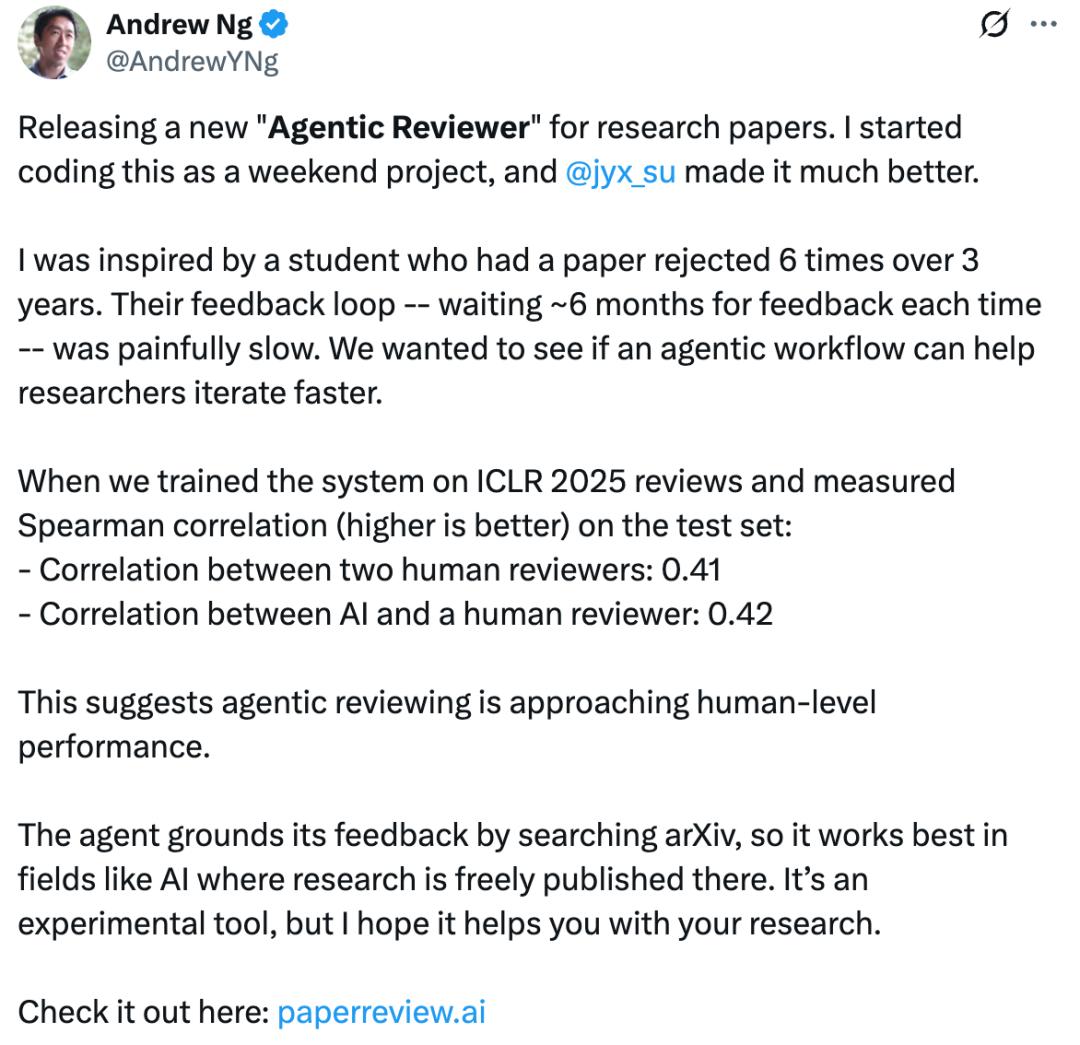

斯坦福大学教授,人工智能著名学者吴恩达已经对日益拉长的审稿反馈周期感到疲惫。

他的一位学生的论文更是「命途多舛」——三年被拒六次,每一次都要等待约六个月的审稿结果。

如此缓慢的反馈循环,不仅影响研究成果发布的进程,更与现在飞速迭代的技术发展周期下对研究效率的要求背道而驰。

既然无法改变论文评审的周期,那么我们能否借助 AI 的强大能力构建一个高效的「论文反馈工作流」,让研究人员在正式投稿前就能获得高质量审稿意见,更快、更有方向地迭代论文内容,从而减少在重大会议和期刊上反复被拒的成本与时间?

为此,吴恩达教授发布了一个全新的面向研究论文的「Agentic Reviewer(智能体审稿人)」。

这个项目最初只是他周末写着玩的一个小工具,后来在博士生 Yixing Jiang 的帮助下,被大幅加强了。

我们在 ICLR 2025 的审稿数据上训练系统,并在测试集上测了 Spearman 相关系数(越高越好):

- 两位人工审稿人之间的相关性:0.41

- AI 与人工审稿人的相关性:0.42

这表明,智能体审稿正在逐步接近人类水平。

现阶段,这个智能体会通过检索 arXiv 的数据来生成有依据的反馈,因此在 人工智能等主要公开发表在 arXiv 上的研究领域上的表现最好。

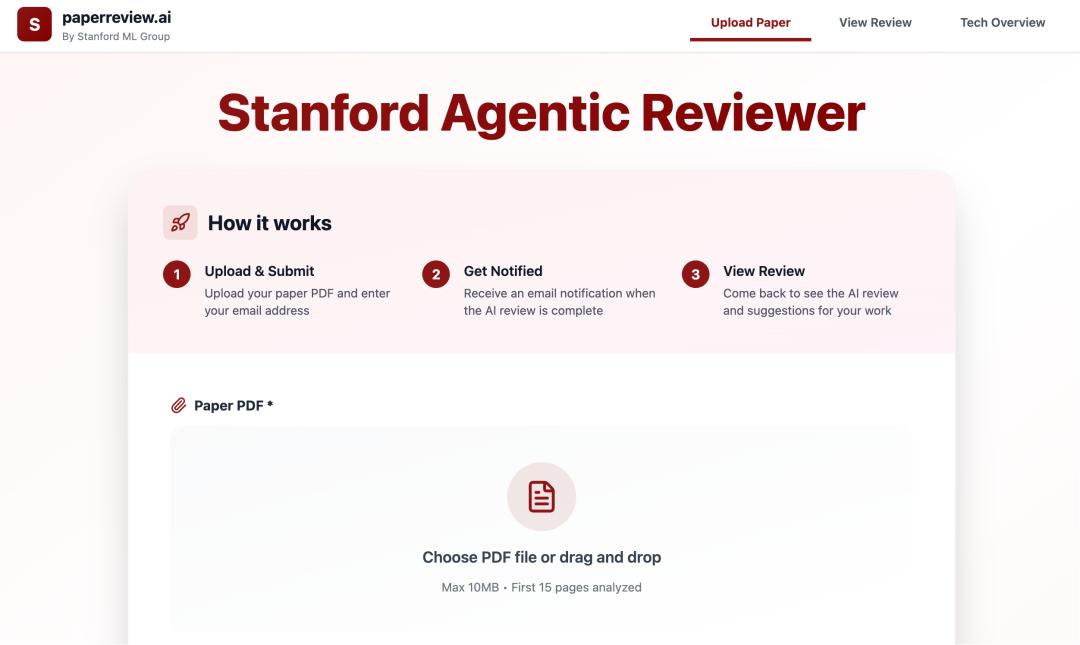

智能体审稿系统链接:https://paperreview.ai/

不过,这个智能体仍处于实验阶段。网友们对这类工具大多抱有积极的态度,希望能够成为真正实用的研究工具。

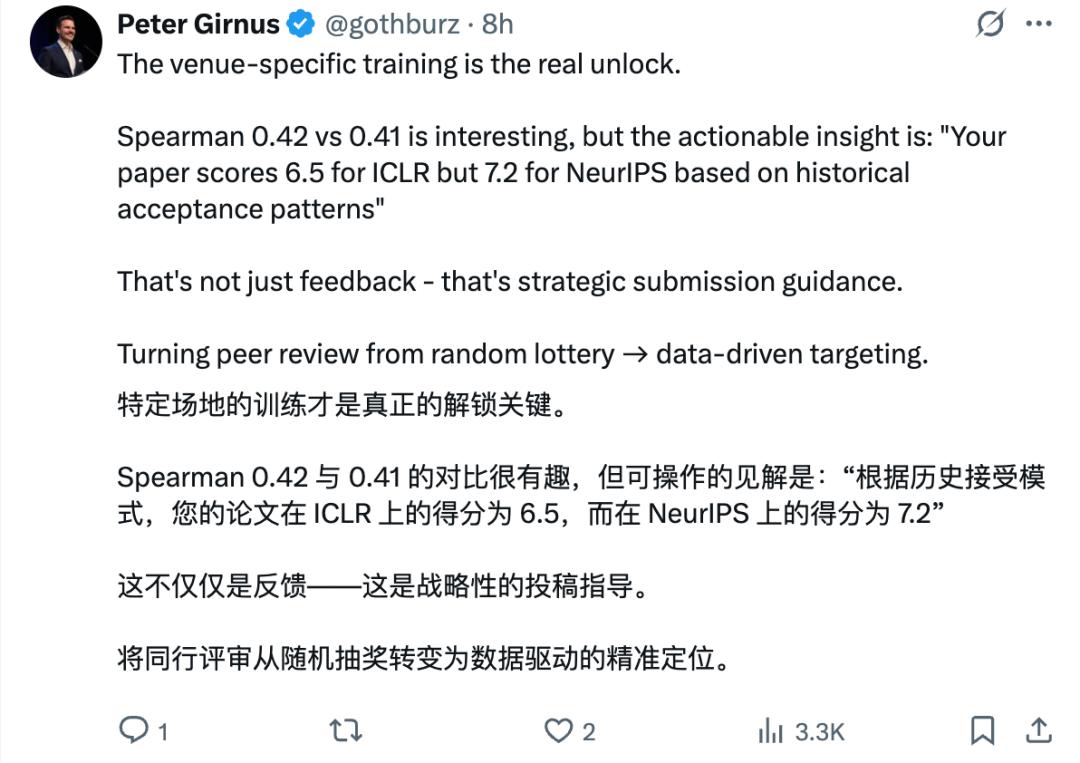

有网友希望智能体审稿人能够具备针对特定会议或期刊场景的评审,甚至给出预估的分数:

AI 智能体能够给科研加速,给人才培养周期加速,是一个推动学术进步的引擎:

不过,也有网友表示担忧,研究者们在发表成果之前先过一遍 AI 的评审,会不会导致学术多样性的下降?

研究学者有了趁手的 AI 评审参考工具,审稿人也用 AI 生成审阅意见,学术成果的评审体系是否已经到了产生变革的时间?

未来,AI 作为辅助工具,将会以怎样的方式推动学术研究发展,我们仍不得而知。