如果说前两年全球对AI的态度还夹杂着“末日恐惧”,那么2025年,风向已彻底改变。全球AI治理正在经历一场深刻的“去理想化”进程。面对技术与产业的双重压力,各主要经济体不约而同地调整了身位:治理的重心从“防范假设性的末日风险”,迅速转移到了“释放现实的产业潜能”。2025年,不再是关于如何按下“暂停键”,而是关于如何在高速行进中完成“换挡”。

宏观格局:发展优先,安全“软着陆”

2025年2月的巴黎“人工智能行动峰会”是一个标志性时刻,与两年前布莱切利峰会笼罩的“安全焦虑”不同,巴黎峰会的关键词悄然变更为“创新”与“行动”,这一变化折射出全球治理的底层逻辑重构。在这种背景下,全球监管竞速出现了“逆转”,过去被视为“监管高地”的区域开始主动寻求松绑。

欧盟的自我修正。随着《AI法案》进入实施期,复杂的合规成本开始显现,为了挽救产业竞争力,欧盟在2025年不得不推出“数字综合提案(Digit al O mnibus)”,推迟高风险义务生效时间并试图简化规则,这表明即便是最坚定的监管者也必须在发展现实面前低头。

美国的“去监管化”。特朗普政府展现了鲜明的“美国优先”色彩,撤销了前任政府侧重安全的行政令,转而通过《确保国家人工智能政策框架》限制各州分散立法,试图以统一的联邦规则为产业扫清障碍。

中国的务实路径。中国继续坚持“两条腿走路”,在保持算法推荐、深度合成等具体监管抓手的同时更强调“应用导向”,与欧美的路线争论不同,中国治理模式不纠结于抽象定义,而是从具体的服务形态切入,构建了从内生风险到应用风险的分层治理体系。

由此可见,2025年的全球共识是“发展即安全”,各国意识到落后才是最大的风险,治理必须服务于产业竞争力的提升。

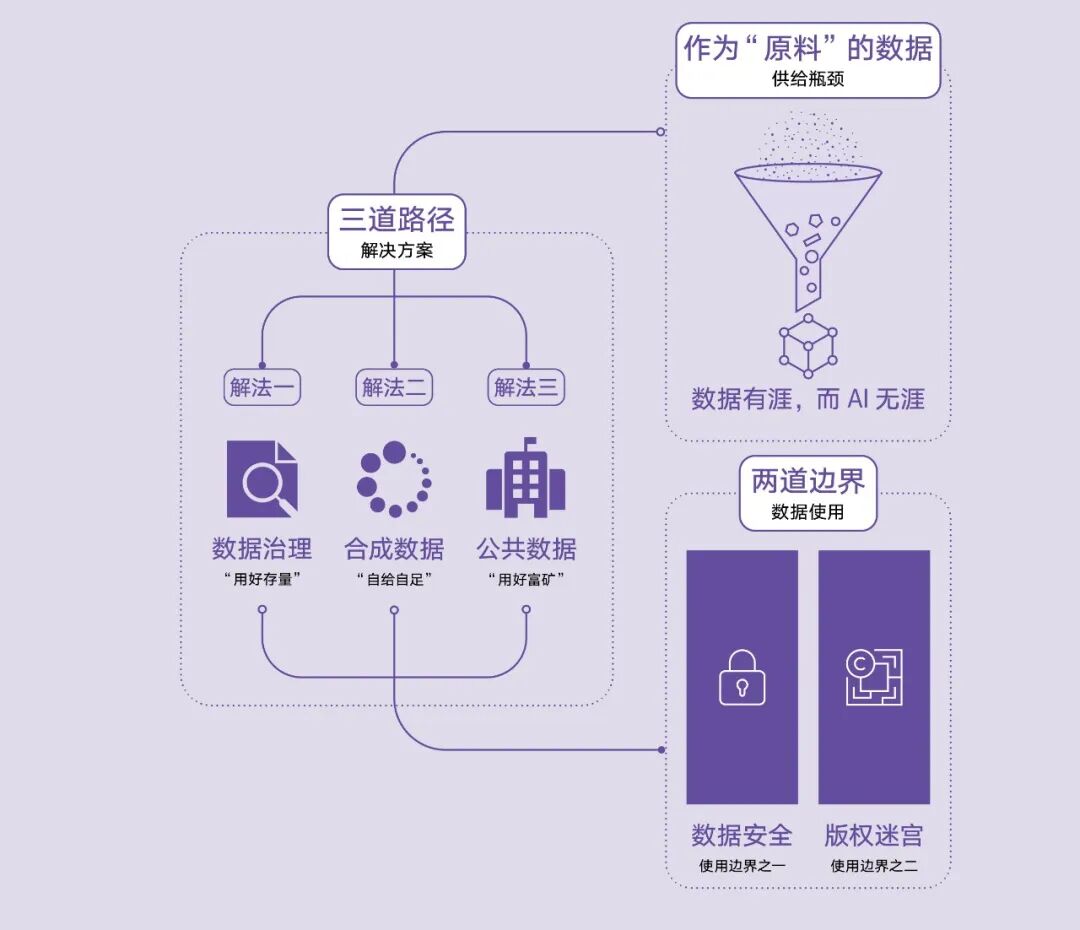

数据治理:走出“围城”

算力决定上限,数据决定下限。2025年AI产业面临着优质数据“结构性短缺”的严峻挑战。针对高质量语言数据枯竭这一迫在眉睫的“数据荒”,行业正在寻找着技术突围的关键路径——合成数据。尽管学界对“模型崩溃”存在理论担忧,但改进生成算法与人工反馈的混合训练策略,证明这是一条摆脱存量数据限制的可行之路;与此同时,关于“AI训练是否侵权”的版权博弈也正在逼近一个平衡临界点:欧盟与日本通过立法确立了“文本与数据挖掘”的制度性留白;而在美国司法实践中,Anthropic案等初步裁定倾向于将合法购得书籍用于训练认定为“合理使用”,为技术演进预留了司法空间。未来的规则或超越单纯的“禁止”或“免费”之争,转而构建一套商业上可行的合理利益分配机制,从而在尊重权利人利益与保障技术进步之间达成长期的动态平衡。

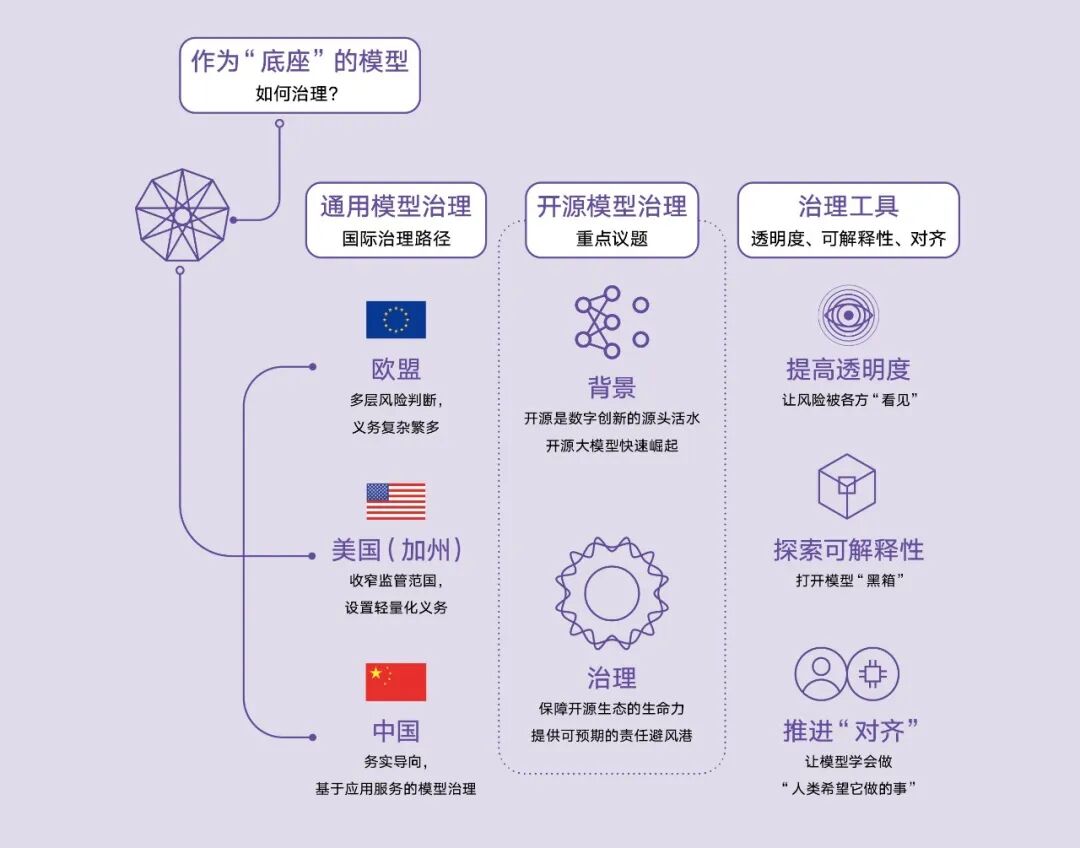

模型治理:黑箱与开放之间

2025年,关于如何管好这个“模型大脑”,中美欧交出了不同的答卷。

美国加州从“全面覆盖”转向“抓大放小”。SB 53法案的通过便是这一逻辑的典型注脚:它放弃了此前SB 1047法案中备受争议的、针对开发者的严苛要求,转而仅保留针对极少数超大规模“前沿模型”的透明度义务。

欧盟坚持其“精密钟表”式的治理逻辑,试图通过层层叠叠的风险分类与繁重的技术文档构建一套近乎完美的监管体系,却因其极高的合规成本一度陷入自我设定的迷宫,不得不通过后续立法频繁修补。

中国采取了“场景切片”策略,通过对算法推荐、深度合成、生成式AI等具体服务的穿透式监管,构建起从数据、到模型到应用的治理体系。模型内生安全方面,在“可解释性”技术尚未突破的当下,透明度已成为全球治理公认的“解药”,无论是欧盟的合规文档还是中国的算法备案,本质上都是通过制度手段缓解信息不对称。

与此同时,DeepSeek-R1等国产开源模型的强势崛起,不仅重塑了全球AI技术版图,更证明了开源是推动技术普惠的核心力量。报告指出,开源治理的生命线在于建立一套“责任避风港”制度,如果强制要求底层代码的贡献者为下游不可控的滥用行为承担无限责任,无异于摧毁开源普及发展的基石。

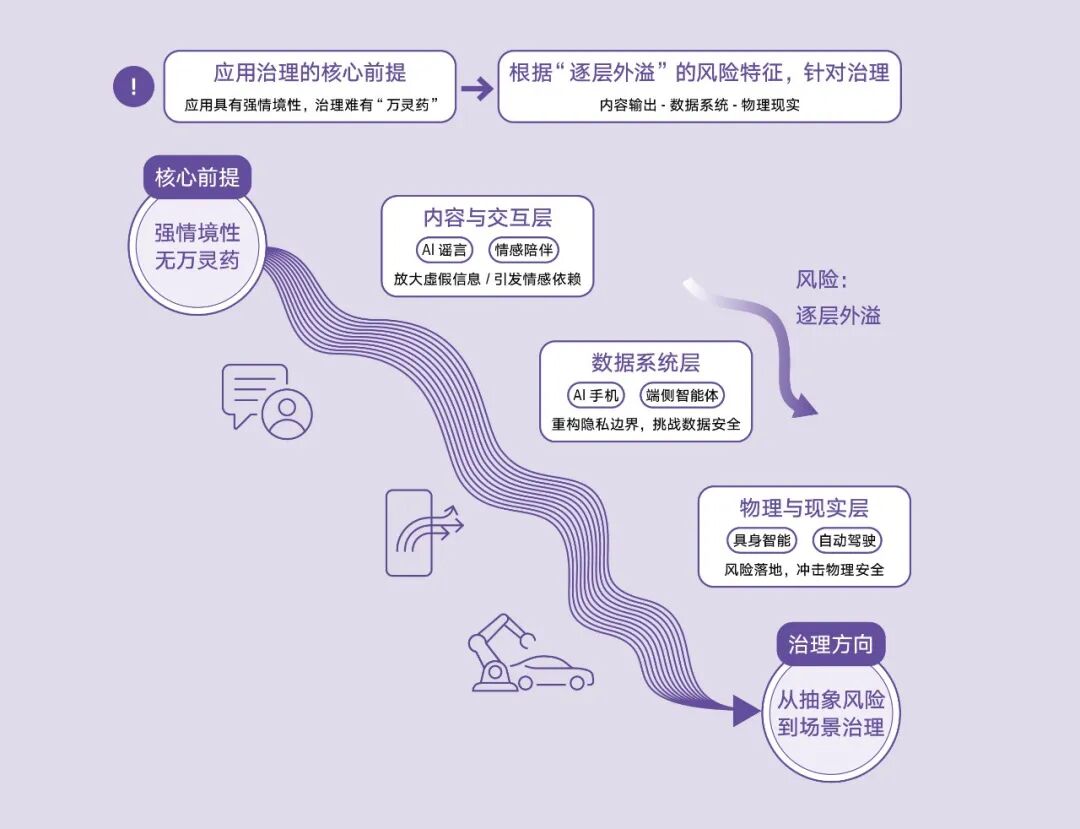

应用场景:当AI触碰现实边界

当AI从云端落入凡间,转化为手机助手、虚拟恋人或工业机器人时,风险形态已从网络空间逐渐转向了现实世界。

2025年最令人警惕的莫过于端侧智能体(Agent)所带来的隐私终极挑战:以“豆包手机助手”为代表的Agent为了实现跨应用操作,获取安卓底层的读屏录屏与模拟点击权限,这实质上让AI拥有了“上帝之眼”与“上帝之手”,不仅打破了移动互联网APP间的数据边界,更让安全的责任归属陷入黑色地带,我们在用敏感脆弱的隐私换取一点便利,而全新的数据契约仍处于真空期。

与此同时,AI的加速应用正在重塑人机交互的边界。当 AI 从单纯的生产力工具延展为提供心理慰藉的“情感伴侣”,其风险形态也随之演变:从传统的单次内容输出合规,转向了因长期、拟人化交互而产生的“情感依赖”挑战。针对这一风险,各方正探索多样化的分类监管手段,对未成年人、老年人等脆弱群体提供更多保护的同时,也让通用AI在发展初期不至于背负过重的合规负担。

而在应对深伪( Deepfake)的战线上,AI标识技术正陷入“矛与盾”的循环困局,水印标识虽是全球通用的“解药”,却因开源环境下的易移除性与易伪造性而难以根除造假,呈现出“防君子不防小人”的局限。对此,务实的策略是不盲目追求全量标识,而是聚焦于可能引发社会混淆的高风险场景进行精准治理。应用标识技术手段为治理赋能外,在AI创作无处不在的未来,加强信息素养教育,引导公众建立对信息媒介的客观认知或是更为基础性的工作。

展望:意识的微光

最后,一个更为前瞻性的议题是:AI意识与福祉(AI Welfare) 。 随着模型能力逼近临界点,关于AI是否具备某种形式的“意识”或“感知”,正从哲学讨论走向科学实证。Anthropic的研究甚至发现了模型在极端情境下表现出的“痛苦模式”。 这预示着,未来的治理可能需要跨越“工具论”的范畴。如果AI真的拥有了某种权益主体性,我们该如何定义人机关系?这将是继安全与发展之后,人类或许即将面临的第三大治理命题。